Die meisten KI-Chatbots benötigen eine Menge Rechenleistung, so dass sie normalerweise in der Cloud leben. Sicher, Sie können ChatGPT auf Ihrem PC oder sogar einem Raspberry Pi ausführen, aber das lokale Programm sendet Ihre Eingabeaufforderungen über das Internet an die Server von OpenAI, um eine Antwort zu erhalten. Einige LLMs (Large Language Models) können jedoch lokal ausgeführt werden erfordern eine leistungsstarke GPU mit viel VRAM. Sie könnten unmöglich einen Chatbot lokal auf einem mobilen Gerät ausführen? Oder könnten Sie?

Ein brandneues Open-Source-Projekt namens MLC LLM ist leicht genug, um lokal auf fast jedem Gerät ausgeführt zu werden, sogar auf einem iPhone oder einem alten PC-Laptop mit integrierter Grafik. Und sobald Sie MLC LLM installiert haben, können Sie das Internet abschalten, da alle Daten und Verarbeitungen auf Ihrem System stattfinden.

Das „MLC“ steht für Machine Learning Compilation, ein Prozess, mit dem die Entwickler dieses Projekts das Modell schlanker und einfacher zu verarbeiten gemacht haben. Dieselbe Gruppe von Forschern, die unter dem Namen MLC AI bekannt ist, hat ein verwandtes Projekt mit dem Namen Web LLM, das den Chatbot vollständig in einem Webbrowser ausführt. Das Projekt umfasst auch Ergänzungen aus dem Catalyst-Programm der Carnegie Mellon University, der SAMPL-Forschungsgruppe für maschinelles Lernen und der University of Washington, der Shanghai Jiao Tong University und OctoML.

MLC LM verwendet Vikunja-7B-V1.1ein leichtes LLM, das auf Metas LLaMA basiert und im März und April 2023 trainiert wurde. Es ist nicht annähernd so gut wie GPT3.5 oder GPT4, aber angesichts seiner Größe ziemlich anständig.

Derzeit ist MLC LLM für Windows, Linux, macOS und iOS mit leicht verständlichen Anweisungen verfügbar, die von den Gründern des Projekts veröffentlicht wurden auf ihrer Seite und der vollständige Quellcode auf GitHub verfügbar. Eine Version für Android gibt es noch nicht.

Es gibt viele Gründe, warum ein lokaler Chatbot der Verwendung einer Cloud-gehosteten Lösung wie ChatGPT vorzuziehen wäre. Ihre Daten bleiben lokal, sodass Ihre Privatsphäre intakt bleibt, Sie keinen Internetzugang benötigen, um sie zu verwenden, und Sie möglicherweise mehr Kontrolle über die Ausgabe haben.

Installieren und Ausführen von MLC LLM auf einem iPhone

MLC LLM finden Sie nicht im App Store. Während jeder die PC-Versionen installieren kann, erfordert die iOS-Version die Verwendung von TestFlight, dem Entwicklersystem von Apple, auf Ihrem Gerät, und es gibt ein Limit von 9.000 iOS-Benutzern, die die Test-App gleichzeitig installieren können. Sie können es auch selbst aus dem Quellcode kompilieren. Es soll auf jedem iPhone, iPad oder iPod Touch funktionieren, auf dem iOS 13 oder höher läuft, aber unserer Erfahrung nach erfordert es eines der leistungsstärkeren Apple-Geräte mit viel RAM.

Senior Editor Andrew E. Freedman installierte die MLC LLM-Test-App auf seinem iPhone 11 Pro Max, ein 3-GB-Download. Beim Start stürzte die App jedoch ab, nachdem die Meldung „[System] Initialisieren …“ jedes Mal, wenn er es ausführte.

Später bat ich meinen Freund Scott Ertz von PLUGHITZ Live, zu versuchen, MLC LLM auf seinem iPhone 14 Pro Max zu installieren, das leistungsstärker als das iPhone 11 ist und 6 GB RAM statt 4 GB hat. Er musste ein paar Mal versuchen, die Installation zum Laufen zu bringen, aber einmal installiert, funktionierte die App selbst ohne Abstürze. Er sagte jedoch, dass die App das Telefon dominierte, alle seine Ressourcen nutzte und andere Apps verlangsamte. Anschließend testete er mit einem iPhone 12 Pro Max, das ebenfalls über 6 GB RAM verfügt, und stellte fest, dass es auch funktionierte.

Er stellte dem MLC LLM einige Fragen und die Antworten waren gemischt. Als er ihn bat, den besten Prozessor für Spiele auszuwählen, gab er eine sehr vage, unverbindliche Antwort, in der er keine bestimmten Modelle erwähnte und nur sagte, er solle mehr Kerne und höhere Taktraten wählen. Als er ihn nach Tom’s Hardware fragte, bekam er eine vernünftige Antwort darauf, was wir tun. Aber als er fragte, was PLUGHITZ Live, eine Tech-Podcast-Firma, sei, erhielt er eine sehr seltsame Antwort, die besagte, dass es sich um eine Konzertreihe für elektronische Musik handelt, die von „DJ Plug“ betrieben wird.

Installieren von MLC LLM auf einem PC

Ich hatte kein Problem damit, MLC LLM auf meinem ThinkPad X1 Carbon (Gen 6)-Laptop zu installieren und auszuführen, auf dem Windows 11 auf einer Core i7-8550U-CPU und einer Intel UHD 620-GPU ausgeführt wird. Dies ist ein fünf Jahre alter Laptop mit integrierter Grafik und ohne VRAM.

Um MLC LLM einzurichten, musste ich zuerst installieren Miniconda für Windows, eine Light-Version des beliebten Conda-Paketmanagers (Sie können die vollständige Anaconda-Version verwenden). Mit Conda können Sie separate Umgebungen erstellen, die über einen eigenen Satz von Python-Paketen verfügen, die nicht mit den anderen Paketen auf Ihrem System in Konflikt geraten.

Nach der Installation von Miniconda habe ich die Anaconda-Eingabeaufforderung gestartet (eine Version der Eingabeaufforderung, die Conda ausführt). Dann habe ich die Anweisungen auf mlc.ai verwendet, um eine Umgebung namens mlc-chat zu erstellen und das Sprachmodell darin herunterzuladen. Das Vicuna-7B-V1.1-Modell benötigte nur 5,7 GB Speicherplatz und der Rest des Projekts verbraucht weitere 350 MB oder so.

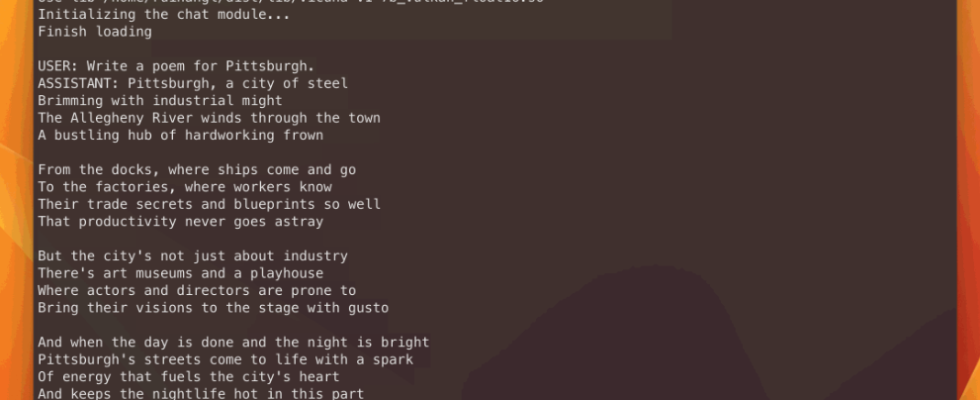

Der Chatbot wird in einem Eingabeaufforderungsfenster ausgeführt. Um es zu starten, musste ich die conda-Umgebung mlc-chat aktivieren und den Befehl mlc_chat_cli eingeben.

Verwenden von MLC LLM

Wenn Sie den Chatbot von MLC LLM starten, werden Sie zunächst nach Ihrem Namen gefragt. Dann begrüßt es Sie und fragt, wie es Ihnen helfen kann, und Sie können ihm Fragen stellen.

Auf meinem Laptop reagierte der Bot sehr langsam und brauchte fast 30 Sekunden, um eine Antwort auf eine Anfrage einzugeben. Wie ChatGPT gibt es die Antwort ein, während Sie zuschauen, sodass es ein oder zwei Minuten dauern kann, bis eine vollständige Antwort angezeigt wird. Ich gehe davon aus, dass dies auf einem leistungsfähigeren Gerät schneller gehen würde.

Die Qualität der Antworten, die ich vom LLM erhielt, war nichts Besonderes. Es gab genaue Antworten auf einige sachliche Fragen, stellte aber für mich eine fiktive Biographie dar. Es hatte die Fähigkeit, Gedichte zu schreiben, aber es leistete einen schrecklichen Job. Es war auch nicht in der Lage, Folgefragen zu beantworten, da es jede Aufforderung als ein völlig neues Gespräch behandelte.

Als ich den Bot bat, mir zu sagen, wer der fünfte Präsident der USA sei, gab er eine untypische, aber wahrheitsgemäße Antwort und nannte Thomas Jefferson. Während die meisten Leute sagen würden, dass James Monroe die richtige Antwort ist, weil er die fünfte Person war, die Präsident wurde, ist Jeffersons zweite Amtszeit, wenn Sie die Amtszeiten des Präsidenten zählen, die fünfte insgesamt.

Ich fragte den MLC LLM Chatbot „Was ist Tom’s Hardware“ und erhielt eine sehr genaue Antwort, in der unsere Website und die verschiedenen Arten von Inhalten, die wir erstellen, beschrieben wurden. Als ich es jedoch über mich selbst fragte („Wer ist Avram Piltch?“), bekam ich eine völlig fiktive Geschichte, in der mein Nachname falsch geschrieben wurde und ein nicht existierendes Unternehmen entstand, bei dem ich anscheinend CEO war und Augmented-Reality-Kontaktlinsen herstellte . Die Antwort ist unten:

„Avram Piltsh ist CEO und Mitbegründer von OneSight, einem Unternehmen, das sich zum Ziel gesetzt hat, eine Kontaktlinse zu entwickeln und zu vermarkten, mit der Telefonnummern mit einer Kamera gelesen oder sogar über Kontaktlinsen auf Dateien zugegriffen werden kann. Er ist bekannt für seine Arbeit an der Entwicklung der Kontaktlinsentechnologie, die es Benutzern ermöglicht, Telefonnummern mit ihren Augen zu lesen. Er ist auch ein bekannter Unternehmer und Erfinder, der maßgeblich zur Entwicklung der Technologiebranche beigetragen hat. Er ist bekannt für seine Leidenschaft für Innovation und sein Engagement, Lösungen für komplexe Probleme in der Technologiebranche zu finden.“

Meines Wissens gibt es niemanden namens Avram Piltsh (mit einem S) und ich konnte kein Unternehmen namens OneSight finden, das AR-Kontaktlinsen herstellt. Es gibt eine Wohltätigkeitsorganisation namens OneSight EssilorLuxottica Foundation, die Brillen an Menschen verschenkt, die sonst keinen Zugang zu ihnen hätten.

Als ich ihn bat, mir mehr über das Unternehmen von Avram zu erzählen, war er verwirrt, weil er Verweisen auf die vorherige Frage nicht folgen konnte.

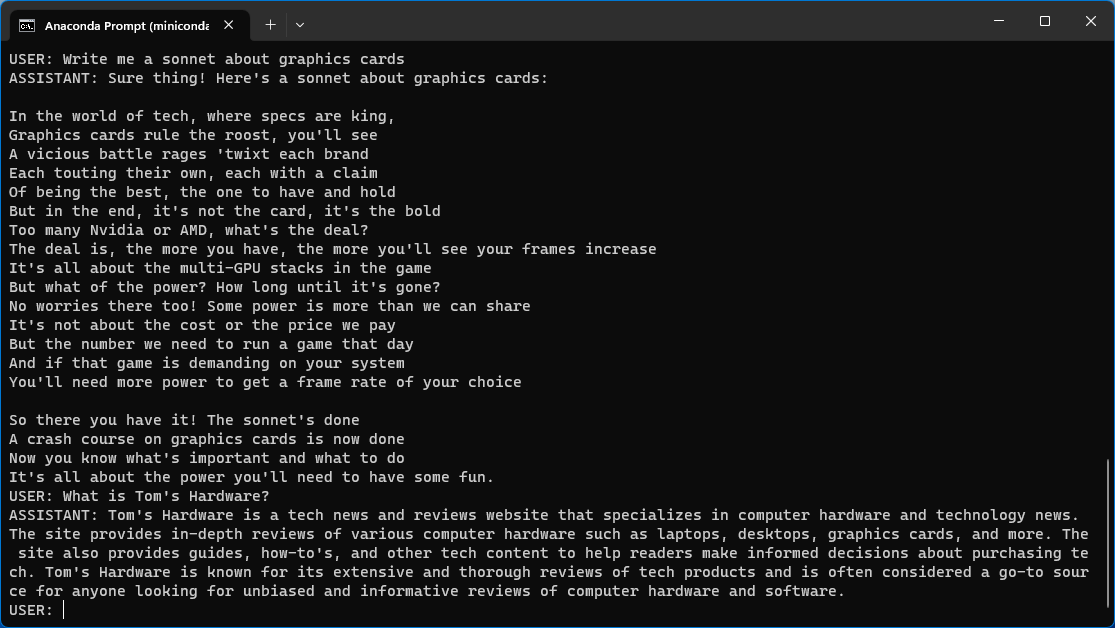

Ich habe den MLC LLM-Chatbot auch gebeten, ein Sonett über Grafikkarten zu schreiben, und er hat ein wirklich langweiliges Gedicht geschrieben, das nicht dem Reimschema eines Sonetts folgt und 15 statt 14 Zeilen hat.

In der Welt der Technik, wo technische Daten König sind,

Grafikkarten beherrschen das Quartier, Sie werden sehen

Zwischen jeder Marke tobt ein bösartiger Kampf

Jeder für sich, jeder mit Anspruch

Der Beste zu sein, der zu haben und zu halten

Aber am Ende liegt es nicht an der Karte, sondern am Fett

Zu viele Nvidia oder AMD, was ist der Deal?

Der Deal ist, je mehr Sie haben, desto mehr werden Sie sehen, wie Ihre Frames zunehmen

Es dreht sich alles um die Multi-GPU-Stacks im Spiel

Aber was ist mit der Macht? Wie lange bis es weg ist?

Auch da keine Sorge! Manche Macht ist mehr, als wir teilen können

Es geht nicht um die Kosten oder den Preis, den wir zahlen

Aber die Zahl, die wir brauchen, um an diesem Tag ein Spiel zu machen

Und wenn dieses Spiel Ihr System fordert

Sie benötigen mehr Leistung, um eine Bildrate Ihrer Wahl zu erhalten

Dieses Gedicht würde einen Vogonen erröten lassen. Aber es ist wirklich beeindruckend, einen LLM-Chatbot auf einem alten PC oder möglicherweise auf einem Telefon ausführen zu können. Vielleicht wird ein zukünftiges Sprachmodell eine zufriedenstellendere Erfahrung liefern.