Wie viele der besten und schlechtesten Ideen der Welt wurde auch der Plan der MIT-Forscher zur Bekämpfung von KI-generierten Deepfakes ausgebrütet, als einer von ihnen ihre Lieblings-Nicht-Nachrichtensendung sah.

In der Folge von The Daily Show vom 25. Oktober mit Trevor Noah, Chief Technology Officer von OpenAI, Mira Murati sprach KI-generierte Bilder an. Obwohl sie den KI-Bildgenerator DALL-E 2 von OpenAI wahrscheinlich ausführlich diskutieren könnte, war es kein sehr tiefgründiges Interview. Schließlich wurde es für all die Leute herausgegeben, die wahrscheinlich wenig bis gar nichts von KI-Kunst verstehen. Trotzdem bot es ein paar Nuggets zum Nachdenken. Noah fragte Murati, ob es eine Möglichkeit gebe, sicherzustellen, dass KI-Programme uns nicht in eine Welt führen, „in der nichts real ist und alles, was real ist, nicht?“.

Letzte Woche sagten Forscher des Massachusetts Institute of Technology, sie wollten diese Frage beantworten. Sie entwickelten ein relativ einfaches Programm, das Datenvergiftungstechniken verwenden kann, um Pixel in einem Bild im Wesentlichen zu stören, um unsichtbares Rauschen zu erzeugen, wodurch KI-Kunstgeneratoren effektiv unfähig werden, realistische Bilder zu erzeugen Deepfakes basierend auf den Fotos, die sie gefüttert werden. Aleksander Madry, ein Computerprofessor am MIT, arbeitete mit dem Forscherteam an der Entwicklung des Programms und veröffentlichte ihre Ergebnisse auf Twitter und seinen Blog des Labors.

Anhand von Fotos von Noah mit dem Daily Show-Comedian Michael Kosta zeigten sie, wie dieses nicht wahrnehmbare Rauschen im Bild einen KI-Bildgenerator eines Diffusionsmodells daran hindert, ein neues Foto unter Verwendung der Originalvorlage zu erstellen. Die Forscher schlugen vor, dass jeder, der plant, ein Bild ins Internet hochzuladen, sein Foto durch sein Programm laufen lassen und es im Grunde gegen KI-Bildgeneratoren immunisieren könnte.

G/O Media kann eine Provision erhalten

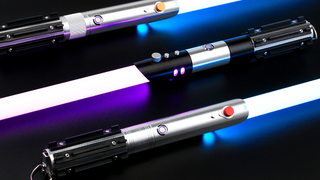

*Lichtschwert summen*

SabresPro

Für den Star Wars Fan mit allem.

Diese Lichtschwerter werden von Neopixeln angetrieben, LED-Streifen, die innerhalb der Klingenform verlaufen und beim Duell einstellbare Farben, interaktive Sounds und wechselnde Animationseffekte ermöglichen.

Hattei Salman, ein Doktorand am MIT, dessen Arbeit sich um Modelle des maschinellen Lernens dreht, sagte Gizmodo in einem Telefoninterview, dass das von ihm mitentwickelte System nur wenige Sekunden braucht, um Rauschen in ein Foto einzubringen. Bilder mit höherer Auflösung funktionieren noch besser, sagte er, da sie mehr Pixel enthalten, die geringfügig gestört werden können.

Google entwickelt seinen eigenen KI-Bildgenerator namens Imagen, obwohl nur wenige Menschen in der Lage waren, ihr System auf Herz und Nieren zu prüfen. Das Unternehmen arbeitet auch an einer generatives KI-Videosystem. Salman sagte, dass sie ihr System nicht auf Video getestet haben, aber theoretisch sollte es immer noch funktionieren, obwohl das MIT-Programm jedes Einzelbild eines Videos einzeln nachbilden müsste, was Zehntausende von Einzelbildern für jedes längere Video sein könnte ein paar Minuten.

Kann Data Poisoning auf KI-Generatoren im großen Maßstab angewendet werden?

Salman sagte, er könne sich eine Zukunft vorstellen, in der Unternehmen, selbst diejenigen, die die KI-Modelle erstellen, zertifizieren könnten, dass hochgeladene Bilder gegen KI-Modelle immunisiert sind. Das sind natürlich keine guten Nachrichten für die Millionen von Bildern, die bereits in die Open-Source-Bibliothek wie LAION hochgeladen wurden, aber es könnte möglicherweise einen Unterschied für jedes Bild machen, das in Zukunft hochgeladen wird.

Madry teilte Gizmodo auch telefonisch mit, dass dieses System, obwohl ihre Datenvergiftung in vielen ihrer Tests funktioniert hat, eher ein Machbarkeitsnachweis als eine Produktveröffentlichung jeglicher Art ist. Das Programm der Forscher beweist, dass es Möglichkeiten gibt, Deepfakes zu besiegen, bevor sie entstehen.

Unternehmen müssten diese Technologie kennenlernen und in ihre eigenen Systeme implementieren, um sie noch manipulationssicherer zu machen. Darüber hinaus müssten die Unternehmen sicherstellen, dass zukünftige Versionen ihrer Diffusionsmodelle oder jeder anderen Art von KI-Bildgenerator das Rauschen nicht ignorieren und neue Deepfakes erzeugen können.

„Was in Zukunft wirklich passieren sollte, ist, dass alle Unternehmen, die Diffusionsmodelle entwickeln, die Möglichkeit einer gesunden, robusten Immunisierung bieten sollten“, sagte Madry.

Andere Experten auf dem Gebiet des maschinellen Lernens fanden einige Kritikpunkte an den MIT-Forschern.

Florian Tramèr, Informatikprofessor an der ETH Zürich in der Schweiz, getwittert dass die Hauptschwierigkeit darin besteht, dass Sie im Wesentlichen einen Versuch haben, alle zukünftigen Versuche, einen Deepfake mit einem Bild zu erstellen, zu täuschen. Tramèr war Co-Autor von a Papier 2021 veröffentlicht von der International Conference on Learning Representations, die im Wesentlichen feststellte, dass Datenvergiftung, wie sie das MIT-System mit seinem Bildrauschen macht, zukünftige Systeme nicht daran hindern wird, Wege zu finden, sie zu umgehen. Darüber hinaus wird die Schaffung dieser Datenvergiftungssysteme ein „Wettrüsten“ zwischen kommerziellen KI-Bildgeneratoren und denjenigen auslösen, die versuchen, Deepfakes zu verhindern.

Es gab andere Datenvergiftungsprogramme, die sich mit KI-basierter Überwachung befassen sollten, wie z Fawkes (ja, wie der 5. November), der von Forschern der University of Chicago entwickelt wurde. Fawkes verzerrt auch Pixel in Bildern so, dass sie Unternehmen wie Clearview daran hindern, eine genaue Gesichtserkennung zu erreichen. Andere Forscher der University of Melbourne in Australien und der University of Peking in China haben ebenfalls mögliche Systeme analysiert, die „nicht lernbare Beispiele“, die KI-Bildgeneratoren nicht verwenden können.

Das Problem ist, wie Fawkes-Entwicklerin Emily Wenger in einem Interview mit feststellte MIT Technology ReviewProgramme wie Microsoft Azure konnten sich trotz ihrer gegnerischen Techniken gegen Fawkes durchsetzen und Gesichter erkennen.

Gautam Kamath, Informatikprofessor an der University of Waterloo in Onatrio, Kanada, sagte Gizmodo in einem Zoom-Interview, dass im „Katz-und-Maus-Spiel“ zwischen denen, die versuchen, KI-Modelle zu erstellen, und denen, die Wege finden, sie zu besiegen, die Menschen produzieren neue KI-Systeme scheinen im Vorteil zu sein, denn sobald ein Bild im Internet ist, verschwindet es nie wirklich. Wenn es also einem KI-System gelingt, Versuche zu umgehen, um es vor Deepfakes zu schützen, gibt es keine wirkliche Möglichkeit, Abhilfe zu schaffen.

„Es ist möglich, wenn nicht sogar wahrscheinlich, dass wir in Zukunft in der Lage sein werden, jegliche Abwehrmaßnahmen zu umgehen, die Sie auf dieses eine bestimmte Bild anwenden“, sagte Kamath. „Und wenn es einmal da draußen ist, kannst du es nicht mehr zurücknehmen.“

Natürlich gibt es sie einige KI-Systeme, die Deepfake-Videos erkennen könnenund es gibt Möglichkeiten Menschen schulen, um die kleinen Ungereimtheiten zu erkennen die zeigen, dass ein Video gefälscht ist. Die Frage ist: Wird es eine Zeit geben, in der weder Mensch noch Maschine erkennen können, ob ein Foto oder Video manipuliert wurde?

Was ist mit den größten KI-Generatorunternehmen?

Für Madry und Salman besteht die Antwort darin, die KI-Unternehmen dazu zu bringen, mitzuspielen. Madry sagte, dass sie versuchen, sich mit einigen der großen KI-Generatorfirmen in Verbindung zu setzen, um zu sehen, ob sie daran interessiert wären, ihr vorgeschlagenes System zu erleichtern, obwohl es natürlich noch in den Anfängen steckt und das MIT-Team immer noch an einer öffentlichen API arbeitet, die dies tun würde Lassen Sie Benutzer ihre eigenen Fotos immunisieren (der Code ist verfügbar hier).

Auf diese Weise hängt alles von den Leuten ab, die die KI-Bildplattformen erstellen. Während Murati von OpenAI Noah in dieser Oktober-Folge sagte, dass sie „einige Leitplanken“ für ihr System haben, behaupteten sie weiter, dass sie Menschen nicht erlauben, Bilder auf der Grundlage von Persönlichkeiten des öffentlichen Lebens zu erstellen (was im Zeitalter der sozialen Medien, wo praktisch jeder hat ein öffentliches Gesicht). Das Team arbeitet auch an weiteren Filtern, die das System daran hindern, Bilder zu erstellen, die gewalttätige oder sexuelle Bilder enthalten.

Bereits im September kündigte OpenAI an Benutzer konnten wieder menschliche Gesichter hochladen zu ihrem System, behaupteten jedoch, sie hätten Möglichkeiten eingebaut, um Benutzer daran zu hindern, Gesichter in gewalttätigen oder sexuellen Kontexten zu zeigen. Es forderte die Benutzer auch auf, keine Bilder von Personen ohne deren Zustimmung hochzuladen, aber es ist eine Menge zu verlangen, dass das allgemeine Internet Versprechungen macht, ohne die Daumen zu drücken.

Das heißt jedoch nicht, dass andere KI-Generatoren und die Leute, die sie erstellt haben, genauso gut darin sind, die von ihren Benutzern generierten Inhalte zu moderieren. Stability AI, das Unternehmen hinter Stable Diffusion, hat gezeigt, dass es viel zögerlicher ist, Barrieren einzuführen, die Menschen daran hindern, mit seinem System Pornos oder abgeleitete Kunstwerke zu erstellen. Während OpenAI, ähm, offen darüber war, zu versuchen, ihr System daran zu hindern, Verzerrungen in den von ihm erzeugten Bildern anzuzeigen, StabilityAI hat sich ziemlich bedeckt gehalten.

Emad Mostaque, der CEO von Stability AI, hat sich für ein System ohne Regierungs- oder Unternehmenseinfluss ausgesprochen und hat dies bisher getan schlug zurück gegen Aufrufe, sein KI-Modell stärker einzuschränken. Er hat sagte, er glaube an die Bildgenerierung wird „in einem Jahr gelöst“, sodass Benutzer „alles, was Sie träumen können“, erstellen können. Natürlich ist das nur der Hype, der spricht, aber es zeigt, dass Mostaque nicht bereit ist, sich davor zurückzuziehen, dass die Technologie sich immer weiter vorantreibt.

Dennoch bleiben die MIT-Forscher standhaft.

„Ich denke, es gibt viele sehr unangenehme Fragen darüber, was die Welt ist, wenn diese Art von Technologie leicht zugänglich ist, und noch einmal, sie ist bereits leicht zugänglich und wird noch einfacher zu bedienen sein“, sagte Madry. „Wir sind wirklich froh, und wir sind wirklich aufgeregt darüber, dass wir jetzt einvernehmlich etwas dagegen tun können.“