Diese Woche veröffentlichte die Fachzeitschrift Frontiers in Cell and Developmental Biology Forschungsergebnisse mit gefälschten Bildern, die mit Midjourney, einem der Wissenschaftler, erstellt wurden beliebtesten KI-Bildgeneratoren.

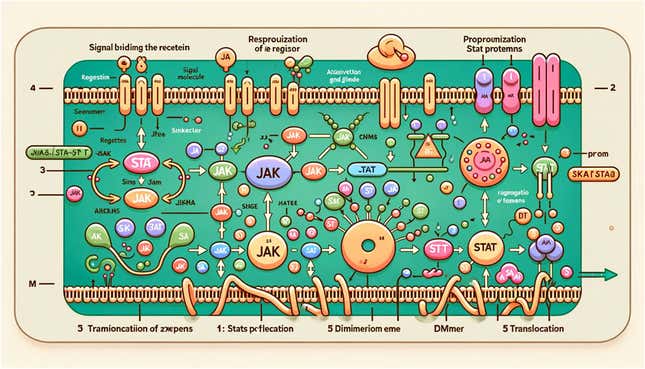

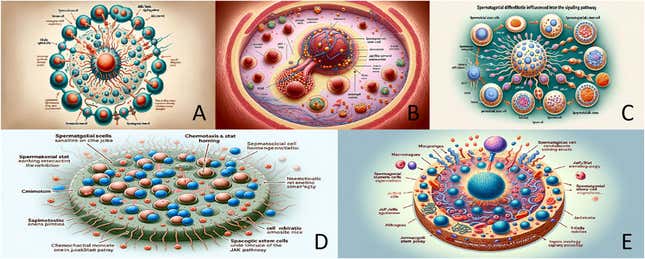

Der Open-Access Papier erforscht die Beziehung zwischen Stammzellen in Säugetierhoden und einem Signalweg, der für die Vermittlung von Entzündungen und Krebs in Zellen verantwortlich ist. Der schriftliche Inhalt der Arbeit scheint nicht gefälscht zu sein, aber die auffälligsten Aspekte liegen nicht in der Forschung selbst. Es handelt sich vielmehr um ungenaue und groteske Darstellungen von Rattenhoden, Signalwegen und Stammzellen.

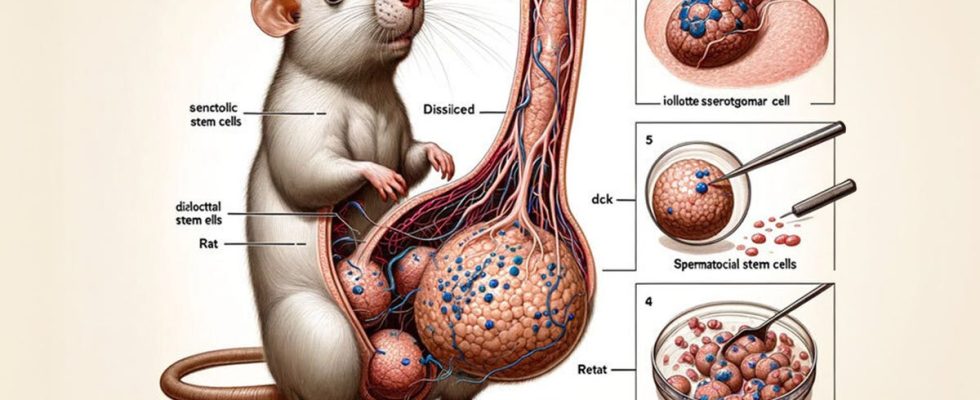

Das von der KI generierte Rattendiagramm zeigt eine Ratte (hilfreich und korrekt beschriftet), deren Oberkörper mit „senktolischen Stammzellen“ beschriftet ist. Was wie ein sehr großer Rattenpenis aussieht, trägt die Aufschrift „Dissilced“, mit Einfügungen auf der rechten Seite, um die „iollotte sserotgomar cell“, „dck“ und „Retat“ hervorzuheben. Hmm.

Entsprechend Herausgeberrichtlinien von Frontiers, Manuskripte unterliegen vor dem Peer-Review-Prozess „ersten Qualitätsprüfungen“ durch das Forschungsintegritätsteam und den betreuenden Herausgeber. Mit anderen Worten: Viele Augen haben diese Arbeit angeblich überprüft, bevor die Bilder veröffentlicht wurden.

Den Forschern muss man zugute halten, dass sie in der Arbeit angeben, dass die Bilder im Artikel von Midjourney erstellt wurden. Aber Frontiers’ Website für Richtlinien und Publikationsethik weist darauf hin, dass Korrekturen eingereicht werden können, wenn unter anderem „ein Fehler in einer Abbildung vorliegt, der die Schlussfolgerungen nicht ändert“ oder „falsch beschriftete Zahlen vorhanden sind“. Die von der KI generierten Bilder scheinen sicherlich in diese Kategorien zu fallen. Dingjun Hao, Forscher an der Xi’an Jiaotong-Universität und Mitautor der Studie, reagierte nicht sofort auf Gizmodos Bitte um Stellungnahme.

Das Rattenbild ist völlig falsch, auch wenn Sie noch nie die Genitalien einer Ratte aufgeschnitten haben. Aber die anderen Zahlen in der Zeitung könnten für das ungeübte Auge zumindest auf den ersten Blick als glaubwürdig erscheinen. Doch selbst jemand, der noch nie ein Biologielehrbuch aufgeschlagen hat, würde bei näherer Betrachtung feststellen, dass die Beschriftungen in jedem Diagramm nicht ganz englisch sind – a verräterisches Zeichen für KI-generierten Text in Bildern.

Der Artikel wurde von einem Experten für Tierreproduktion am National Dairy Research Institute in Indien herausgegeben und von Forschern der Northwestern Medicine und des National Institute of Animal Nutrition and Physiology überprüft. Wie wurden die verrückten Bilder veröffentlicht? Frontiers in Cell and Developmental Biology reagierte nicht sofort auf eine Bitte um Stellungnahme.

Der OpenAI-Textgenerator ChatGPT ist kompetent genug, um ihn zu bekommen Farkakte-Forschung an den vermeintlich anspruchsvollen Augen der Rezensenten vorbei. Eine von Forschern der Northwestern University und der University of Chicago durchgeführte Studie ergab, dass menschliche Experten in 32 % der Fälle durch von ChatGPT erstellte wissenschaftliche Zusammenfassungen getäuscht wurden.

Nur weil es sich bei den Illustrationen eindeutig um unsinnigstes Cosplay als Wissenschaft handelt, sollten wir die Fähigkeit von KI-Engines, Blödsinn als real auszugeben, nicht übersehen. Entscheidend sei, warnten diese Studienautoren, dass KI-generierte Artikel eine Krise der wissenschaftlichen Integrität auslösen könnten. Es scheint, als ob die Krise bereits im Gange sei.

Alexander Pearson, Datenwissenschaftler an der University of Chicago und Co-Autor dieser Studie, bemerkte damals: „Generative Texttechnologie hat ein großes Potenzial zur Demokratisierung der Wissenschaft, indem sie beispielsweise nicht englischsprachigen Wissenschaftlern den Austausch erleichtert.“ ihre Arbeit mit der breiteren Gemeinschaft“, aber „es ist unerlässlich, dass wir sorgfältig über Best Practices für den Einsatz nachdenken.“

Die zunehmende Beliebtheit von KI hat zugenommen verursacht wissenschaftlich ungenaue Bilder um Eingang in wissenschaftliche Publikationen und Nachrichtenartikel zu finden. KI-Bilder sind einfach zu erstellen und oft optisch ansprechend – aber KI ist ebenso unhandlich, und es überrascht nicht, dass es schwierig ist, alle Nuancen wissenschaftlicher Genauigkeit in einer Aufforderung für ein Diagramm oder eine Illustration zu vermitteln.

Die aktuelle Zeitung ist weit entfernt von den gefälschten Zeitungen vergangener Jahre, ein Pantheon, das Hits wie „Was ist mit Vögeln los?” und das Star Trek-thematische Arbeit“Rasche genetische und entwicklungsmorphologische Veränderungen nach extremer Geschwindigkeit.“

Manchmal ist eine Arbeit, die das Peer-Review durchläuft, einfach nur lustig. In anderen Fällen ist es ein Zeichen dafür, dass „Papiermühlen” produzieren am laufenden Band sogenannte Forschung, die keinen wissenschaftlichen Wert hat. Im Jahr 2021 war Springer Nature gezwungen, 44 Papiere zurückzuziehen im Arabian Journal of Geosciences als völliger Unsinn eingestuft.

In diesem Fall war die Forschung vielleicht in Ordnung, aber die gesamte Studie wird durch die Einbeziehung von Midjourney-generierten Bildern in Frage gestellt. Dem durchschnittlichen Leser fällt es möglicherweise schwer, über Signalwege nachzudenken, wenn er noch damit beschäftigt ist, genau zu zählen, wie viele Bälle die Ratte haben soll.

Mehr: ChatGPT schreibt gut genug, um wissenschaftliche Gutachter zu täuschen