Das API-Unternehmen Kong bringt sein Open-Source-AI-Gateway auf den Markt, eine Erweiterung seines bestehenden API-Gateways, die es Entwicklern und Betriebsteams ermöglicht, ihre Anwendungen in ein oder mehrere große Sprachmodelle (LLMs) zu integrieren und über eine einzige API darauf zuzugreifen. Darüber hinaus führt Kong mehrere KI-spezifische Funktionen wie Prompt Engineering, Credential Management und mehr ein.

„Wir glauben, dass KI ein zusätzlicher Anwendungsfall für APIs ist“, sagte mir Kong-Mitbegründer und CTO Marco Palladino. „APIs werden von Anwendungsfällen gesteuert: Mobil, Microservices – KI ist zufällig das Neueste. Wenn wir uns mit KI befassen, blicken wir eigentlich überall auf APIs. Wir betrachten APIs, wenn es um die Nutzung von KI geht, wir betrachten APIs zur Feinabstimmung der KI und der KI selbst. […] Je mehr KI, desto mehr API-Nutzung wird es auf der Welt geben.“

Palladino argumentiert, dass praktisch jedes Unternehmen zwar über den Einsatz von KI nachdenke, aber auch Angst vor Datenlecks habe. Irgendwann, so glaubt er, werden diese Unternehmen ihre Modelle lokal betreiben und vielleicht die Cloud als Ausweichlösung nutzen wollen. Vorerst müssen diese Unternehmen jedoch auch herausfinden, wie sie die Zugangsdaten für den Zugriff auf cloudbasierte Modelle verwalten, den Datenverkehr kontrollieren und protokollieren, Kontingente verwalten usw.

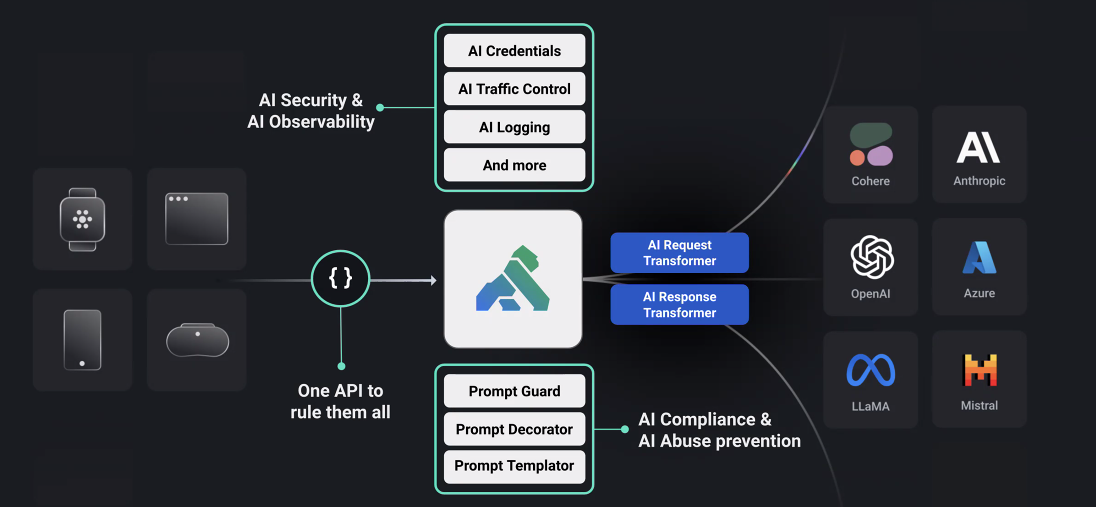

„Mit unserem API-Gateway wollten wir ein Angebot bereitstellen, das es Entwicklern ermöglicht, beim Aufbau auf KI produktiver zu arbeiten, indem wir unser Gateway nutzen können, um einen oder mehrere LLM-Anbieter zu nutzen, ohne ihren Code ändern zu müssen“, bemerkte er. Das Gateway unterstützt derzeit Anthropic, Azure, Cohere, die LLaMA-Modelle von Meta, Mistral und OpenAI.

Bildnachweis: Kong

Das Kong-Team argumentiert, dass die meisten anderen API-Anbieter KI-APIs derzeit auf die gleiche Weise verwalten wie alle anderen APIs. Doch durch die Integration dieser zusätzlichen KI-spezifischen Funktionen auf die API können nach Ansicht des Kong-Teams neue Anwendungsfälle ermöglicht werden (oder zumindest die Implementierung bestehender einfacher werden). Mithilfe der KI-Antwort- und Anforderungstransformatoren, die Teil des neuen KI-Gateways sind, können Entwickler Eingabeaufforderungen und ihre Ergebnisse im Handumdrehen ändern, um sie automatisch zu übersetzen oder beispielsweise personenbezogene Daten zu entfernen.

Auch Prompt Engineering ist tief in das Gateway integriert, sodass Unternehmen ihre Richtlinien zusätzlich zu diesen Modellen durchsetzen können. Dies bedeutet auch, dass es eine zentrale Stelle für die Verwaltung dieser Richtlinien und Hinweise gibt.

Seit der Einführung der Kong API Management Platform sind fast neun Jahre vergangen. Damals war das Unternehmen, das heute Kong heißt, noch unter dem Namen Mashape bekannt, aber wie mir Augusto Marietti, Mitbegründer und CEO von Mashape/Kong, Anfang dieser Woche in einem Interview sagte, handelte es sich dabei fast um einen letzten Versuch. „Mashape hat nirgendwohin geführt und Kong ist das API-Produkt Nummer eins auf GitHub“, sagte er. Marietti stellte fest, dass Kong im letzten Quartal einen positiven Cashflow verzeichnete – und derzeit nicht auf der Suche nach Finanzierung ist –, das hat also ganz gut geklappt.

Jetzt ist das Kong Gateway das Herzstück der Unternehmensplattform und auch der Antrieb des neuen AI Gateway. Tatsächlich müssen aktuelle Kong-Benutzer nur ihre aktuelle Installation aktualisieren, um Zugriff auf alle neuen KI-Funktionen zu erhalten.

Ab sofort sind diese neuen KI-Funktionen kostenlos verfügbar. Im Laufe der Zeit geht Kong davon aus, auch kostenpflichtige Premium-Funktionen einzuführen, das Team betonte jedoch, dass dies nicht das Ziel dieser aktuellen Version sei.