In einem neuen Forschungspapier von OpenAI vom Donnerstag heißt es, dass eine übermenschliche KI auf dem Vormarsch sei und das Unternehmen Tools entwickelt, um sicherzustellen, dass sie sich nicht gegen Menschen wendet. Der Chefwissenschaftler von OpenAI, Ilya Sutskever, wird als Hauptautor aufgeführt Papieraber nicht die Blogeintrag das ging damit einher, und seine Rolle im Unternehmen bleibt unklar.

„Wir glauben, dass Superintelligenz – KI, die weitaus intelligenter ist als Menschen – innerhalb der nächsten zehn Jahre entwickelt werden könnte“, sagte OpenAI in einem Blogeintrag. „Es war noch nie so wichtig herauszufinden, wie zukünftige übermenschliche KI-Systeme sicher ausgerichtet werden können, und es ist jetzt einfacher denn je, bei diesem Problem empirische Fortschritte zu erzielen.“

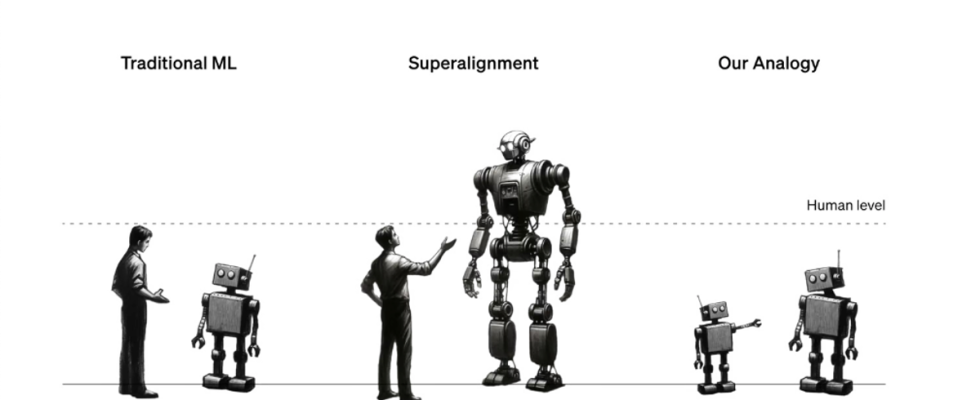

„Weak-to-strong generalization“ ist der erste Artikel des „Superalignment“-Teams von Ilya Sutskever und Jan Leike. erstellt im Juli um sicherzustellen, dass KI-Systeme, die viel intelligenter sind als Menschen, weiterhin menschlichen Regeln folgen. Die vorgeschlagene Lösung? OpenAI muss kleine KI-Modelle entwerfen, um übermenschliche KI-Modelle zu lehren.

Derzeit nutzt OpenAI Menschen, um ChatGPT zu „ausrichten“, indem es ihm gutes oder negatives Feedback gibt. Auf diese Weise stellt OpenAI sicher, dass ChatGPT den Leuten keine Anweisungen zum Bau von Napalm zu Hause oder zu anderen gefährlichen Folgen gibt. Da ChatGPT immer intelligenter wird, erkennt OpenAI jedoch, dass Menschen nicht ausreichen werden, um diese Modelle zu trainieren, sodass wir eine weniger komplizierte KI trainieren müssen, um dies in unserem Namen zu tun.

Dies ist das erste Lebenszeichen von Ilya Sutskever bei OpenAI, seit Sam Altman bekannt gegeben hat, dass fast alle wieder bei OpenAI sind, während er Sutskevers Status verlässt in der Luft. Sutskever, ein Mitbegründer von OpenAI, war eines der Vorstandsmitglieder dahinter Altman feuert, und er ist eine führende Stimme in der KI-Community für einen verantwortungsvollen KI-Einsatz. Er führt das Unternehmen nicht mehr weiter, könnte aber dennoch eine Rolle dort spielen.

Die andere Leiterin des Superalignment-Teams von OpenAI, Leike, Ich lobte Ilya dafür, dass sie am Donnerstag „das Feuer geschürt“ haben, lobte aber andere dafür, dass sie „jeden Tag die Dinge voranbringen“. Die Kommentare werfen die Frage auf, ob Sutskever dieses Projekt begonnen hat, aber nicht da war, um es fertigzustellen.

Berichten zufolge war er in den letzten Wochen im Unternehmen unsichtbar und hat einen Anwalt engagiert, teilten Quellen mit Geschäftseingeweihter. Jan Leike und andere Mitglieder des Superalignment-Teams von OpenAI haben zu diesem bahnbrechenden Artikel öffentliche Erklärungen abgegeben, aber Sutskever hat kein Wort gesagt – nur Retweets.

Die Studie ergab, dass das Training großer KI-Modelle mit kleineren KI-Modellen, was sie als „schwache bis starke Generalisierung“ bezeichnen, unter verschiedenen Umständen zu einem höheren Maß an Genauigkeit führt als menschliches Training. Ein Großteil der Studie nutzte GPT-2, um GPT-4 zu trainieren. Es ist wichtig anzumerken, dass OpenAI sagt, es sei nicht davon überzeugt, dass dies eine „Lösung“ für Superalignment sei, sondern lediglich ein vielversprechender Rahmen für das Training einer übermenschlichen KI.

„Im Großen und Ganzen übermenschliche Modelle wären außerordentlich leistungsfähig und könnten, wenn sie missbraucht oder falsch mit menschlichen Werten in Einklang gebracht würden, möglicherweise katastrophalen Schaden anrichten“, sagten OpenAI-Forscher in der Studie und stellten fest, dass unklar sei, wie dieses Thema empirisch untersucht werden könne. „Wir glauben, dass es jetzt einfacher ist, bei diesem Problem Fortschritte zu erzielen als je zuvor.“

Darüber gab es erhebliche Spekulationen OpenAI stand AGI nahe im November, obwohl vieles davon nicht schlüssig war. Dieses Papier bestätigt, dass OpenAI aktiv Tools zur Steuerung einer AGI entwickelt, bestätigt jedoch nicht die Existenz einer AGI. Was Ilya Sutskever betrifft, so bleibt sein Status in einer seltsamen Schwebe. OpenAI hat seine Position im Unternehmen nicht bestätigt, aber sein Team hat in aller Stille bahnbrechende Forschungsergebnisse veröffentlicht, während er seine Unternehmensankündigungen retweetet.