KI-Startup Anthropic, unterstützt von Google und Hunderten Millionen Risikokapital (und vielleicht bald). Hunderte Millionen mehr), Heute angekündigt die neueste Version seiner GenAI-Technologie, Claude. Und das Unternehmen behauptet, dass der KI-Chatbot den GPT-4 von OpenAI in puncto Leistung übertrifft.

Claude 3, wie die neue GenAI von Anthropic genannt wird, ist eine Familie von Modellen – Claude 3 Haiku, Claude 3 Sonnet und Claude 3 Opus, wobei Opus das leistungsstärkste ist. Alle zeigen „erhöhte Fähigkeiten“ bei Analyse und Prognose, so Anthropic, sowie eine verbesserte Leistung bei bestimmten Benchmarks im Vergleich zu Modellen wie ChatGPT und GPT-4 und Googles Gemini 1.0 Ultra (aber nicht Gemini 1.5 Pro).

Insbesondere ist Claude 3 die erste multimodale GenAI von Anthropic, was bedeutet, dass sie sowohl Text als auch Bilder analysieren kann – ähnlich wie einige Varianten von GPT-4 und Gemini. Claude 3 kann Fotos, Diagramme, Grafiken und technische Diagramme verarbeiten und aus PDFs, Diashows und anderen Dokumenttypen zeichnen.

Im ersten Schritt ist Claude 3 besser als einige GenAI-Konkurrenten und kann mehrere Bilder in einer einzigen Anfrage analysieren (bis zu maximal 20). Dies ermöglicht es, Bilder zu vergleichen und gegenüberzustellen, bemerkt Anthropic.

Der Bildverarbeitung von Claude 3 sind jedoch Grenzen gesetzt.

Anthropic hat die Modelle daran gehindert, Personen zu identifizieren – zweifellos aus Angst vor den ethischen und rechtlichen Implikationen. Und das Unternehmen gibt zu, dass Claude 3 bei Bildern mit „schlechter Qualität“ (unter 200 Pixel) dazu neigt, Fehler zu machen, und Probleme mit räumlichem Denken (z. B. Lesen eines analogen Zifferblatts) und Objektzählen hat (Claude 3 kann keine genauen Angaben machen). Anzahl der Objekte in Bildern).

Bildnachweis: Anthropisch

Claude 3 wird es auch nicht tun generieren Kunstwerk. Die Modelle analysieren ausschließlich Bilder – zumindest vorerst.

Unabhängig davon, ob Text oder Bilder verarbeitet werden, können Kunden laut Anthropic von Claude 3 im Allgemeinen erwarten, dass er mehrstufigen Anweisungen besser folgt und strukturierte Ausgaben in Formaten wie … erstellt JSON und sich im Vergleich zu seinen Vorgängern in anderen Sprachen als Englisch unterhalten. Dank eines „differenzierteren Verständnisses von Anfragen“ sollte sich Claude 3 auch seltener weigern, Fragen zu beantworten, sagt Anthropic. Und bald werden die Modelle die Quelle ihrer Antworten auf Fragen angeben, damit Benutzer sie überprüfen können.

„Claude 3 tendiert dazu, ausdrucksstärkere und ansprechendere Antworten zu generieren“, schreibt Anthropic in einem Support-Artikel. „[It’s] im Vergleich zu unseren Vorgängermodellen einfacher anzusteuern und zu steuern. Benutzer sollten feststellen, dass sie mit kürzeren und prägnanteren Eingabeaufforderungen die gewünschten Ergebnisse erzielen können.“

Einige dieser Verbesserungen sind auf den erweiterten Kontext von Claude 3 zurückzuführen.

Der Kontext oder das Kontextfenster eines Modells bezieht sich auf Eingabedaten (z. B. Text), die das Modell berücksichtigt, bevor es eine Ausgabe generiert. Modelle mit kleinen Kontextfenstern neigen dazu, den Inhalt selbst sehr aktueller Gespräche zu „vergessen“, was dazu führt, dass sie vom Thema abschweifen – oft auf problematische Weise. Ein zusätzlicher Vorteil besteht darin, dass Modelle mit großem Kontext den narrativen Datenfluss, den sie aufnehmen, besser erfassen und kontextreichere Antworten generieren können (zumindest hypothetisch).

Anthropic sagt, dass Claude 3 zunächst ein Kontextfenster mit 200.000 Token unterstützen wird, was etwa 150.000 Wörtern entspricht, wobei ausgewählte Kunden ein Kontextfenster mit 1 Million Token (~700.000 Wörter) einrichten werden. Das entspricht dem neuesten GenAI-Modell von Google, dem oben erwähnten Gemini 1.5 Pro, das ebenfalls ein Kontextfenster mit bis zu einer Million Token bietet.

Nur weil Claude 3 ein Upgrade gegenüber dem Vorgänger ist, heißt das nicht, dass es perfekt ist.

In einem technischen weißes PapierAnthropic gibt zu, dass Claude 3 nicht immun gegen die Probleme ist, die auch andere GenAI-Modelle plagen, nämlich Voreingenommenheit und Halluzinationen (z. B. Dinge erfinden). Im Gegensatz zu einigen GenAI-Modellen kann Claude 3 nicht im Internet suchen; Die Modelle können Fragen nur mit Daten aus der Zeit vor August 2023 beantworten. Und obwohl Claude mehrsprachig ist, spricht er bestimmte „ressourcenarme“ Sprachen nicht so fließend wie Englisch.

Aber Anthropic verspricht in den kommenden Monaten häufige Updates für Claude 3.

„Wir glauben nicht, dass die Modellintelligenz auch nur annähernd an ihre Grenzen stößt, und planen eine Veröffentlichung [enhancements] „In den nächsten Monaten werden wir die Modellfamilie Claude 3 erweitern“, schreibt das Unternehmen in einem Blogeintrag.

Opus und Sonnet sind ab sofort im Internet und über die Entwicklungskonsole und API von Anthropic, die Bedrock-Plattform von Amazon und Vertex AI von Google verfügbar. Haiku wird später in diesem Jahr folgen.

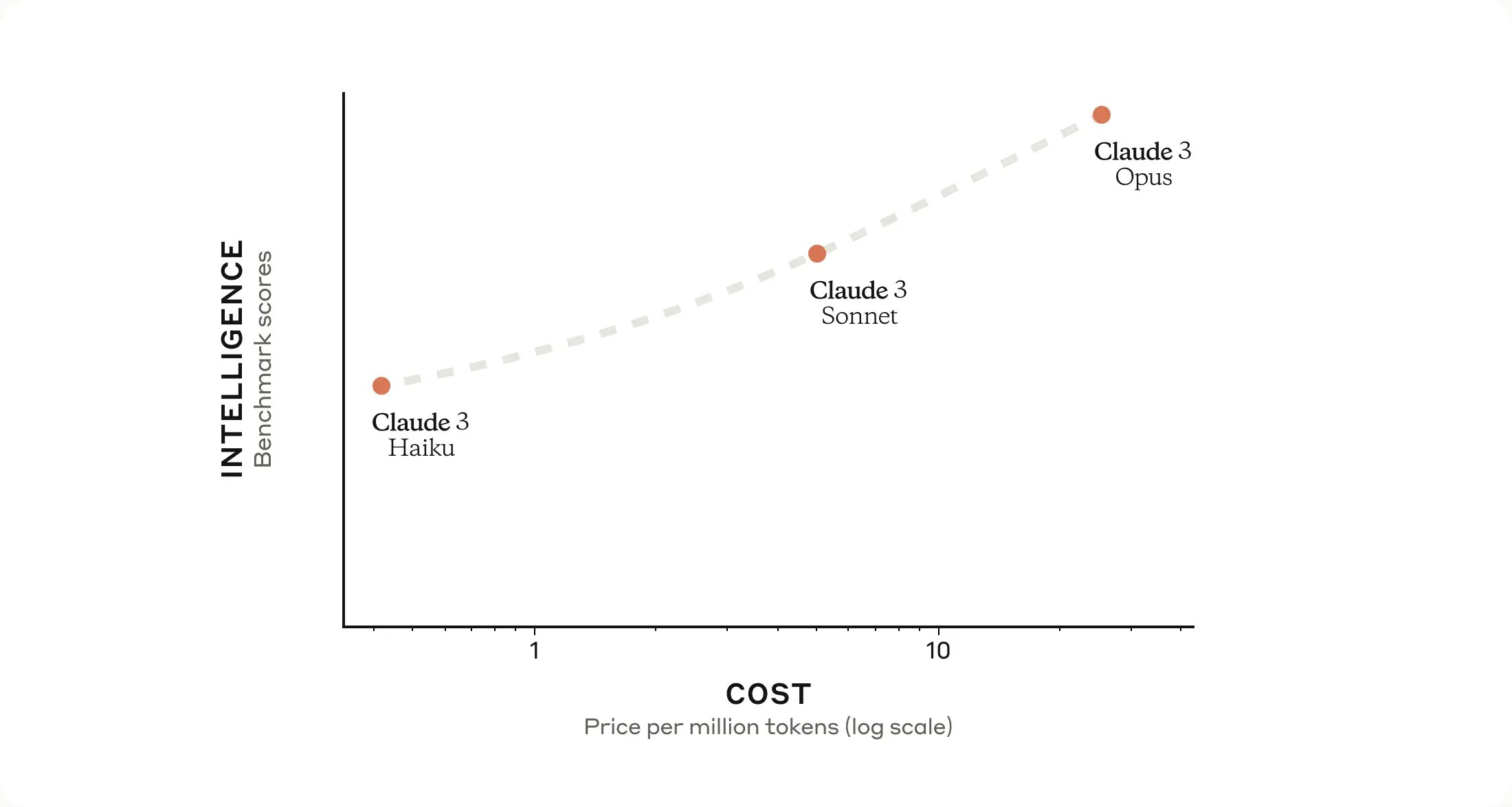

Hier ist die Preisaufschlüsselung:

- Opus: 15 $ pro Million Input-Tokens, 75 $ pro Million Output-Tokens

- Sonnet: 3 $ pro Million Input-Tokens, 15 $ pro Million Output-Tokens

- Haiku: 0,25 $ pro Million Input-Tokens, 1,25 $ pro Million Output-Tokens

Das ist also Claude 3. Aber was ist die 30.000-Fuß-Ansicht von all dem?

Nun ja, wie wir es getan haben gemeldet Zuvor hatte Anthropic das Ziel, einen Algorithmus der nächsten Generation für „KI-Selbstlernen“ zu entwickeln. Ein solcher Algorithmus könnte verwendet werden, um virtuelle Assistenten zu erstellen, die E-Mails beantworten, Recherchen durchführen und Kunst, Bücher und mehr generieren können – von denen wir einige bereits kennengelernt haben, z. B GPT-4 und andere große Sprachmodelle.

Anthropic deutet dies im oben genannten Blogbeitrag an und sagt, dass es plant, Claude 3 um Funktionen zu erweitern, die seine Out-of-the-Gate-Fähigkeiten verbessern, indem sie es Claude ermöglichen, mit anderen Systemen zu interagieren, „interaktiv“ zu programmieren und „erweiterte Agentenfähigkeiten“ bereitzustellen .“

Der letzte Teil erinnert an OpenAIs gemeldet Ambitionen, einen Software-Agenten zu entwickeln, um komplexe Aufgaben zu automatisieren, wie die Übertragung von Daten aus einem Dokument in eine Tabellenkalkulation oder das automatische Ausfüllen von Spesenabrechnungen und deren Eingabe in Buchhaltungssoftware. OpenAI bietet bereits eine API, die es Entwicklern ermöglicht, „agentenähnliche Erfahrungen“ in ihre Apps zu integrieren, und Anthropic scheint darauf bedacht zu sein, vergleichbare Funktionen bereitzustellen.

Könnten wir als nächstes einen Bildgenerator von Anthropic sehen? Es würde mich ehrlich gesagt überraschen. Bildgeneratoren sind heutzutage Gegenstand vieler Kontroversen, vor allem aus urheberrechtlichen und voreingenommenen Gründen. Google war kürzlich gezwungen, seinen Bildgenerator zu deaktivieren, nachdem er den Bildern Vielfalt verliehen hatte und dabei den historischen Kontext lächerlich missachtete. Und eine Reihe von Anbietern von Bildgeneratoren befinden sich in Rechtsstreitigkeiten mit Künstlern, die ihnen vorwerfen, von ihrer Arbeit zu profitieren, indem sie GenAI für diese Arbeit schulen, ohne eine Entschädigung oder auch nur eine Anerkennung zu gewähren.

Ich bin gespannt auf die Weiterentwicklung der Technik von Anthropic zum Trainieren von GenAI, der „konstitutionellen KI“, die das Verhalten seiner GenAI nach Angaben des Unternehmens leichter verständlich, vorhersehbarer und bei Bedarf einfacher anzupassen macht. Die konstitutionelle KI soll einen Weg dazu bieten KI an menschlichen Absichten ausrichtenDabei werden Modelle anhand einfacher Leitprinzipien auf Fragen antworten und Aufgaben ausführen lassen. Für Claude 3 sagte Anthropic beispielsweise, dass es ein Prinzip hinzugefügt habe – basierend auf Crowdsourcing-Feedback –, das die Modelle anweist, Menschen mit Behinderungen zu verstehen und für sie zugänglich zu sein.

Was auch immer das Endziel von Anthropic sein mag, es ist auf lange Sicht wichtig. Einem im Mai letzten Jahres durchgesickerten Pitch-Deck zufolge will das Unternehmen in den nächsten 12 Monaten bis zu 5 Milliarden US-Dollar aufbringen – was vielleicht genau die Grundvoraussetzung ist, die es braucht, um mit OpenAI konkurrenzfähig zu bleiben. (Modelle zu trainieren ist schließlich nicht billig.) Mit 2 Milliarden US-Dollar und 4 Milliarden US-Dollar an gebundenem Kapital und Zusagen von Google bzw. Amazon sowie weit über einer Milliarde zusammengenommen von anderen Geldgebern ist es auf einem guten Weg.