Die Ära der schlechten Robotermusik steht vor der Tür. Adobe arbeitet an einem neuen KI-Tool, mit dem jeder Musikproduzent werden kann – dafür sind weder Instrumenten- noch Bearbeitungserfahrung erforderlich.

Das Unternehmen enthüllt „Projekt Musik GenAI Control“– ein sehr langer Name – diese Woche. Mit dem Tool können Benutzer Musik erstellen und bearbeiten, indem sie einfach Textaufforderungen in ein generatives KI-Modell eingeben. Dazu können Beschreibungen wie „kraftvoller Rock“, „fröhlicher Tanz“ oder „trauriger Jazz“ gehören, erklärte Adobe.

Project Music GenAI Control erstellt dann basierend auf der Eingabeaufforderung des Benutzers eine erste Melodie, die er auch per Text bearbeiten kann. Laut Adobe können Benutzer unter anderem die Intensität der generierten Musik bearbeiten, die Länge des Musikclips verlängern oder eine wiederholbare Schleife erstellen.

Zur Zielgruppe dieses neuen Tools gehören Podcaster, Rundfunkveranstalter und „alle anderen, die Audio benötigen, das genau die richtige Stimmung, den richtigen Ton und die richtige Länge hat“, sagte Nicholas Bryan, ein leitender Adobe-Forschungswissenschaftler und einer der Entwickler der Technologie.

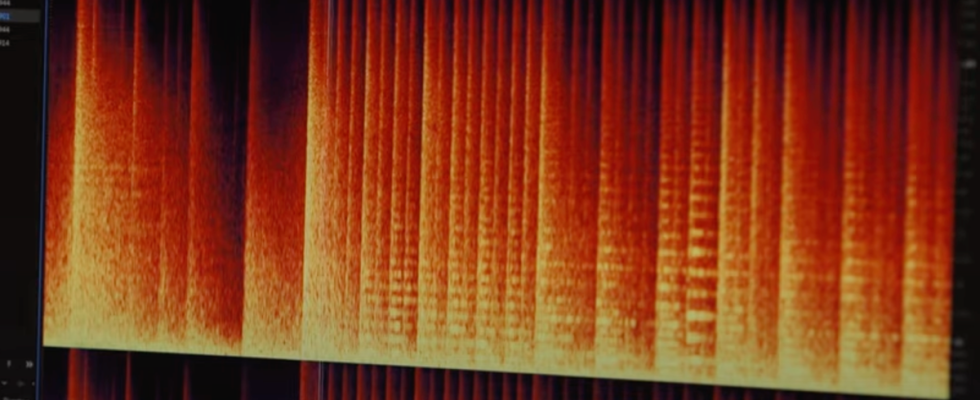

„Eines der aufregenden Dinge an diesen neuen Tools ist, dass es ihnen nicht nur um die Generierung von Audio geht – sie bringen es auf das Niveau von Photoshop, indem sie Kreativen die gleiche umfassende Kontrolle über die Formung, Optimierung und Bearbeitung ihrer Audiodaten geben. „Bryan erklärte in einem Adobe-Blog. „Es ist eine Art Steuerung der Musik auf Pixelebene.“

Adobe hat ein Video hochgeladen, das zeigt, wie Project Music GenAI Control funktioniert, und es war erschreckend, wie einfach es mit dem Tool war, Musik zu erstellen. Es schien auch sehr schnell zu funktionieren. Auch wenn die daraus entstandene Musik keine Grammys gewinnen wird, kann ich mir durchaus vorstellen, sie im Hintergrund von YouTube-Videos, TikToks oder Twitch-Streams zu hören.

Das ist nicht gerade eine gute Sache. KI hat in Berufen wie dem Schreiben und Schauspielern Einzug gehalten und Arbeitnehmer dazu gezwungen, Stellung zu beziehen und zu verhindern, dass ihnen ihre Lebensgrundlagen gestohlen werden. Kommentare zum YouTube-Video des Unternehmens spiegelten diese Bedenken wider und kritisierten das Unternehmen dafür, „Musik geschrieben von Robotern für Roboter“ und „gute Unternehmenskritik“ zu machen.

„Vielen Dank an Adobe für den Versuch, noch mehr Möglichkeiten für Unternehmen zu finden, Kreative aus dem Job zu drängen. Und von welchen Künstlern haben Sie das Material gestohlen, mit dem Sie Ihre KI trainiert haben?“ schrieb ein Benutzer.

Auf die Frage von Gizmodo um einen Kommentar gab Adobe keine Details über die Musik bekannt, die zum Trainieren seines KI-Modells für Project Music GenAI Control verwendet wurde. Es wies jedoch darauf hin, dass es bei Firefly, seiner Familie von KI-Bildgeneratoren, seine Modelle nur auf offen lizenzierten und gemeinfreien Domains trainiert hatte, deren Urheberrecht abgelaufen war.

„Project Music GenAI Control ist ein sehr früher Blick auf die von Adobe Research entwickelte Technologie, und obwohl wir die Details des Modells noch nicht offenlegen, können wir Folgendes mitteilen: Adobe hat schon immer einen proaktiven Ansatz verfolgt, um sicherzustellen, dass wir verantwortungsvoll innovativ sind “, sagte Anais Gragueb, eine Adobe-Sprecherin, in einer E-Mail zu Gizmodo.

Musik ist Kunst und von Natur aus menschlich. Daher müssen wir vorsichtig sein, wenn es um neue Tools wie die von Adobe geht – sonst riskieren wir eine Zukunft, in der Musik so leer klingt wie die Maschinen, die sie erzeugen.

Update 01.03.2024, 17:56 Uhr ET: Dieser Beitrag wurde mit einem zusätzlichen Kommentar von Adobe aktualisiert.