Für Jae Lee, einen ausgebildeten Datenwissenschaftler, machte es nie Sinn, dass Videos – die mit dem Aufkommen von Plattformen wie TikTok, Vimeo und YouTube zu einem enormen Teil unseres Lebens geworden sind – aufgrund der technischen Barrieren schwer zu durchsuchen waren durch Kontextverständnis gestellt. Die Suche nach Titeln, Beschreibungen und Tags von Videos war immer einfach genug und erforderte nicht mehr als einen einfachen Algorithmus. Aber suchen innerhalb Videos für bestimmte Momente und Szenen überstiegen die Möglichkeiten der Technik, insbesondere wenn diese Momente und Szenen nicht auf offensichtliche Weise gekennzeichnet waren.

Um dieses Problem zu lösen, hat Lee zusammen mit Freunden aus der Technologiebranche einen Cloud-Dienst für die Suche und das Verständnis von Videos entwickelt. Es wurde Zwölf Labore, das anschließend 17 Millionen US-Dollar an Risikokapital aufbrachte – 12 Millionen US-Dollar davon stammten aus einer Seed-Erweiterungsrunde, die heute abgeschlossen wurde. Radical Ventures leitete die Erweiterung mit Beteiligung von Index Ventures, WndrCo, Spring Ventures, Weights & Biases CEO Lukas Biewald und anderen, sagte Lee TechCrunch in einer E-Mail.

„Die Vision von Twelve Labs ist es, Entwicklern dabei zu helfen, Programme zu entwickeln, die die Welt so sehen, hören und verstehen können wie wir, indem wir ihnen die leistungsfähigste Infrastruktur zum Verstehen von Videos zur Verfügung stellen“, sagte Lee.

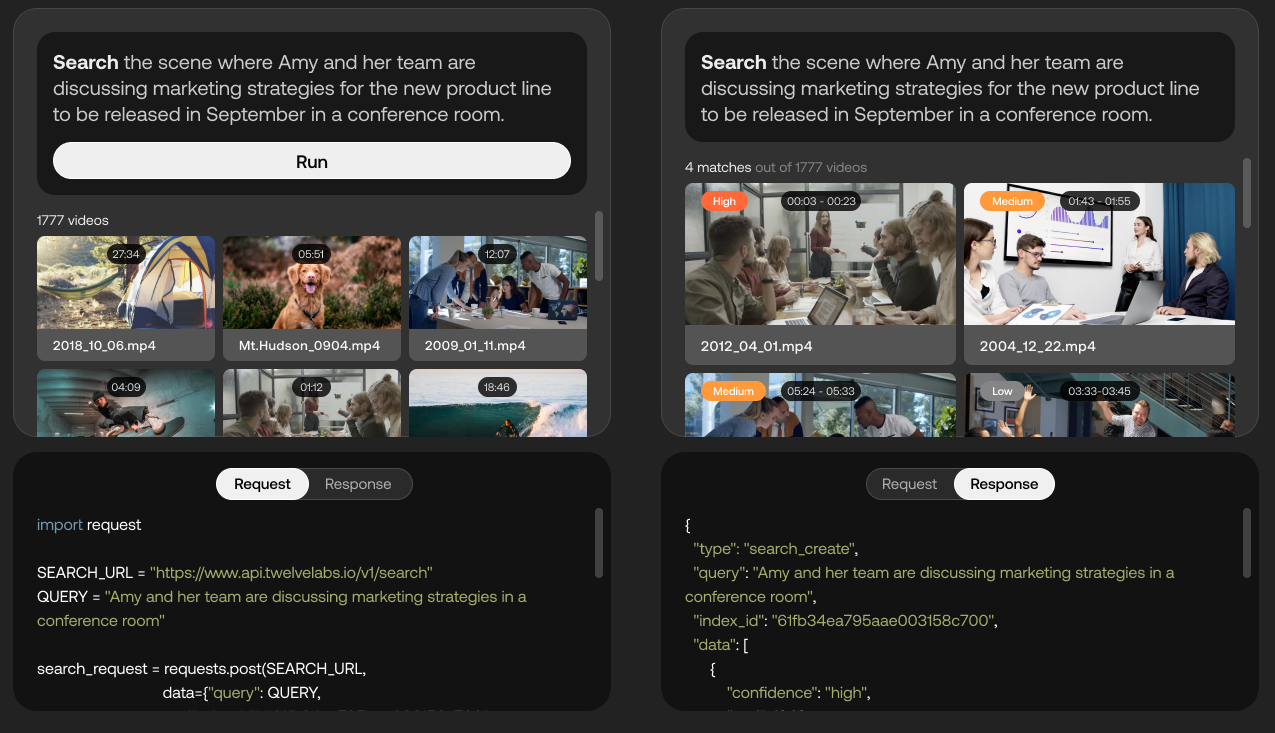

Eine Demo der Fähigkeiten der Twelve Labs-Plattform. Bildnachweis: Zwölf Labore

Twelve Labs, das sich derzeit in der Closed-Beta-Phase befindet, verwendet KI, um zu versuchen, „reiche Informationen“ aus Videos wie Bewegungen und Aktionen, Objekten und Personen, Ton, Text auf dem Bildschirm und Sprache zu extrahieren, um die Beziehungen zwischen ihnen zu identifizieren. Die Plattform wandelt diese verschiedenen Elemente in mathematische Darstellungen um, die als „Vektoren“ bezeichnet werden, und bildet „zeitliche Verbindungen“ zwischen Frames, wodurch Anwendungen wie die Suche nach Videoszenen ermöglicht werden.

„Als Teil der Verwirklichung der Vision des Unternehmens, Entwickler bei der Erstellung intelligenter Videoanwendungen zu unterstützen, erstellt das Team von Twelve Labs ‚Grundlagenmodelle’ für multimodales Videoverständnis“, sagte Lee. „Entwickler werden über eine Reihe von APIs auf diese Modelle zugreifen können, die nicht nur die semantische Suche, sondern auch andere Aufgaben wie die „Kapitelisierung“ von Videos in Langform, die Erstellung von Zusammenfassungen und Videofragen und -antworten durchführen.“

Google verfolgt mit seinem KI-System MUM einen ähnlichen Ansatz für das Verständnis von Videos, mit dem das Unternehmen Videoempfehlungen in der Google-Suche und auf YouTube unterstützt, indem es Themen in Videos (z. B. „Acrylmalmaterialien“) basierend auf Audio, Text und Bild auswählt Inhalt. Aber obwohl die Technologie vergleichbar sein mag, ist Twelve Labs einer der ersten Anbieter, der sie vermarktet; Google hat sich dafür entschieden, MUM intern zu belassen und es abgelehnt, es über eine öffentlich zugängliche API verfügbar zu machen.

Abgesehen davon bieten Google sowie Microsoft und Amazon Dienste an (z. B. Google Cloud Video AI, Azure Video Indexer und AWS Rekognition), die Objekte, Orte und Aktionen in Videos erkennen und umfangreiche Metadaten auf Frame-Ebene extrahieren. Es gibt auch Reminiz, ein französisches Computer-Vision-Startup, das behauptet, jede Art von Video indizieren und sowohl aufgezeichneten als auch live gestreamten Inhalten Tags hinzufügen zu können. Aber Lee behauptet, dass Twelve Labs ausreichend differenziert ist – zum Teil, weil seine Plattform es Kunden ermöglicht, die KI auf bestimmte Kategorien von Videoinhalten abzustimmen.

Mockup der API zur Feinabstimmung des Modells, damit es besser mit salatbezogenen Inhalten funktioniert. Bildnachweis: Zwölf Labore

„Was wir herausgefunden haben, ist, dass schmale KI-Produkte, die zur Erkennung spezifischer Probleme entwickelt wurden, in ihren idealen Szenarien in einer kontrollierten Umgebung eine hohe Genauigkeit aufweisen, aber nicht so gut auf unordentliche Daten aus der realen Welt skalieren“, sagte Lee. „Sie agieren eher als regelbasiertes System und können daher bei Abweichungen nicht verallgemeinern. Wir sehen dies auch als Einschränkung, die auf mangelndes Kontextverständnis zurückzuführen ist. Das Verständnis des Kontexts verleiht Menschen die einzigartige Fähigkeit, Verallgemeinerungen über scheinbar unterschiedliche Situationen in der realen Welt hinweg zu treffen, und hier steht Twelve Labs allein.“

Über die Suche hinaus kann die Technologie von Twelve Labs laut Lee Dinge wie das Einfügen von Anzeigen und die Moderation von Inhalten vorantreiben, indem sie beispielsweise auf intelligente Weise herausfindet, welche Videos, die Messer zeigen, gewalttätig oder lehrreich sind. Es kann auch für Medienanalysen und Echtzeit-Feedback verwendet werden, sagt er, und um automatisch Highlight-Rollen aus Videos zu generieren.

Etwas mehr als ein Jahr nach seiner Gründung (März 2021) hat Twelve Labs zahlende Kunden – wie viele genau, wollte Lee nicht verraten – und einen mehrjährigen Vertrag mit Oracle, um KI-Modelle mithilfe der Cloud-Infrastruktur von Oracle zu trainieren. Mit Blick auf die Zukunft plant das Startup, in den Ausbau seiner Technologie und die Erweiterung seines Teams zu investieren. (Lee lehnte es ab, die aktuelle Größe der Belegschaft von Twelve Labs preiszugeben, aber LinkedIn Daten zeigt, dass es ungefähr 18 Personen sind.)

„Für die meisten Unternehmen macht es trotz des enormen Mehrwerts, der durch große Modelle erzielt werden kann, wirklich keinen Sinn, diese Modelle selbst zu trainieren, zu betreiben und zu warten. Durch die Nutzung einer Plattform von Twelve Labs kann jede Organisation mit nur wenigen intuitiven API-Aufrufen leistungsstarke Funktionen zum Verstehen von Videos nutzen“, sagte Lee. „Die zukünftige Richtung der KI-Innovation geht direkt in Richtung multimodales Videoverständnis, und Twelve Labs ist gut positioniert, um die Grenzen im Jahr 2023 noch weiter zu verschieben.“