Ähnlich wie Unternehmen ihre Software so anpassen, dass sie auf verschiedenen Desktop-, Mobil- und Cloud-Betriebssystemen läuft, müssen auch Unternehmen ihre Software für die schnell voranschreitende KI-Revolution konfigurieren, bei der große Sprachmodelle (LLMs) entstanden sind, um leistungsstarke neue Funktionen bereitzustellen KI-Anwendungen, die in der Lage sind, Texte in menschlicher Sprache zu interpretieren und zu generieren.

Während ein Unternehmen bereits eine „LLM-Instanz“ seiner Software auf der Grundlage seiner aktuellen API-Dokumentation erstellen kann, besteht das Problem darin, dass es sicherstellen muss, dass das breitere LLM-Ökosystem diese ordnungsgemäß nutzen kann – und ausreichend Einblick in die Qualität dieser Instanz erhält Ihr Produkt funktioniert tatsächlich in freier Wildbahn.

Und genau das ist es Gezeitenfluss macht sich an die Lösung, mit einer End-to-End-Plattform, die es Entwicklern ermöglicht, ihre bestehende Software gut mit dem LLM-Ökosystem zu kombinieren. Das junge Startup kommt heute mit 1,7 Millionen US-Dollar aus der Tarnung in einer Finanzierungsrunde unter der gemeinsamen Leitung von Googles Gradient Ventures zusammen mit Dig Ventures, einer VC-Firma, die mein MuleSoft-Gründer Ross Mason gegründet hat, unter Beteiligung von Antler.

Vertrauen

Stellen Sie sich dieses hypothetische Szenario vor: Eine Online-Reiseplattform beschließt, LLM-fähige Chatbots wie ChatGPT und Googles Bard einzuführen, damit ihre Kunden Flugpreise anfordern und Tickets über Eingabeaufforderungen in natürlicher Sprache in einer Suchmaschine buchen können. Also erstellt das Unternehmen für jede eine LLM-Instanz, aber soweit sie wissen, liefern 2 % der ChatGPT-Ergebnisse ein Ziel, nach dem der Kunde nicht gefragt hat, eine Fehlerquote, die bei Bard möglicherweise sogar noch höher ist – das ist einfach unmöglich weiß es genau.

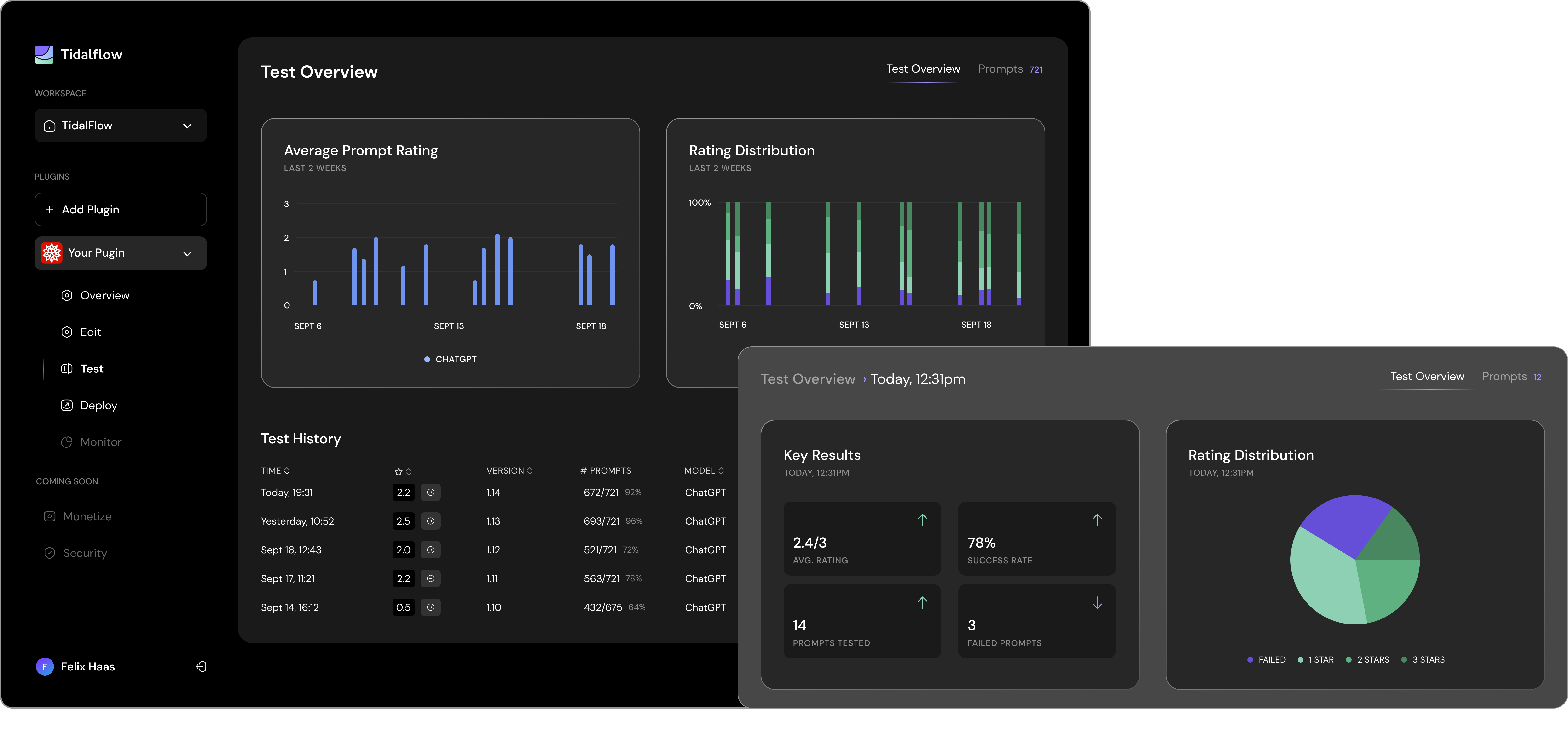

Wenn ein Unternehmen nun eine Fehlertoleranz von weniger als 1 % hat, fühlt es sich möglicherweise einfach sicherer nicht Sie gehen den Weg der generativen KI, bis sie mehr Klarheit darüber haben, wie ihre LLM-Instanz tatsächlich funktioniert. Hier kommt Tidalflow ins Spiel, mit Modulen, die Unternehmen nicht nur dabei helfen, ihre LLM-Instanz zu erstellen, sondern diese auch zu testen, bereitzustellen, zu überwachen, zu sichern und schließlich zu monetarisieren. Sie können auch die LLM-Instanz ihres Produkts für jedes Ökosystem in einer lokalen simulierten Sandbox-Umgebung optimieren, bis sie zu einer Lösung gelangen, die ihren Fehlertoleranzschwellenwerten entspricht.

„Das große Problem ist, wenn man etwas wie ChatGPT startet, weiß man eigentlich nicht, wie die Benutzer damit interagieren“, sagt Tidalflow-CEO Sebastian Jörna sagte TechCrunch. „Dieser Mangel an Vertrauen in die Zuverlässigkeit ihrer Software ist ein großes Hindernis für die Einführung von Softwaretools in LLM-Ökosystemen. Das Test- und Simulationsmodul von Tidalflow schafft dieses Vertrauen.“

Tidalflow lässt sich vielleicht am besten als ALM-Plattform (Application Lifecycle Management) beschreiben, in die Unternehmen ihre OpenAPI-Spezifikation/-Dokumentation einbinden. Und am anderen Ende spuckt Tidalflow eine „kampferprobte LLM-Instanz“ dieses Produkts aus, wobei das Front-End für die Überwachung und Beobachtbarkeit der Leistung dieser LLM-Instanz in freier Wildbahn sorgt.

„Bei normalen Softwaretests durchlaufen Sie eine bestimmte Anzahl von Fällen – und wenn es funktioniert, dann funktioniert die Software“, sagte Jorna. „Da wir uns nun in diesem stochastischen Umfeld befinden, muss man tatsächlich viel Volumen einsetzen, um eine gewisse statistische Signifikanz zu erhalten. Und das ist im Grunde das, was wir in unserem Test- und Simulationsmodul tun, wo wir simulieren, als ob das Produkt bereits live wäre und wie potenzielle Benutzer es verwenden könnten.“

Tidalflow-Dashboard. Bildnachweis: Gezeitenfluss

Kurz gesagt: Mit Tidalflow können Unternehmen unzählige Randfälle durchgehen, die möglicherweise die neuen intelligenten generativen KI-Funktionen beeinträchtigen oder auch nicht. Dies ist besonders wichtig für größere Unternehmen, bei denen das Risiko einer Beeinträchtigung der Softwarezuverlässigkeit einfach zu groß ist.

„Kunden größerer Unternehmen können einfach nicht das Risiko eingehen, etwas auf den Markt zu bringen, ohne darauf zu vertrauen, dass es funktioniert“, fügte Jorna hinzu.

Von der Stiftung zur Finanzierung

Coen Stevens (CTO), Sebastian Jorna (CEO) und Henry Wynaendts (CPO) von Tidalflow. Bildnachweis: Gezeitenfluss

Tidalflow ist offiziell drei Monate alt, mit den Gründern Jorna (CEO) und Coen Stevens (CTO)-Treffen durch Geweih‘s Entrepreneur-in-Residence-Programm in Amsterdam. „Als das offizielle Programm im Sommer startete, war Tidalflow das Unternehmen, das am schnellsten in der Geschichte von Antler Netherlands eine Finanzierung erhielt“, sagte Jorna.

Heute verfügt Tidalflow über ein dreiköpfiges Team, darunter seine beiden Mitbegründer und den Chief Product Officer (CPO). Henry Wynaendts. Aber mit einer neuen Finanzierung in Höhe von 1,7 Millionen US-Dollar Jorna sagte das Unternehmen ist derzeit aktiv auf der Suche nach Mitarbeitern für verschiedene Positionen im Front- und Back-End-Engineering, während auf eine vollständige kommerzielle Markteinführung hingearbeitet wird.

Aber nicht zuletzt ist der schnelle Übergang von der Gründung zur Finanzierung ein Hinweis auf den aktuellen Goldrausch im Bereich der generativen KI. Mit ChatGPT erhält man eine API und Unterstützung für Plugins von DrittanbieternGoogle ist auf dem Weg, dasselbe für das Bard-Ökosystem zu tun und Microsoft-Einbettung Mit dem KI-Assistenten Copilot in Microsoft 365 haben Unternehmen und Entwickler eine große Chance, generative KI nicht nur für ihre eigenen Produkte zu nutzen, sondern dabei auch eine große Anzahl von Benutzern zu erreichen.

„So wie das iPhone 2007 eine neue Ära für mobilfreundliche Software einläutete, stehen wir jetzt an einem ähnlichen Wendepunkt, nämlich an der LLM-Kompatibilität von Software“, bemerkte Jorna.

Tidalflow bleibt vorerst in der geschlossenen Betaphase und soll bis Ende 2023 kommerziell für die Öffentlichkeit eingeführt werden.