Zur Erweiterung seines KI-Ökosystems hat NVIDIA „Chat with RTX“ eingeführt, einen Chatbot für Windows-PCs, der auf TensorRT-LLM basiert und auf den neuesten RTX-GPUs kostenlos verfügbar ist.

NVIDIA möchte ChatGPT durch seinen eigenen lokal verfügbaren „Chat With RTX“-KI-Chatbot ersetzen, der kostenlos auf RTX 30- und 40-GPUs verfügbar ist

Der Nutzen des „Chat with RTX“-Chatbots ist sehr einfach, er ist als lokalisiertes System konzipiert, was bedeutet, dass Ihnen jederzeit ein personalisierter GPT-Chatbot auf Ihrem PC zur Verfügung steht, ohne dass Sie online gehen müssen. Der Chat mit RTX kann vollständig personalisiert werden, indem ein Datensatz verwendet wird, der lokal auf Ihrem PC verfügbar ist. Das Beste daran ist, dass er auf fast allen RTX 40- und RTX 30-GPUs läuft.

Beginnen wir mit den Details: Chat with RTX nutzt NVIDIAs TensorRT-LLM & Retrieval Augmented Generated (RAG)-Software, die letztes Jahr für Windows-PCs angekündigt wurde, und nutzt die auf RTX-Hardware verfügbare RTX-Beschleunigung voll aus, um Benutzern das bestmögliche Erlebnis zu bieten. Auch hier wird die Anwendung auf allen GeForce RTX 30- und 40-GPUs mit mindestens 8 GB Videospeicher unterstützt.

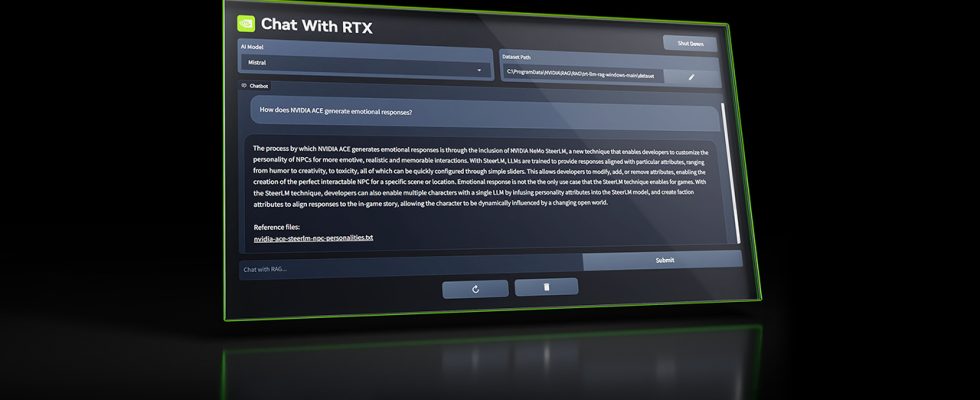

Nachdem Benutzer „Chat with RTX“ kostenlos heruntergeladen haben, können sie es mit einem lokalen Datensatz verbinden, der auf dem PC verfügbar ist (.txt, .pdf, .doc, .docx, .xml) und es mit einem großen Sprachmodell wie Mistral und verbinden Lama 2. Sie können auch spezifische URLs hinzufügen, beispielsweise für YouTube-Videos oder ganze Playlists, um die Suchergebnisse des Datensatzes weiter zu verbessern. Nach der Verbindung können Benutzer Chat With RTX auf die gleiche Weise verwenden wie ChatGPT, indem sie verschiedene Abfragen ausführen. Die generierten Ergebnisse basieren jedoch vollständig auf dem spezifischen Datensatz, sodass Sie im Vergleich zu Online-Methoden bessere Antworten erhalten.

Wenn Sie über eine NVIDIA RTX-GPU verfügen, die TensorRT-LLM unterstützt, stehen Ihnen alle Ihre Daten und Projekte lokal zur Verfügung, anstatt sie in der Cloud zu speichern. Dies würde Zeit sparen und präzisere Ergebnisse liefern. RAG oder Retrieval Augamanted Generation ist eine der Techniken, die verwendet werden, um KI-Ergebnisse schneller zu machen, indem eine lokalisierte Bibliothek verwendet wird, die mit dem Datensatz gefüllt werden kann, den das LLM durchgehen soll, und dann die Sprachuntertreibungsfunktionen dieses LLM nutzt, um Ihnen genaue Ergebnisse zu liefern Ergebnisse.

NVIDIA gibt eine 5-fache Leistungssteigerung mit TensorRT-LLM v0.6.0 an, das später in diesem Monat verfügbar sein wird. Darüber hinaus wird es auch die Unterstützung weiterer LLMs wie Mistral 7B und Nemotron 3 8B ermöglichen.

Sie können die „Chat with RTX“-Anwendung von NVIDIA hier herunterladen. Es wird sowohl von Windows 11- als auch von Windows 10-PCs unterstützt und erfordert für eine optimale Leistung die neuesten NVIDIA-GPU-Treiber.