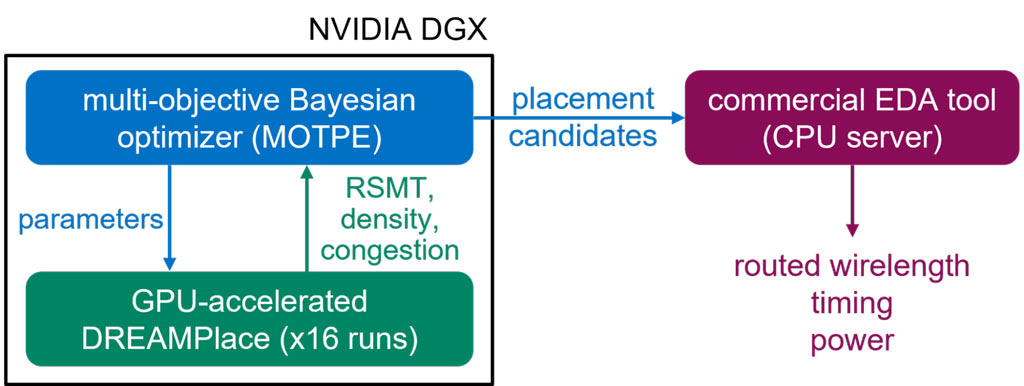

Nvidia ist einer der führenden Designer von Chips, die für die Beschleunigung von künstlicher Intelligenz (KI) und maschinellem Lernen (ML) verwendet werden. Daher ist es passend, dass es einer der Pioniere bei der Anwendung von KI auf das Chipdesign sein wird. Heute veröffentlichte es a Papier (öffnet in neuem Tab) Und Blogeintrag (öffnet in neuem Tab) Es zeigt, wie das AutoDMP-System das moderne Chip-Floor-Planning mithilfe von GPU-beschleunigter KI/ML-Optimierung beschleunigen kann, was zu einer 30-fachen Beschleunigung gegenüber früheren Methoden führt.

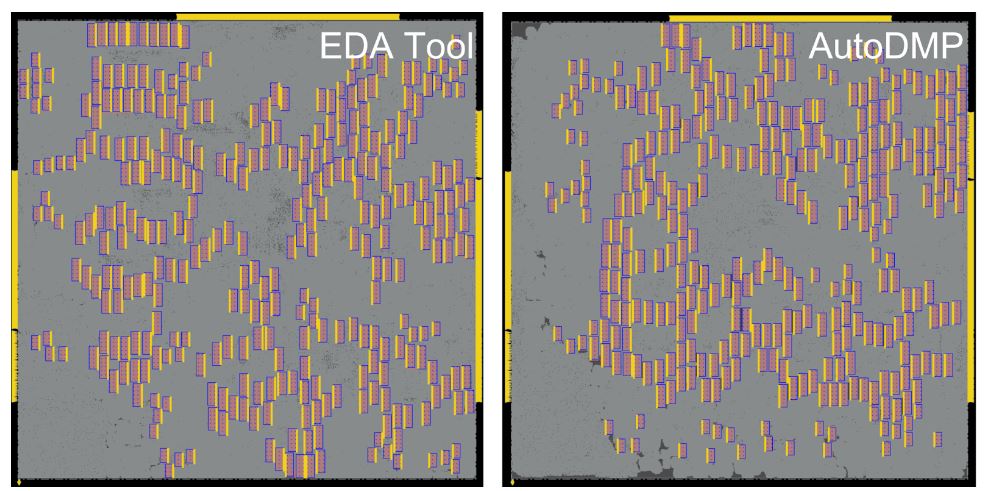

AutoDMP ist die Abkürzung für Automated DREAMPlace-based Macro Placement. Es ist so konzipiert, dass es in ein Electronic Design Automation (EDA)-System eingesteckt werden kann, das von Chipdesignern verwendet wird, um den zeitaufwändigen Prozess der Suche nach optimalen Platzierungen für die Bausteine von Prozessoren zu beschleunigen und zu optimieren. In einem von Nvidias Beispielen für AutoDMP bei der Arbeit nutzte das Tool seine KI für das Problem, ein optimales Layout von 256 RSIC-V-Kernen zu bestimmen, die 2,7 Millionen Standardzellen und 320 Speichermakros ausmachen. AutoDMP benötigte 3,5 Stunden, um ein optimales Layout auf einer einzelnen Nvidia DGX Station A100 zu finden.

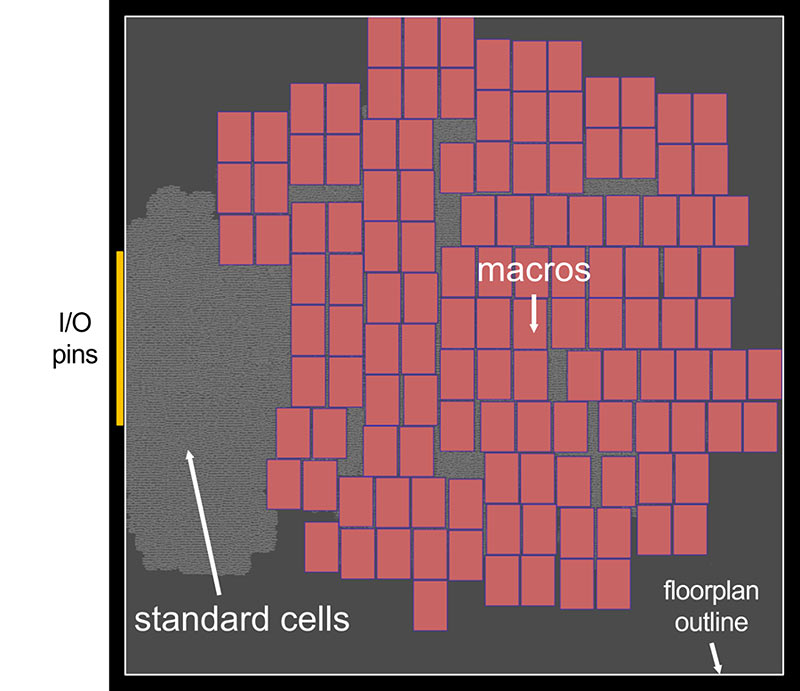

Die Makroplatzierung hat einen erheblichen Einfluss auf die Landschaft des Chips und „beeinflusst direkt viele Designmetriken wie Fläche und Stromverbrauch“, stellt Nvidia fest. Die Optimierung der Platzierung ist eine zentrale Designaufgabe bei der Optimierung der Chipleistung und -effizienz, die sich direkt auf den Kunden auswirkt.

Zum Thema, wie AutoDMP funktioniert, sagt Nvidia, dass sein analytischer Placer „das Platzierungsproblem als Drahtlängenoptimierungsproblem unter einer Platzierungsdichtebeschränkung formuliert und es numerisch löst“. GPU-beschleunigte Algorithmen liefern eine bis zu 30-fache Beschleunigung im Vergleich zu früheren Platzierungsmethoden. Darüber hinaus unterstützt AutoDMP Zellen unterschiedlicher Größe. In der oberen Animation sehen Sie, wie AutoDMP Makros (rot) und Standardzellen (grau) platziert, um die Drahtlänge in einem eingeschränkten Bereich zu minimieren.

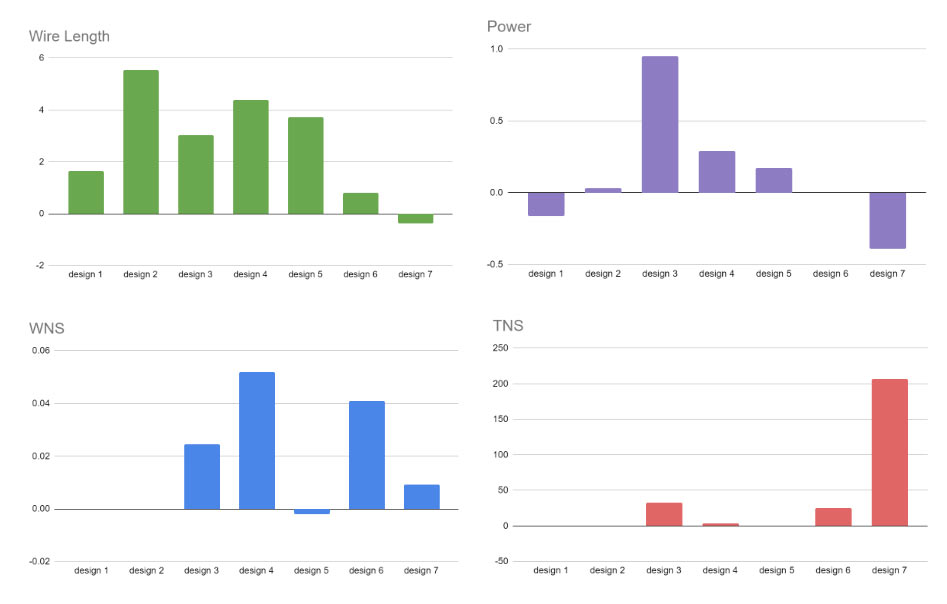

Wir haben über die Vorteile der Designgeschwindigkeit bei der Verwendung von AutoDMP gesprochen, aber noch nicht auf die qualitativen Vorteile eingegangen. In der obigen Abbildung sehen Sie, dass der AutoDMP-optimierte Chip im Vergleich zu sieben alternativen vorhandenen Designs für einen Testchip klare Vorteile in Bezug auf Drahtlänge, Leistung, schlechtesten negativen Slack (WNS) und gesamten negativen Slack (TNS) bietet. Ergebnisse über dem Strich sind ein Sieg von AutoDMP gegenüber den verschiedenen konkurrierenden Designs.

AutoDMP ist Open Source, der Code ist veröffentlicht auf GitHub.

Nvidia ist nicht der erste Chipdesigner, der KI für optimale Layouts nutzt; Bereits im Februar berichteten wir über Synopsys und sein Automatisierungstool DSO.ai, das bereits für 100 kommerzielle Tape-Outs verwendet wurde. Synopsys beschrieb seine Lösung als „Experteningenieur in einer Box“. Es fügte hinzu, dass sich DSO.ai hervorragend für trendige Multi-Die-Siliziumdesigns eignet und seine Verwendung Ingenieure von langweiliger iterativer Arbeit befreien würde, sodass sie ihre Talente für mehr Innovation einsetzen könnten.