Nvidia hat gerade einige neue Leistungszahlen für seine H100-Rechen-GPU in veröffentlicht MLPerf 3.0, die neueste Version eines bekannten Benchmarks für Deep-Learning-Workloads. Der Hopper H100-Prozessor übertrifft seinen Vorgänger A100 nicht nur bei Time-to-Train-Messungen, sondern gewinnt dank Softwareoptimierungen an Leistung. Darüber hinaus enthüllte Nvidia auch frühe Leistungsvergleiche seiner kompakten L4-Compact-Compute-GPU mit seinem Vorgänger, der T4-GPU.

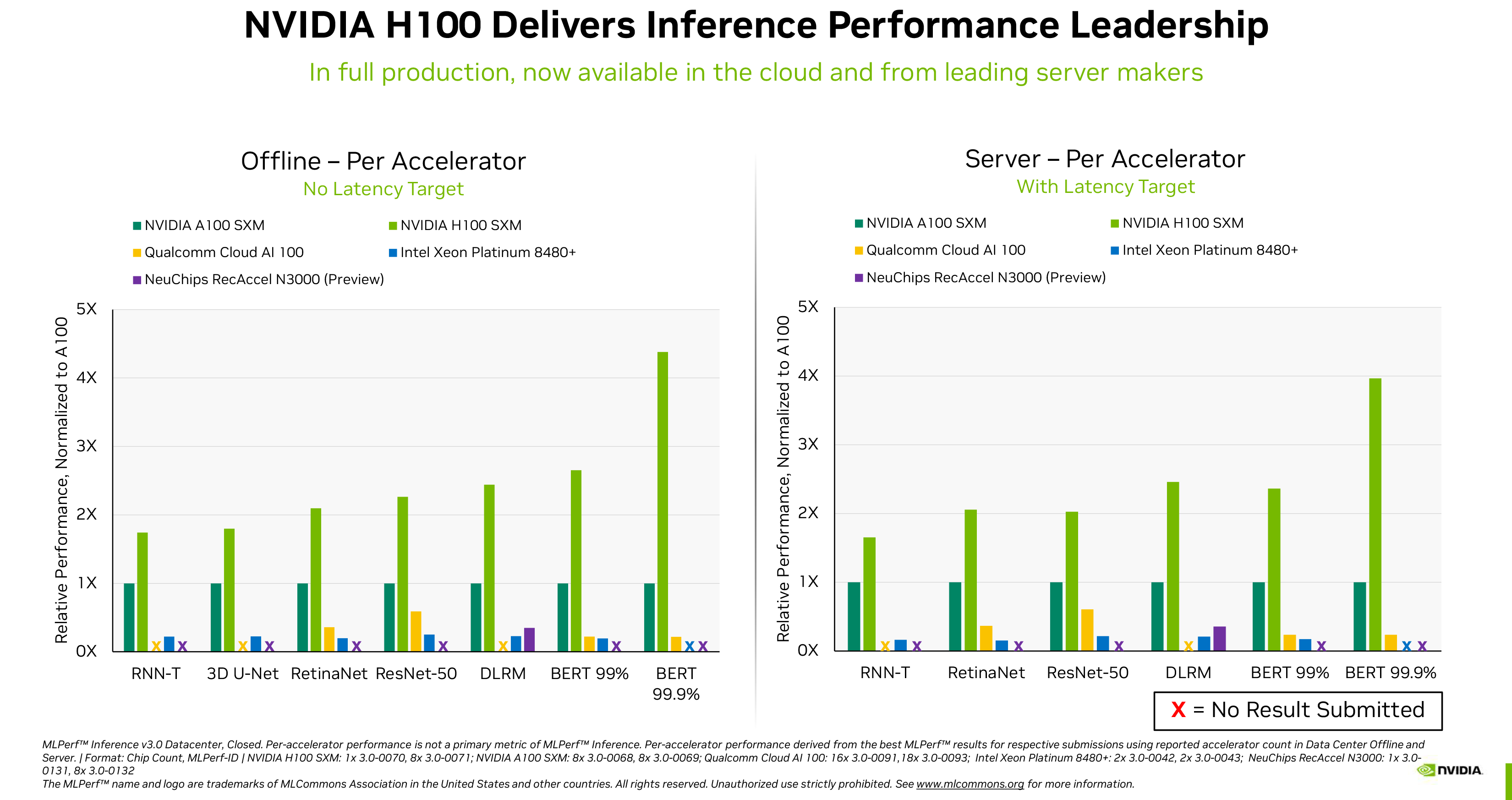

Nvidia veröffentlichte erstmals H100-Testergebnisse, die in der MLPerf 2.1-Benchmark bereits im September 2022 und enthüllte, dass seine Flaggschiff-Rechen-GPU seinen Vorgänger A100 bei verschiedenen Inferenz-Workloads um das 4,3- bis 4,4-fache schlagen kann. Die neu veröffentlichten Leistungszahlen von MLPerf 3.0 bestätigen nicht nur, dass Nvidias H100 schneller ist als sein A100 (keine Überraschung), sondern bekräftigen erneut, dass es auch spürbar schneller ist als Intels kürzlich veröffentlichter Xeon Platinum 8480+ (Sapphire Rapids) Prozessor sowie der von NeuChips ReccAccel N3000 und Cloud AI 100-Lösungen von Qualcomm in einer Vielzahl von Workloads

Diese Workloads umfassen Bildklassifizierung (ResNet 50 v1.5), Verarbeitung natürlicher Sprache (BERT Large), Spracherkennung (RNN-T), medizinische Bildgebung (3D U-Net), Objekterkennung (RetinaNet) und Empfehlung (DLRM). Nvidia weist darauf hin, dass seine GPUs nicht nur schneller sind, sondern auch eine bessere Unterstützung in der gesamten ML-Branche haben – einige der Workloads sind bei konkurrierenden Lösungen fehlgeschlagen.

Einen Haken gibt es allerdings bei den von Nvidia veröffentlichten Zahlen. Anbieter haben die Möglichkeit, ihre MLPerf-Ergebnisse in zwei Kategorien einzureichen: geschlossen und offen. In der geschlossenen Kategorie müssen alle Anbieter mathematisch äquivalente neuronale Netze betreiben, während sie in der offenen Kategorie die Netze modifizieren können, um ihre Leistung für ihre Hardware zu optimieren. Die Zahlen von Nvidia spiegeln nur die geschlossene Kategorie wider, sodass Optimierungen, die Intel oder andere Anbieter vornehmen können, um die Leistung ihrer Hardware zu optimieren, in diesen Gruppenergebnissen nicht berücksichtigt werden.

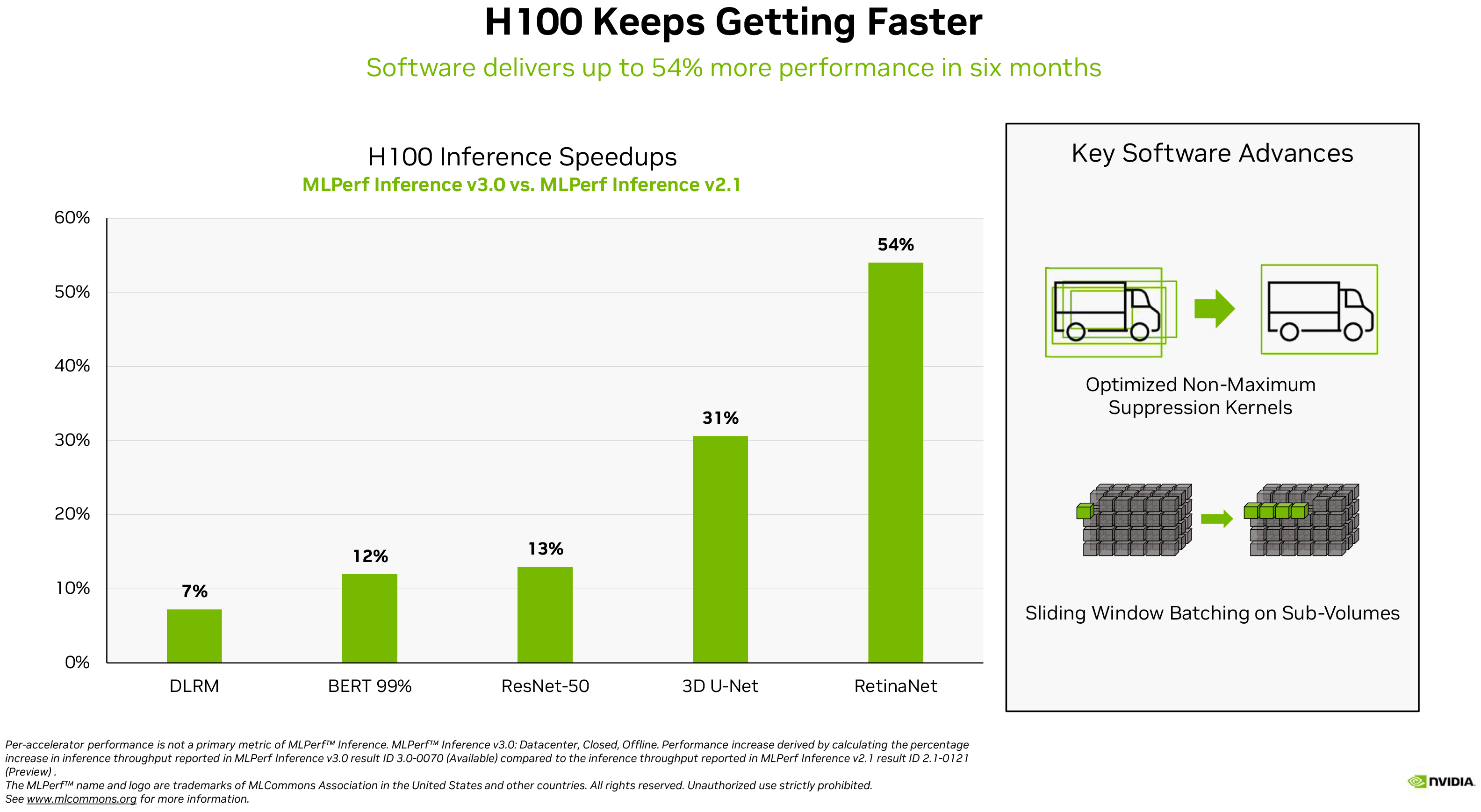

Softwareoptimierungen können moderner KI-Hardware enorme Vorteile bringen, wie Nvidias eigenes Beispiel zeigt. Der H100 des Unternehmens hat mit MLPerf 3.0 im Vergleich zu MLPerf 2.1 zwischen 7 % bei Empfehlungs-Workloads und 54 % bei Objekterkennungs-Workloads zugelegt, was eine beträchtliche Leistungssteigerung darstellt.

Unter Bezugnahme auf die Explosion von ChatGPT und ähnlichen Diensten schreibt Dave Salvator, Direktor für KI, Benchmarking und Cloud bei Nvidia, in einem Blogbeitrag: „In diesem iPhone-Moment der KI ist die Leistung bei der Inferenz von entscheidender Bedeutung … Deep Learning wird jetzt fast überall eingesetzt, was einen unersättlichen Bedarf an Inferenzleistung von Fabrikhallen bis hin zu Online-Empfehlungssystemen antreibt.”

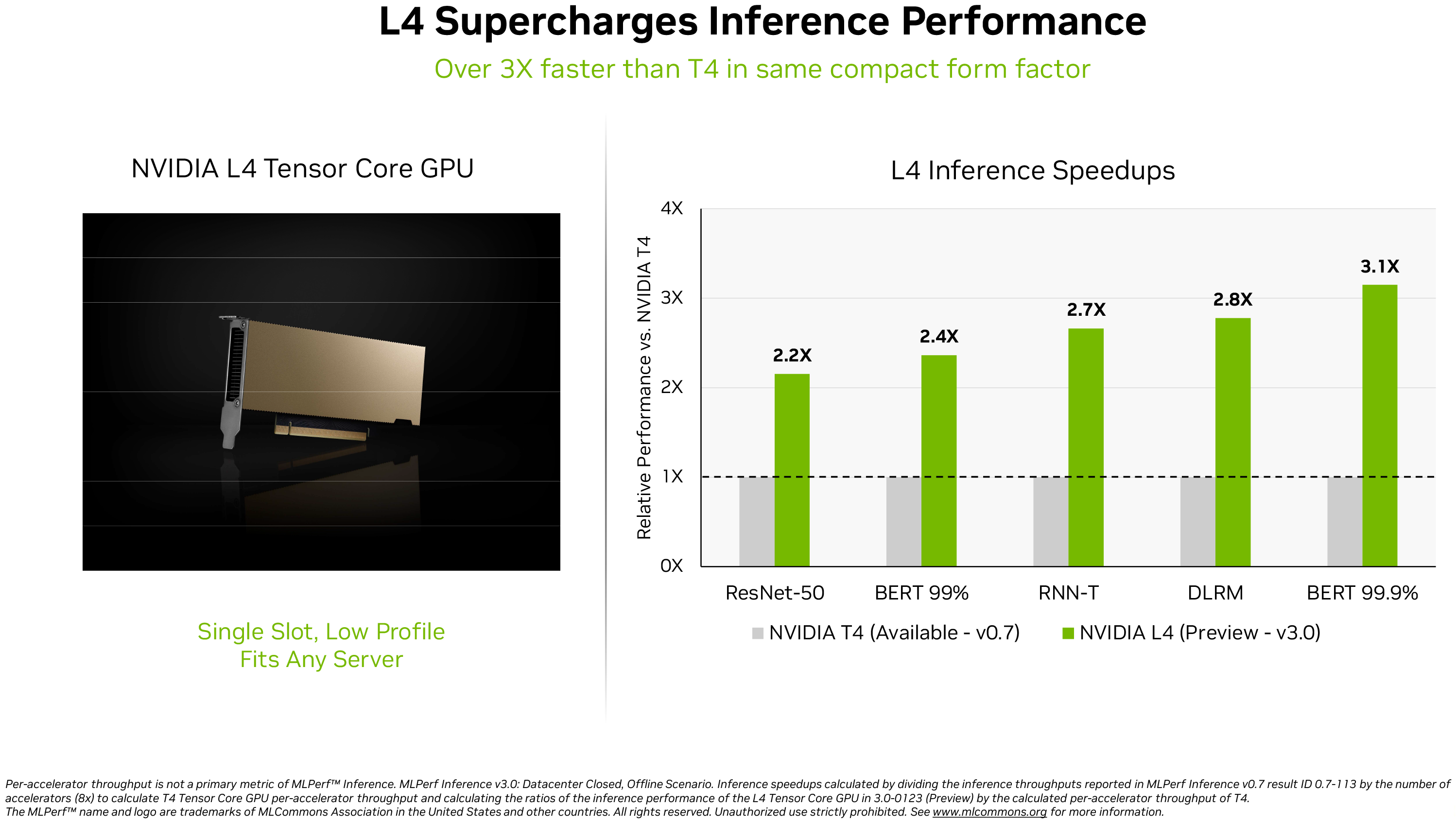

Neben der erneuten Bestätigung, dass sein H100 der König der Inferenzleistung in MLPerf 3.0 ist, gab das Unternehmen auch einen kleinen Einblick in die Leistung seines kürzlich veröffentlichten Produkts AD104-basierte L4-Rechen-GPU (öffnet in neuem Tab). Diese von Ada Lovelace betriebene Computing-GPU-Karte ist in einem Low-Profile-Formfaktor mit einem Steckplatz erhältlich, um in jeden Server zu passen, und liefert dennoch eine beeindruckende Leistung: bis zu 30,3 FP32 TFLOPS für allgemeines Computing und bis zu 485 FP8 TFLOPS (mit Sparsity ).

Nvidia verglich seinen L4 nur mit einem seiner anderen kompakten Rechenzentrums-GPUs, dem T4. Letztere basiert auf der TU104-GPU mit Turing-Architektur aus dem Jahr 2018, sodass es kaum verwundert, dass die neue GPU je nach Auslastung 2,2- bis 3,1-mal schneller ist als der Vorgänger in MLPerf 3.0.

„Zusätzlich zur herausragenden KI-Leistung liefern L4-GPUs eine bis zu 10-mal schnellere Bilddecodierung, eine bis zu 3,2-mal schnellere Videoverarbeitung und eine über 4-mal schnellere Grafik- und Echtzeit-Rendering-Leistung“, schrieb Salvator.

Ohne Zweifel sehen die Benchmark-Ergebnisse der H100- und L4-Compute-GPUs von Nvidia – die bereits von großen Systemherstellern und Cloud-Service-Providern angeboten werden – beeindruckend aus. Beachten Sie jedoch, dass wir es mit Benchmark-Zahlen zu tun haben, die von Nvidia selbst veröffentlicht wurden, und nicht mit unabhängigen Tests.