Endlich Microsoft enthüllt seine erste Charge „selbst entwickelter“ KI-Chips, der Azure Maia AI Accelerator und die Azure Cobalt ARM-CPU, die darauf abzielen, modernste Rechenleistung zu erreichen.

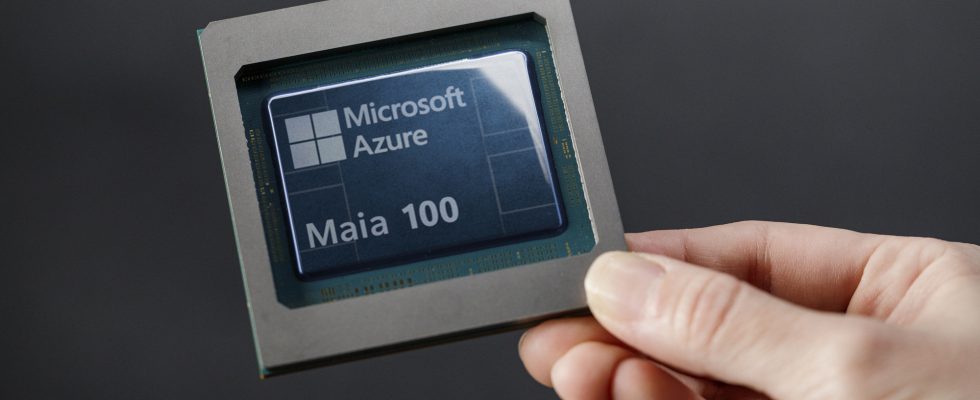

Microsoft stellt das erste benutzerdefinierte KI- und Compute-Silizium vor: Lernen Sie Azure Maia 100 und Azure Cobalt 100 kennen

Werfen wir nun einen Blick auf einige Faktoren, die tatsächlich dazu geführt haben, dass Microsoft auf interne KI-Lösungen umgestiegen ist. Die erste besteht darin, sich von der Konkurrenz abzuheben, da Microsoft derzeit im „KI-Wettbewerb“ weit vorne liegt, vor allem weil das Unternehmen gut dabei ist, generative KI-Funktionen in sein gesamtes Portfolio zu integrieren, einschließlich Mainstream- und Unternehmensanwendungen.

Der zweite Grund besteht darin, die Abhängigkeit von der gesamten „Lieferkette“ zu verringern, da der gesamte Markt derzeit auf bestimmte Lieferanten beschränkt ist. Zu nennen sind hier insbesondere NVIDIA und TSMC, die mit riesigen Auftragsrückständen konfrontiert sind.

Auf der heutigen Microsoft Ignite-Veranstaltung gab das Unternehmen eine Erklärung ab, in der es enthüllte, dass es plant, die Zügel selbst in die Hand zu nehmen. Microsoft ist der Ansicht, dass die Einführung selbst entwickelter KI-Komponenten „ein letztes Puzzleteil“ ist, wenn es darum geht, seinen Kunden und Partnern eine erstklassige Infrastruktur bereitzustellen, und dass es einen Schritt zur Verringerung der Abhängigkeiten von den Zulieferern der Branche darstellt.

Microsoft baut die Infrastruktur zur Unterstützung von KI-Innovationen auf und wir überdenken jeden Aspekt unserer Rechenzentren neu, um den Anforderungen unserer Kunden gerecht zu werden.

In der Größenordnung, in der wir tätig sind, ist es für uns wichtig, jede Ebene des Infrastruktur-Stacks zu optimieren und zu integrieren, um die Leistung zu maximieren, unsere Lieferkette zu diversifizieren und unseren Kunden Wahlmöglichkeiten bei der Infrastruktur zu geben.

-Scott Guthrie, Executive Vice President der Cloud + AI Group von Microsoft

Die Einführung der benutzerdefinierten KI-Produkte von Microsoft ist keine Überraschung, da Gerüchten zufolge das Unternehmen schon seit langem eigene Lösungen entwickelt. Der Vorteil von Microsoft besteht darin, dass es die KI-Chips entsprechend der unternehmenseigenen Cloud- und KI-Workloads „optimieren“ kann. Durch die Nutzung der Leistungsfähigkeit bereits erstellter Softwareressourcen plant Microsoft, Hardware zu kombinieren, um ein Endprodukt zu schaffen, das dem Unternehmen dabei helfen wird, sich in Zukunft in Bezug auf Leistung, Leistung, Nachhaltigkeit und Kosten weiterzuentwickeln.

Kommen wir nun zu den interessanteren Aspekten: Es ist leider traurig, mitteilen zu müssen, dass Microsoft keinerlei Spezifikationen oder Statistiken zu einem seiner KI-Chips veröffentlicht hat, das Unternehmen jedoch verraten hat, dass sein KI-Beschleuniger Maia bereits von OpenAI übernommen wurde Da der Beschleuniger speziell auf den Azure-Hardware-Stack ausgerichtet ist und mit den generationsübergreifenden Verbesserungen beim Chipdesign und der KI-Infrastruktur, glaubt Microsoft, dass das Unternehmen mit seinem Produkt „enorme Gewinne“ erzielen könnte.

Um auf die technischen Aspekte einzugehen: Microsoft Azure Maia 100 ist ein ASIC, der auf dem 5-nm-Knoten von TSMC basiert und einen x86-Host verwendet. Der Chip wird in maßgeschneiderten flüssigkeitsgekühlten Racks montiert, die bis zu 4 Chips bieten. Der Chip unterstützt die Standarddatenformate INT8 und INT4 und nutzt eingebettete Ethernet-Schnittstellen.

Wir waren begeistert, als Microsoft erstmals seine Entwürfe für den Maia-Chip vorstellte, und wir haben gemeinsam daran gearbeitet, ihn zu verfeinern und mit unseren Modellen zu testen. Die End-to-End-KI-Architektur von Azure, die jetzt mit Maia bis hin zum Silizium optimiert wurde, ebnet den Weg für das Training leistungsfähigerer Modelle und macht diese Modelle für unsere Kunden kostengünstiger

-Sam Altman, CEO von OpenAI

Die Microsoft Azure Cobalt 100-CPU basiert auf einer ARM-Architektur, und Microsoft ist davon überzeugt, dass das britische Unternehmen über die besten Designs auf dem Markt verfügt, die es ihnen ermöglichen, die maximale „Leistung pro Watt“ für die Rechenzentren des Unternehmens herauszuholen. Das Unternehmen hat insgesamt 128 Neoverse N2-Kerne mit 12-Kanal-DDR5-Speicherunterstützung und bis zu 40 % höherer Leistung pro Kern im Vergleich zu den bisherigen ARM-Serverchips vorgestellt.

Welche Auswirkungen hätte die Branche mit Microsofts eigenen KI-Chips? Nun, es ist sicher, dass es die Wettbewerbsfähigkeit steigern würde, aber das lässt sich zum jetzigen Zeitpunkt noch nicht abschließend beurteilen, da uns keinerlei Leistungsstatistiken vorliegen, die unsere Schlussfolgerung stützen könnten. Was Microsoft bekannt gegeben hat, ist, dass die Azure AI- und Azure CPU-Plattformen durch einen vollständig maßgeschneiderten Ansatz unterstützt werden, der individuell abgestimmte Treiber und individuelle Lieferzeitrahmen umfasst.

Der Ansatz, auf selbst hergestellte Produkte umzusteigen, ist jedoch schon seit langem auf dem Vormarsch, und Microsoft glaubt, dass in der Branche ein Bedarf an etwas anderem besteht. Es wird interessant sein zu sehen, wie der KI-Beschleuniger Azure Maia 100 und der CPU-Stack Azure Cobalt 100 zu den Angeboten der Branche gehören, aber Konkurrenten sollten vorsichtig bleiben. Microsoft wird Azure-Cloud-Dienste weiterhin mit Silizium von Drittanbietern anbieten, da das Unternehmen bereits neue NVIDIA Hopper H100- und H200-Instanzen angekündigt hat, und wird außerdem AMDs kommende Instinct MI300X- und EPYC-Plattform der 4. Generation zur Stromversorgung von VMs nutzen.