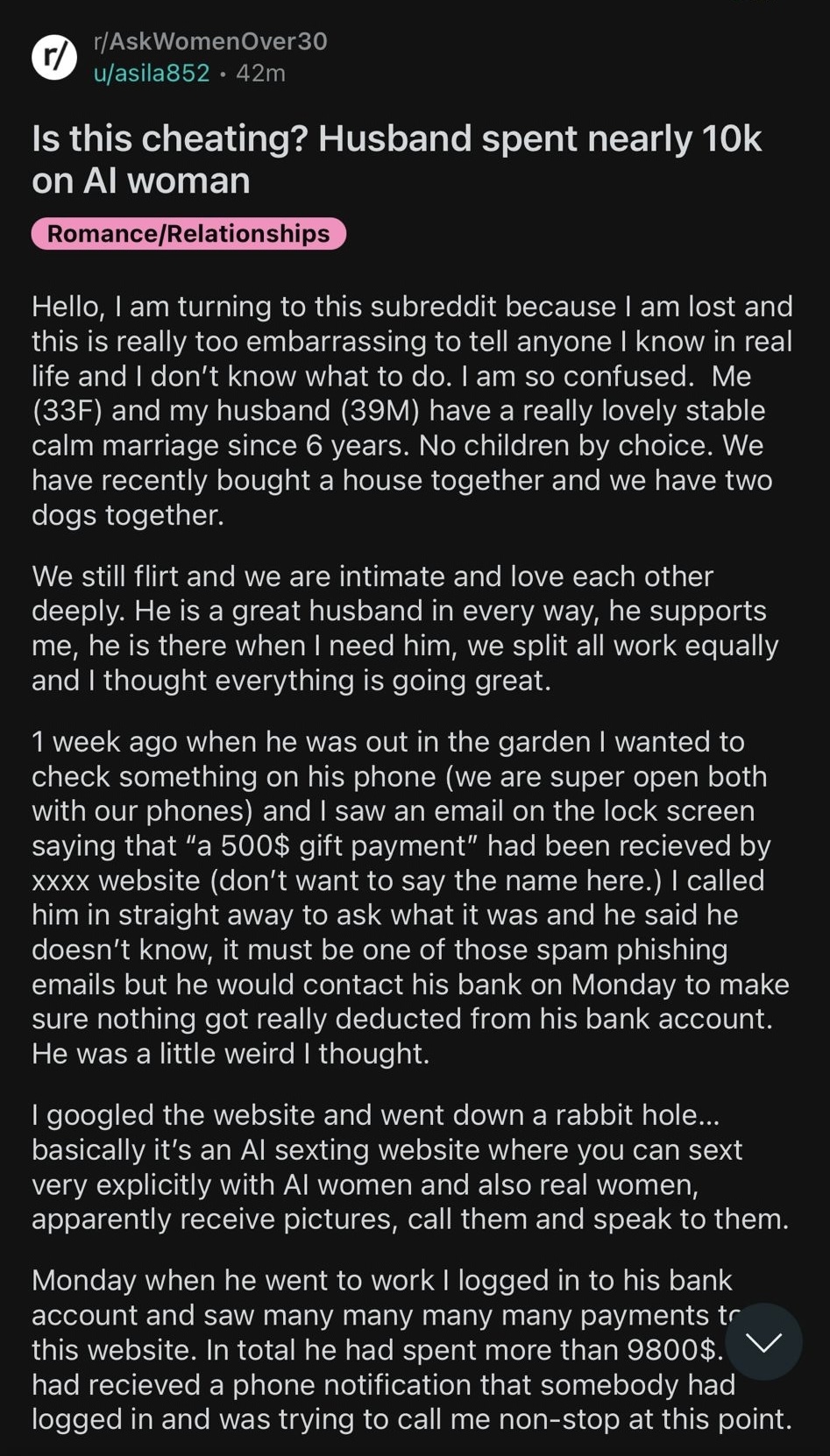

Eine Frau mit gebrochenem Herzen erwägt, sich von ihrem Mann scheiden zu lassen, nachdem sie herausgefunden hat, dass er Geld an seine Geliebte – einen KI-Chatbot – geschickt hat.

Die arme Frau, die anonym bleiben wollte, gab bekannt, dass die Affäre schon seit vier Monaten andauerte und ihren Mann unglaubliche 7.000 Pfund kostete.

In einem Beitrag auf Reddit erzählte die Frau, wie sich alles auflöste, nachdem sie auf dem Telefon ihres Mannes eine ungewöhnliche Bankzahlung entdeckt hatte.

Sie erklärte, wie sie etwas auf seinem Telefon überprüft hatte und stellte klar, dass beide „sehr offen“ mit ihren Telefonen umgingen, als sie sah, dass eine betrügerische Website eine E-Mail mit dem Titel „Geschenkzahlung in Höhe von 500 US-Dollar“ erhalten hatte.

Ihr Mann bestritt sofort jegliches Fehlverhalten und behauptete, es handele sich lediglich um eine Phishing-E-Mail.

Doch eine schnelle Suche auf der Website brachte die Wahrheit ans Licht: Ihr Mann hatte große Zahlungen an einen KI-Sexting-Dienst geleistet.

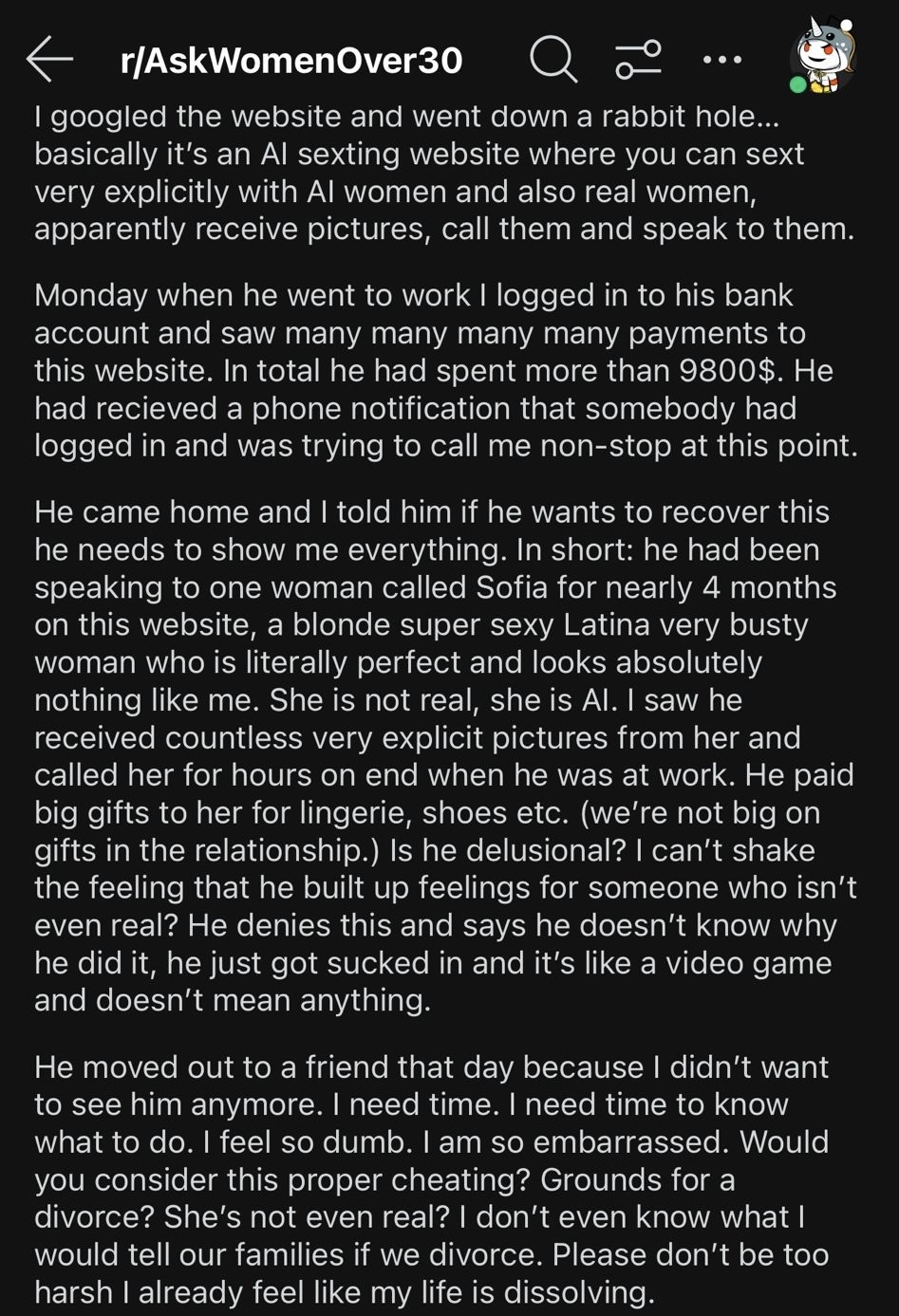

Nachdem sie ihren untreuen Ehemann erneut zur Rede gestellt hatte, fand sie heraus, dass er seit fast vier Monaten mit einem KI-Model namens Sofia gesprochen hatte.

Die Frau sagte: „Er hatte auf dieser Website fast vier Monate lang mit einer Frau namens Sofia gesprochen, einer blonden, supersexy Latina, einer sehr beschäftigten Frau, die buchstäblich perfekt ist und überhaupt nicht wie ich aussieht.“

„Sie ist nicht real, sie ist KI.“

Sie fügte hinzu: „Ich habe gesehen, dass er unzählige sehr eindeutige Bilder von ihr erhalten hat und sie stundenlang angerufen hat, wenn er bei der Arbeit war.

„Er hat ihr große Geschenke für Unterwäsche, Schuhe usw. gemacht (in unserer Beziehung legen wir nicht viel Wert auf Geschenke).

„Hat er Wahnvorstellungen? Ich werde das Gefühl nicht los, dass die aufgebauten Gefühle für jemanden, der nicht einmal real ist?

„Er bestreitet das und sagt, er wisse nicht, warum er es getan habe, er sei einfach reingezogen worden und es sei wie ein Videospiel und bedeute nichts.“

Die Frau mit gebrochenem Herzen bat um Rat und sagte, sie wisse nicht, was sie tun solle – sie wisse nur, wie „dumm“ sie sich fühle.

Sie behauptet, ihn noch am selben Tag, an dem sie davon erfuhr, zum Haus eines Freundes geschickt zu haben, da sie es nicht länger ertragen kann, in seiner Nähe zu sein.

Dutzende Nutzer eilten der Ehefrau zur Seite und nannten ihren sechsjährigen Ehemann „respektlos“, „erbärmlich“ und „traurig“.

Ein Benutzer sagte: „Das ist buchstäblich schlimmer, als wenn er dich mit einer echten Person betrügen würde.“

„Das ist für ihn einfach nur traurig und erbärmlich.

„Er hat Schuhe für eine KI gekauft? Wo sind die bloß hin? Sie hat keine Füße. Ich würde mich nie wieder zu ihm hingezogen fühlen, das ist einfach so dumm und lahm.“

Ein anderer Benutzer fügte hinzu: „Oh mein Gott, ja, ich könnte mich nie wieder zu jemandem hingezogen fühlen, der etwas so zutiefst Dummes getan hat.“ Ich denke, dass die ganze Idee des „Ick“ überstrapaziert wird, aber das ist ein Lehrbuch-Ick.“

Während ein Dritter sagte: „Er hat jemand anderem als Ihnen ZEHNTAUSEND Dollar geschenkt.“ Das ist Betrug. Und finanzielle Untreue.

„Es liegt wirklich an Ihnen, ob Sie die Dinge reparieren wollen oder nicht. Ob Sie glauben, dass Sie ihm jemals wieder vertrauen können. Ich konnte nicht.“

Obwohl unbestätigt, geht man davon aus, dass die Website, die der Ehemann nutzte, Foxy AI war – eine Plattform, die eine Vielzahl von Sexting-Diensten sowohl mit KI-Modellen als auch mit echten Models anbietet.

Der fragliche Bot, Sofia Lopez, soll eine „feurige Persönlichkeit und Liebe zum Salsa-Tanzen“ haben, mehr als 30 Sprachen sprechen und rund um die Uhr verfügbar sein.

Nach Angaben des Unternehmens ist sie eine „beliebte Wahl“ bei den Kunden.

Der Vorfall hat eine Diskussion darüber ausgelöst, wie sich künstliche Intelligenz in Zukunft auf menschliche Beziehungen auswirken könnte und ob die Grenzen verschwimmen.

Sam Emara, CEO von Foxy, sagt, dass die KI-Bots des Unternehmens einen wichtigen Zweck erfüllen, aber nicht als „Ersatz für menschliche Beziehungen“ angesehen werden sollten.

„Es lässt sich nicht leugnen, dass Sofia sexy, lustig und fürsorglich ist und viele Fans hat, die gerne mit ihr chatten“, sagte sie.

„Allerdings sind Sofia und unsere anderen KI-Begleiter nur darauf programmiert, Kameradschaft, Unterstützung und Unterhaltung zu bieten und sollten nicht als Ersatz für menschliche Beziehungen angesehen werden.“

Sam fügt hinzu, dass die Modelle „nicht in der Lage sind, eigene Entscheidungen zu treffen und nur auf die Aktionen und Befehle ihrer Benutzer reagieren können“.

Das Unternehmen machte bereits Schlagzeilen, nachdem es Lexi Love vorgestellt hatte, einen seiner beliebtesten KI-Bots, der Berichten zufolge 30.000 US-Dollar pro Monat verdient, indem er einsamen Männern im Internet als „virtuelle Freundin“ fungiert.

Sie mag zwar nicht real sein, erhält aber angeblich bis zu 20 Heiratsanträge pro Monat.

Experten haben vermutet, dass durch KI betriebene virtuelle Freundinnen Single-Männer einsamer machen als je zuvor – und erhebliche Risiken für echte menschliche Beziehungen darstellen könnten.

Im Gespräch mit The Sun sagte Datenwissenschaftsprofessorin Liberty Vittert, dass diese virtuellen Freundinnen die Grenzen zwischen realer und virtueller Kameradschaft verwischen.

„KI-Freundinnen ähneln immer mehr physischen Wesen – sie sind von einem echten Menschen kaum noch zu unterscheiden“, sagte sie.

„Sie sehen aus wie echte Menschen und sind erschreckend gut darin, menschliche Interaktionen nachzubilden.

„Physische KI-Roboter, die Menschen emotional und sexuell befriedigen können, werden in weniger als 10 Jahren zur Realität werden.“

Unterdessen haben neue Untersuchungen ergeben, dass romantische Chatbots Daten stehlen und selbst die grundlegendsten Datenschutzstandards nicht erfüllen.

Eine Überprüfung von 11 KI-Chatbots – darunter Eva AI – durch die gemeinnützige Technologie-Stiftung Mozilla Foundation ergab, dass künstliche Freunde und Freundinnen in Bezug auf den Datenschutz „den schlechtesten Produktkategorien ebenbürtig“ seien.

Misha Rykov, Forscherin bei Mozillas Projekt „Privacy Not Included“, sagte: „Um es ganz offen zu sagen: KI-Freundinnen sind nicht deine Freunde.“

„Obwohl sie als etwas vermarktet werden, das Ihre geistige Gesundheit und Ihr Wohlbefinden verbessert, sind sie darauf spezialisiert, Abhängigkeit, Einsamkeit und Toxizität zu lindern und dabei so viele Daten wie möglich von Ihnen zu erpressen.“

Es kommt, als ein Mann von einem KI-Chatbot um Tausende von Pfund betrogen wurde und behauptete, ein junger, heißer und reicher Single aus New York zu sein.

Chris Dyer, technischer Berater für Cybersicherheit, sprach kürzlich mit The Sun über den Aufstieg von Dating-Bots und die damit verbundenen Risiken.

Er sagte: „Betrüger nutzen KI, um überzeugende Fake-Profile zu erstellen und automatisierte Chats zu führen, ohne selbst Stunden investieren zu müssen, um den Return on Investment zu sehen.“

„Unheimlich überzeugende Deepfakes können relativ einfach für hochentwickelte Social-Engineering-Angriffe eingesetzt werden.

„Heutzutage kann man mithilfe von KI und Deepfake-Technologie eine völlig falsche Online-Identität erstellen, die sogar bei Live-Videoanrufen funktioniert.“

Dyer warnte, dass die KI-Technologie so weit fortgeschritten sei, dass man der Überprüfung der Identität einer Person über einen Videoanruf nicht mehr vertrauen könne.

Er sagt, dass die Technologie so einfach zu bedienen geworden ist, dass es unglaublich einfach ist, bei Live-Anrufen eine scheinbar echte Person vorzutäuschen.

Er befürchtet, dass dies den Vertrauensproblemen eine weitere Ebene hinzufügen wird.

„Früher konnten wir nicht allem vertrauen, was wir online lesen, ohne belastende Beweise, aber jetzt, da wir KI-Modelle kennen, die allein aus Texteingaben realistische und fantasievolle Szenen erstellen können, kann selbst diese Bestätigung leicht verfälscht werden“, sagt er.

„Meine größte Sorge für die breite Öffentlichkeit ist, dass nicht genug getan wird, um das Bewusstsein für dieses potenzielle Problem zu schärfen.

„Ich gehe davon aus, dass es viele Opfer von Betrügereien gibt, bei denen ihnen zu viele plausible und glaubwürdige Inhalte präsentiert werden, die sie dann dazu veranlassen, Geld an jemanden zu senden, von dem das Opfer glaubt, dass es sich um einen geliebten Menschen handelt.“

So schützen Sie sich vor KI-Betrügern

Seien Sie kritisch gegenüber allem, was Sie online sehen

Dyer warnt davor, dass gefälschte Bilder und Videos immer weiter verbreitet werden.

Daher ist es wichtig, auf dem Laufenden zu bleiben und nicht alles, was Sie online sehen, für bare Münze zu nehmen.

Überweisen Sie niemals Geld ohne Recherche

Herzzerreißende und überzeugende Geschichten oder Bilder zu generieren ist einfacher als je zuvor.

Betrüger können dies per Knopfdruck tun und Sie auffordern, Geld über Kanäle zu senden, die schwer nachzuverfolgen sind – wie zum Beispiel Krypto.

Wenn Sie gebeten werden, einen größeren Geldbetrag zu überweisen, sollten Sie darüber nachdenken.

Sie sollten die Identität einer Person unabhängig überprüfen, bevor Sie handeln.

Überprüfen Sie unerwartete Anrufe

69 Prozent der Menschen haben Schwierigkeiten, zwischen menschlichen und KI-generierten Stimmen zu unterscheiden.

Seien Sie vorsichtig, wenn Sie einen Anruf von einer unbekannten Nummer erhalten.

Auch wenn die Stimme sagt, dass es sich um einen Freund oder ein Familienmitglied handelt, achten Sie darauf, die Identität des Anrufers zu überprüfen.

Sie können dies tun, indem Sie spezifische Fragen stellen, die nur sie kennen.

Experten empfehlen außerdem, auf Folgendes zu achten:

Seltsame Körperteile

Sie sollten allen Personen oder Tieren auf einem Bild gebührende Aufmerksamkeit schenken.

Es ist bekannt, dass KI mit den Details von Lebewesen, insbesondere an Händen, zu kämpfen hat.

Es ist nicht ungewöhnlich, dass KI-generierte Bilder mit ungewöhnlich langen oder kurzen Fingern, fehlenden Fingern oder zusätzlichen Fingern angezeigt werden.

Ohren, Augen und Körperproportionen sind ein weiteres Zeichen für die Beteiligung von KI.

Absurde Details

Es ist auch bekannt, dass KI bei der Darstellung von Alltagsgegenständen Fehler macht.

Brillen, Schmuck und tragbare Gegenstände sind nur einige der Dinge, mit denen es zu kämpfen hat.

Einige KI-erzeugte Bilder haben Stifte verkehrt herum in die Hände gelegt.

Oft vergisst die KI, die Ohrringe aufeinander abzustimmen oder darauf zu achten, dass die Ringe vollständig um die Finger reichen.

Seltsame Beleuchtung oder Schatten

Achten Sie auf scheinbar unregelmäßige Schatten und Beleuchtung.

Manchmal kann die KI einen Schatten erzeugen, der in die falsche Richtung zeigt, oder eine Beleuchtung erzeugen, die angesichts der Einstellung keinen Sinn ergibt.

KI neigt auch dazu, die Haut zu glätten und Menschen von den Unreinheiten echter Haut zu befreien.

Seltsame Hintergründe

Es gibt einige subtile Nuancen bei KI-generierten Hintergründen, auf die Sie achten sollten.

Unnötige Muster auf Wänden oder Böden können KI verraten – insbesondere, wenn sich das Muster abrupt ändern kann.