KI, insbesondere generative KI, hat das Potenzial, das Gesundheitswesen zu verändern.

Zumindest ist das das Verkaufsargument Hippokratische KI, das heute mit einer satten Startfinanzierung in Höhe von 50 Millionen US-Dollar und einer Bewertung im „dreistelligen Millionenbereich“ aus der Tarnung hervorkam. Die Tranche, gemeinsam geleitet von Allgemein Katalysator und Andreessen Horowitz ist ein großer Vertrauensbeweis in die Technologie von Hippocratic, einem Textgenerierungsmodell, das speziell auf Anwendungen im Gesundheitswesen abgestimmt ist.

Hippocratic – hervorgegangen aus General Catalyst – wurde von einer Gruppe von Ärzten, Krankenhausverwaltern, Medicare-Experten und KI-Forschern von Organisationen wie Johns Hopkins, Stanford, Google und Nvidia gegründet. Nachdem Mitbegründer und CEO Munjal Shah 2010 sein früheres Unternehmen Like.com, eine Shopping-Vergleichsseite, an Google verkauft hatte, verbrachte er den größten Teil des nächsten Jahrzehnts damit, Hippocratic aufzubauen.

„Hippocratic hat das erste sicherheitsorientierte Large Language Model (LLM) entwickelt, das speziell für das Gesundheitswesen entwickelt wurde“, sagte Shah gegenüber TechCrunch in einem E-Mail-Interview. „Die Mission des Unternehmens besteht darin, die sicherste künstliche Gesundheitsversorgung zu entwickelnallgemein Intelligenz, um die Zugänglichkeit der Gesundheitsversorgung und die Gesundheitsergebnisse erheblich zu verbessern.“

KI im Gesundheitswesen hatte in der Vergangenheit gemischten Erfolg.

Babylon Health, ein KI-Startup, das vom britischen National Health Service unterstützt wird, steht wiederholt in der Kritik, weil es behauptet, seine Technologie zur Krankheitsdiagnose könne bessere Leistungen erbringen als Ärzte. IBM war gezwungen, seine KI-fokussierte Watson Health-Sparte mit Verlust zu verkaufen, nachdem technische Probleme dazu führten, dass sich die Partnerschaften mit wichtigen Kunden verschlechterten. An anderer Stelle forderte OpenAIs GPT-3, der Vorgänger von GPT-4, mindestens einen Benutzer zum Selbstmord auf.

Shah betonte, dass Hippocratic sich nicht auf die Diagnose konzentriere. Er sagt, dass die Technologie – die sich an den Verbraucher richtet – vielmehr auf Anwendungsfälle wie die Erklärung von Leistungen und Abrechnung, die Bereitstellung von Ernährungsratschlägen und Medikamentenerinnerungen, die Beantwortung von Fragen vor der Operation, die Aufnahme von Patienten und die Bereitstellung „negativer“ Testergebnisse, die auf nichts hinweisen, abzielt falsch.

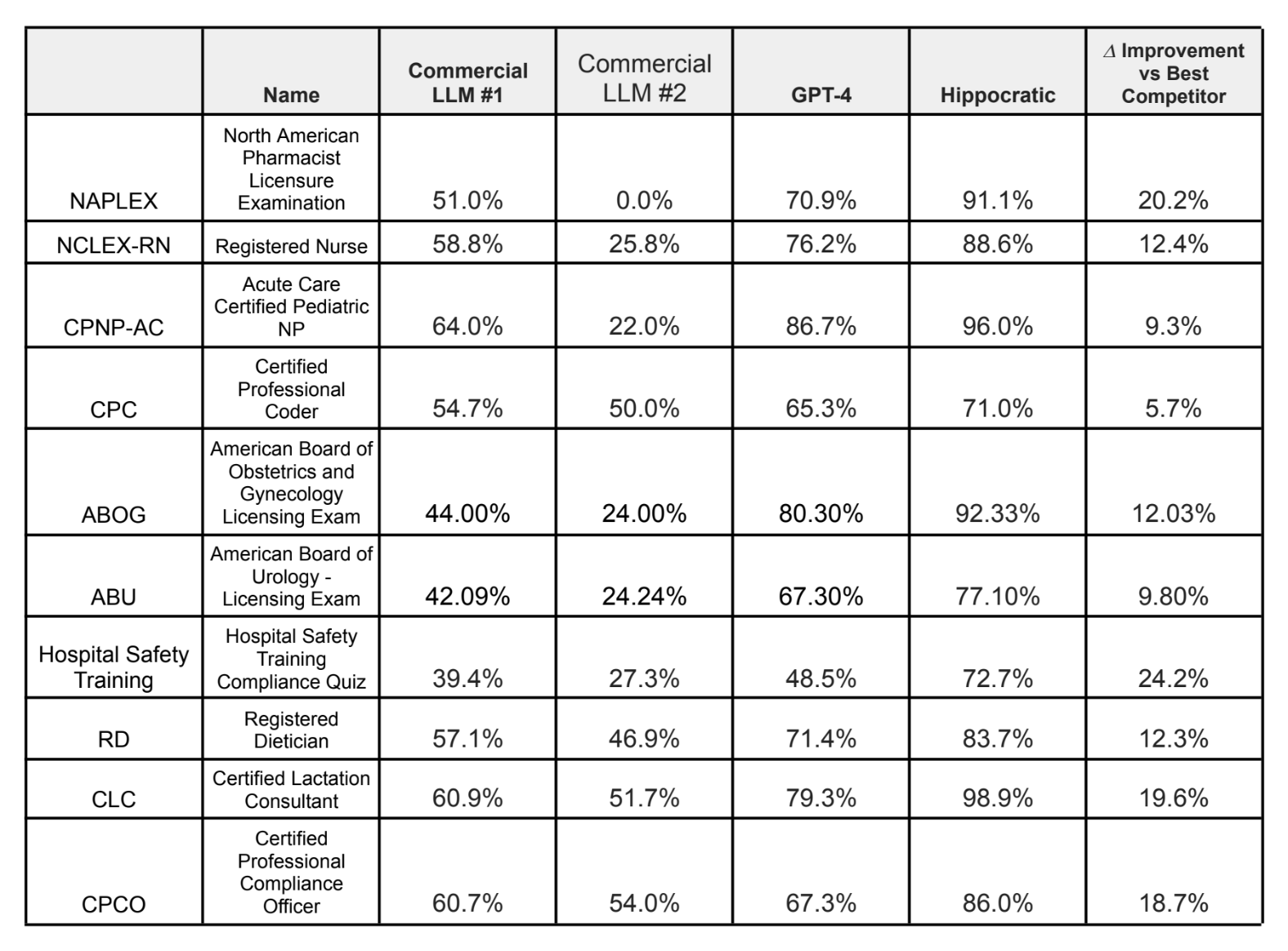

Die Benchmark-Ergebnisse von Hippocratic bei einer Reihe medizinischer Untersuchungen. Bildnachweis: Hippokratisch

Ich muss sagen, dass mich der Anwendungsfall der Ernährungsberatung angesichts der schlechten Ernährungsweise zum Nachdenken gebracht hat Vorschläge KI wie ChatGPT von OpenAI bietet. Shah behauptet jedoch, dass die KI von Hippocratic führende Sprachmodelle wie GPT-4 und Claude bei mehr als 100 Gesundheitszertifizierungen übertrifft, darunter dem NCLEX-RN für Krankenpflege, der Prüfung des American Board of Urology und der Prüfung zum registrierten Ernährungsberater.

„Die Sprachmodelle müssen sicher sein“, sagte Shah. „Deshalb bauen wir ein Modell auf, das sich ausschließlich auf die Sicherheit konzentriert, zertifizieren es bei medizinischem Fachpersonal und arbeiten eng mit der Branche zusammen … Dies wird dazu beitragen, sicherzustellen, dass die Datenaufbewahrungs- und Datenschutzrichtlinien mit den aktuellen Normen der Gesundheitsbranche im Einklang stehen.“

Eine Möglichkeit, wie Hippocratic dies erreichen will, besteht darin, „den Ton zu erkennen“ und „Empathie besser zu kommunizieren“ als konkurrierende Technologien, sagt Shah – unter anderem durch den „Einbau“ guter Manieren am Krankenbett (d. h. der schwer fassbaren „menschlichen Note“). Er argumentiert, dass die Art und Weise, wie Patienten am Krankenbett behandelt werden – insbesondere Interaktionen, die den Patienten selbst unter schwierigen Umständen ein Gefühl der Hoffnung vermitteln – die gesundheitlichen Ergebnisse beeinflussen kann und tatsächlich hat.

Um das Verhalten am Krankenbett zu bewerten, hat Hippocratic einen Maßstab entwickelt, um das Modell auf Anzeichen von Humanismus zu testen, wenn man so will – Dinge wie „Empathie zeigen“ und „persönliches Interesse am Leben eines Patienten zeigen“. (Ob ein einzelner Test nuancierte Themen genau erfassen kann, steht natürlich zur Debatte.) Angesichts der Quelle überrascht es nicht, dass das Modell von Hippocratic in allen Kategorien der von Hippocratic getesteten Modelle, einschließlich GPT-4, die höchste Punktzahl erzielte.

Aber kann ein Sprachmodell wirklich einen Mitarbeiter im Gesundheitswesen ersetzen? Hippocratic wirft diese Frage auf und argumentiert, dass seine Modelle unter der Aufsicht medizinischer Fachkräfte ausgebildet wurden und daher äußerst leistungsfähig seien.

„Wir geben jede Rolle – Ernährungsberater, Abrechnungsagent, genetischer Berater usw. – erst frei, wenn die Leute, die diese Rolle heute im wirklichen Leben tatsächlich ausüben, zustimmen, dass das Modell fertig ist“, sagte Shah. „Während der Pandemie sind die Arbeitskosten in den meisten Gesundheitssystemen um 30 % gestiegen, die Einnahmen jedoch nicht. Daher haben die meisten Gesundheitssysteme des Landes finanzielle Probleme. Sprachmodelle können ihnen helfen, Kosten zu senken, indem sie ihre derzeit großen offenen Stellen kostengünstiger besetzen.“

Ich bin mir nicht sicher, ob die Ärzte dem zustimmen würden – insbesondere angesichts der niedrigen Werte des hippokratischen Modells bei einigen der oben genannten Zertifizierungen. Laut Hippocratic erreichte das Modell 71 % bei der Prüfung zum zertifizierten professionellen Kodierer, die Kenntnisse über medizinische Abrechnung und Kodierung abdeckt, und 72,7 % bei einem Compliance-Quiz für Sicherheitsschulungen im Krankenhaus.

Es gibt auch die Frage einer möglichen Voreingenommenheit. Die Gesundheitsbranche leidet unter Voreingenommenheit, und diese Auswirkungen wirken sich auch auf die Modelle aus, die auf voreingenommenen Krankenakten, Studien und Forschungsergebnissen basieren. Ein 2019 lernenBeispielsweise wurde festgestellt, dass ein Algorithmus, den viele Krankenhäuser verwendeten, um zu entscheiden, welche Patienten Pflege benötigten, schwarze Patienten weniger empfindlich behandelte als weiße Patienten.

Auf jeden Fall würde man hoffen, dass Hippocratic deutlich macht, dass seine Modelle nicht unfehlbar sind. In Bereichen wie dem Gesundheitswesen sind Automatisierungsvoreingenommenheit oder die Neigung der Menschen, KI gegenüber anderen Quellen zu vertrauen, selbst wenn diese korrekt sind, eindeutig mit hohen Risiken verbunden.

Diese Details gehören zu den vielen, die Hippocratic noch klären muss. Das Unternehmen gibt keine Details zu seinen Partnern oder Kunden bekannt, sondern konzentriert sich stattdessen lieber auf die Finanzierung. Das Modell ist derzeit nicht einmal verfügbar – und es gibt auch keine Informationen darüber, auf welchen Daten es trainiert wurde oder auf welchen Daten es in Zukunft trainiert werden könnte. (Hippocratic würde nur sagen, dass es „anonymisierte“ Daten für das Modelltraining verwenden wird.)

Wenn es zu lange wartet, läuft Hippocratic Gefahr, hinter Konkurrenten zurückzufallen Truveta Und Latent – einige davon haben einen großen Ressourcenvorteil. Beispielsweise hat Google kürzlich mit der Vorschau von Med-PaLM 2 begonnen, von dem es behauptet, dass es das erste Sprachmodell sei, das bei Dutzenden von medizinischen Untersuchungsfragen auf Expertenniveau funktionierte. Wie das Modell von Hippocratic wurde Med-PaLM 2 von Gesundheitsexperten auf seine Fähigkeit hin untersucht, medizinische Fragen genau und sicher zu beantworten.

Aber Hemant Taneja, der Geschäftsführer von General Catalyst, äußerte keine Bedenken.

„Munjal und ich haben dieses Unternehmen in der Überzeugung gegründet, dass das Gesundheitswesen ein eigenes Sprachmodell benötigt, das speziell für Gesundheitsanwendungen entwickelt wurde – eines, das fair, unvoreingenommen, sicher und vorteilhaft für die Gesellschaft ist“, sagte er per E-Mail. „Wir haben uns zum Ziel gesetzt, eine hochintegrierte KI-Anwendung zu entwickeln, die mit einer ‚gesunden‘ Datendiät gefüttert wird und einen Trainingsansatz beinhaltet, der darauf abzielt, umfassendes menschliches Feedback von medizinischen Experten für jede spezielle Aufgabe einzubeziehen. Im Gesundheitswesen können wir es uns einfach nicht leisten, schnell zu handeln und Dinge kaputt zu machen.“

Shah sagt, dass der Großteil der Starttranche in Höhe von 50 Millionen US-Dollar für Investitionen in Talente, Computerdaten und Partnerschaften verwendet wird.