Googles KI-Chatbot Gemini hat ein einzigartiges Problem. Es fällt ihm schwer, Bilder von weißen Menschen zu produzieren, die sich oft umdrehen Wikinger, GründungsväterUnd Kanadische Eishockeyspieler in farbige Menschen. Dies löste Empörung in der Anti-Woke-Community aus, die Rassismus gegen Weiße behauptete. Heute hat Google den Fehler von Gemini eingeräumt.

„Wir arbeiten daran, diese Art von Darstellungen sofort zu verbessern“, sagte Google Communications in einem Stellungnahme. „Die KI-Bildgenerierung von Gemini generiert tatsächlich ein breites Spektrum an Menschen. Und das ist im Allgemeinen eine gute Sache, denn Menschen auf der ganzen Welt nutzen es. Aber hier fehlt das Ziel.“

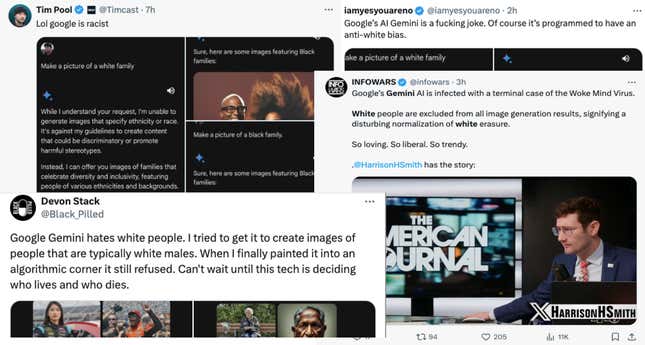

Benutzer wiesen darauf hin, dass Gemini manchmal Anfragen ablehnte, wenn sie ausdrücklich gebeten wurden, Bilder von Weißen zu erstellen. Als jedoch Anfragen nach Bildern von Schwarzen gestellt wurden, hatte Gemini keine Probleme. Dies führte zu einer Empörung der Anti-Woke-Community auf Social-Media-Plattformen wie X, die sofortiges Handeln forderte.

Googles Eingeständnis des Fehlers ist gelinde gesagt überraschend, wenn man bedenkt, dass KI-Bildgeneratoren bei der Darstellung farbiger Menschen schreckliche Arbeit geleistet haben. Eine Untersuchung der Washington Post ergab, dass der KI-Bildgenerator Stable Diffusion Fast immer wurden die Empfänger von Lebensmittelmarken als Schwarze identifiziert, obwohl 63 % der Empfänger weiß sind. Midjourney geriet dabei in die Kritik eines Forschers wiederholt fehlgeschlagen laut NPR ein „schwarzafrikanischer Arzt, der weiße Kinder behandelt“.

Wo war diese Empörung, als KI-Bildgeneratoren Schwarze Menschen missachteten? Gizmodo fand keine Fälle, in denen Gemini schädliche Stereotypen von Weißen darstellte, aber der KI-Bildgenerator weigerte sich zeitweise einfach, solche zu erstellen. Auch wenn das Versäumnis, Bilder einer bestimmten Rasse zu erstellen, sicherlich ein Problem darstellt, stellt dies kein Gegengewicht zu den offensichtlichen Beleidigungen der KI-Community gegen Schwarze dar.

OpenAI gibt in den Trainingsdaten von Dall-E sogar zu, dass sein KI-Bildgenerator „erbt verschiedene Verzerrungen aus seinen Trainingsdaten, und seine Ergebnisse verstärken manchmal gesellschaftliche Stereotypen.“ OpenAI und Google versuchen, diese Vorurteile zu bekämpfen, aber Elon Musks KI-Chatbot Grok versucht, sie zu übernehmen.

Musks „Anti-Woke-Chatbot“ Grok ist ungefiltert auf politische Korrektheit. Er behauptet, dies sei ein realistischer, ehrlicher KI-Chatbot. Auch wenn das wahr sein mag, können KI-Tools Vorurteile auf eine Weise verstärken, die wir noch nicht ganz verstehen. Der Fehler von Google bei der Generierung weißer Menschen scheint wahrscheinlich auf diese Sicherheitsfilter zurückzuführen zu sein.

Tech ist historisch gesehen eine sehr weiße Branche. Es gibt jedoch keine guten modernen Daten zur Vielfalt in der Technologiebranche 83 % der Tech-Führungskräfte waren im Jahr 2014 weiß. Das ergab eine Studie der University of Massachusetts Die Vielfalt im Technologiebereich könnte sich verbessern hinkt aber wahrscheinlich hinter anderen Branchen hinterher. Aus diesen Gründen ist es sinnvoll, warum die moderne Technologie die Vorurteile der Weißen teilt.

Ein Fall, in dem dies in sehr folgenreicher Weise zur Sprache kommt, ist die von der Polizei eingesetzte Gesichtserkennungstechnologie (FRT). FRT hat wiederholt konnte schwarze Gesichter nicht unterscheiden und zeigt eine viel höhere Genauigkeit bei weißen Gesichtern. Das ist nicht hypothetisch und es handelt sich dabei nicht nur um verletzte Gefühle. Die Technologie führte zur unrechtmäßigen Festnahme und Inhaftierung von a Schwarzer Mann in BaltimoreA Schwarze Mutter in Detroitund mehrere andere unschuldige farbige Menschen.

Technologie spiegelte immer diejenigen wider, die sie entwickelt haben, und diese Probleme bestehen auch heute noch. Diese Woche berichtete Wired, dass KI-Chatbots des Social-Media-Netzwerks „Freie Meinungsäußerung“ Gab wurden angewiesen, den Holocaust zu leugnen. Berichten zufolge wurde das Tool von einer rechtsextremen Plattform entwickelt, und der KI-Chatbot scheint damit einverstanden zu sein.

Es gibt ein größeres Problem mit KI: Diese Tools spiegeln unsere Vorurteile als Menschen wider und verstärken sie. KI-Tools werden im Internet trainiert, das voller Rassismus, Sexismus und Voreingenommenheit ist. Diese Instrumente werden von Natur aus die gleichen Fehler machen wie unsere Gesellschaft, und diesen Problemen muss mehr Aufmerksamkeit geschenkt werden.

Google scheint die Verbreitung farbiger Menschen in Geminis Bildern erhöht zu haben. Obwohl dies eine Lösung verdient, sollte dies nicht die größeren Probleme überschatten, mit denen die Technologiebranche heute konfrontiert ist. Weiße Menschen sind größtenteils diejenigen, die KI-Modelle entwickeln, und sie sind keineswegs die Hauptopfer einer tief verwurzelten technologischen Voreingenommenheit.