Während seines Medizinstudiums an der UC San Francisco wuchs Dereck Paul besorgt darüber, dass die Innovation in der medizinischen Software hinter anderen Sektoren wie dem Finanzwesen und der Luft- und Raumfahrt zurückblieb. Er kam zu der Überzeugung, dass den Patienten am besten gedient ist, wenn Ärzte mit Software ausgestattet sind, die den neuesten Stand der Technik widerspiegelt, und träumte davon, ein Unternehmen zu gründen, das die Bedürfnisse von Patienten und Ärzten Vorrang vor Krankenhausverwaltungen oder Versicherungsgesellschaften einräumt.

Also tat sich Paul mit Graham Ramsey, seinem Freund und Ingenieur bei Modern Fertility, dem Technologieunternehmen für Frauengesundheit, zusammen, um das Unternehmen zu gründen Glasgesundheit im Jahr 2021. Glass Health stellt ein Notizbuch zur Verfügung, mit dem Ärzte ihre Ansätze zur Diagnose und Behandlung von Erkrankungen im Laufe ihrer Karriere speichern, organisieren und teilen können; Ramsey beschreibt es als „persönliches Wissensmanagementsystem“ zum Erlernen und Praktizieren von Medizin.

„Während der Pandemie haben Ramsey und ich die überwältigende Belastung unseres Gesundheitssystems und die sich verschärfende Burnout-Krise bei Gesundheitsdienstleistern erlebt“, sagte Paul. „Als Medizinstudent im Krankenhauswechsel und später als Assistenzarzt für Innere Medizin am Brigham and Women’s Hospital erlebte ich das Anbieter-Burnout aus erster Hand. Unser Einfühlungsvermögen für Anbieter an vorderster Front hat uns dazu bewogen, ein Unternehmen zu gründen, das sich der umfassenden Nutzung von Technologie zur Verbesserung der medizinischen Praxis verschrieben hat.“

Glass Health erlangte in den sozialen Medien, insbesondere X (ehemals Twitter), bei Ärzten, Krankenschwestern und angehenden Ärzten schon früh Anklang, und dies führte zur ersten Finanzierungstranche des Unternehmens, einer von Breyer Capital angeführten Pre-Seed-Runde in Höhe von 1,5 Millionen US-Dollar im Jahr 2022 Glass Health wurde dann in die Winter-2023-Charge von Y Combinator aufgenommen. Aber Anfang dieses Jahres, Paul und Ramsey beschloss, das Unternehmen auf generative KI umzustellen und damit dem wachsenden Trend Rechnung zu tragen.

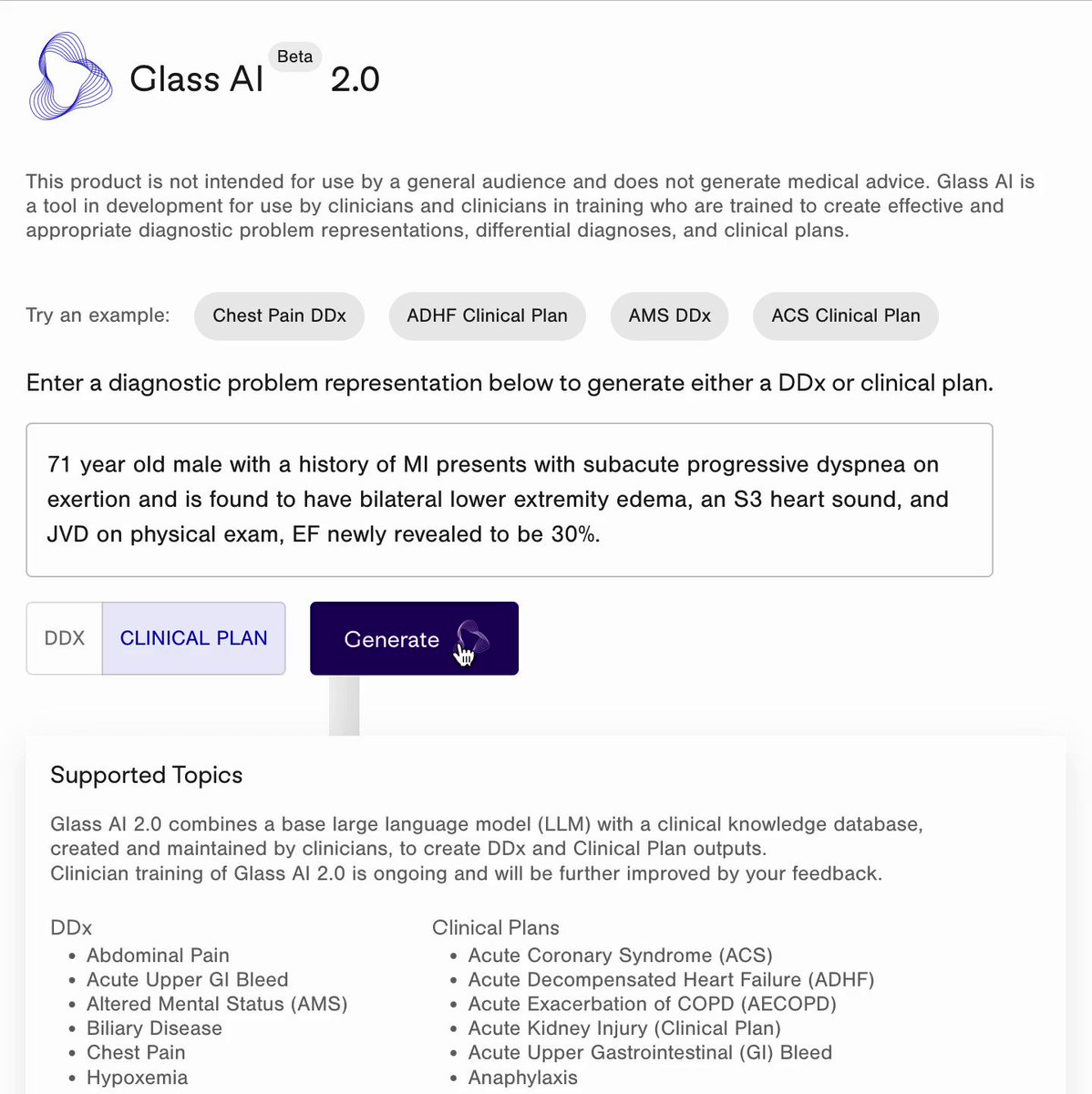

Glass Health bietet jetzt ein KI-Tool an, das auf einem großen Sprachmodell (LLM) basiert, einer Technologie, die der hinter ChatGPT von OpenAI ähnelt, um Diagnosen und „evidenzbasierte“ Behandlungsoptionen zu erstellen, die für Patienten in Betracht gezogen werden können. Ärzte können Beschreibungen eingeben wie „71-jähriger Mann mit einer Vorgeschichte von Myokardinfarkten mit subakut fortschreitender Dyspnoe bei Belastung“ oder „65-jährige Frauen mit einer Vorgeschichte von Diabetes und Hyperlipidämie stellen sich mit akuten Brustschmerzen vor.“ Diaphorese“, und die KI von Glass Health wird eine wahrscheinliche Prognose und einen klinischen Plan liefern.

„Ärzte geben eine Patientenzusammenfassung, auch Problemdarstellung genannt, ein, die die relevanten demografischen Daten, die medizinische Vorgeschichte, Anzeichen und Symptome sowie Beschreibungen von Labor- und Radiologiebefunden im Zusammenhang mit der Vorstellung eines Patienten beschreibt – die Informationen, die sie verwenden könnten, um einen Patienten vorzustellen.“ ein anderer Kliniker“, erklärte Paul. „Glass analysiert die Patientenzusammenfassung und empfiehlt fünf bis zehn Diagnosen, die der Arzt möglicherweise in Betracht ziehen und weiter untersuchen möchte.“

Glass Health kann auch einen Absatz zur Fallbewertung verfassen, der von Ärzten überprüft werden kann und Erläuterungen zu möglicherweise relevanten diagnostischen Studien enthält. Diese Erklärungen können bearbeitet und später für klinische Notizen und Aufzeichnungen verwendet oder mit der breiteren Glass Health-Community geteilt werden.

Theoretisch scheint das Tool von Glass Health unglaublich nützlich zu sein. Aber selbst hochmoderne LLMs haben sich als außerordentlich schlecht darin erwiesen, Gesundheitsratschläge zu geben.

Babylon Health, ein KI-Startup, das vom britischen National Health Service unterstützt wird, steht wiederholt in der Kritik, weil es behauptet, seine Technologie zur Krankheitsdiagnose könne bessere Leistungen erbringen als Ärzte.

In einem unglücklichen Experiment hat die National Eating Disorders Association (NEDA) gestartet ein Chatbot in Zusammenarbeit mit dem KI-Startup Cass, um Menschen mit Essstörungen zu unterstützen. Als Ergebnis eines generativen KI-System-Upgrades begann Cass, schädliche „Diätkultur“-Vorschläge wie Kalorieneinschränkungen nachzuplappern, was dazu führte, dass NEDA das Tool abschaltete.

An anderer Stelle, Health News kürzlich rekrutiert ein medizinischer Fachmann, der die Stichhaltigkeit der Gesundheitsratschläge von ChatGPT in einem breiten Themenspektrum beurteilt. Der Experte stellte fest, dass der Chatbot aktuelle Studien ignorierte, irreführende Aussagen machte (z. B. dass „Wein Krebs vorbeugen könnte“ und dass Prostatakrebs-Screenings auf „persönlichen Werten“ basieren sollten) und Inhalte aus mehreren Gesundheitsnachrichtenquellen plagiierte.

In einer wohltätigeren Form Stück In Stat News fanden ein wissenschaftlicher Mitarbeiter und zwei Harvard-Professoren heraus, dass ChatGPT in 39 von 45 verschiedenen Vignetten die richtige Diagnose (innerhalb der ersten drei Optionen) auflistete. Die Forscher gaben jedoch zu bedenken, dass es sich bei den Vignetten um die Art handelte, die normalerweise zur Prüfung von Medizinstudenten verwendet wird, und dass sie möglicherweise nicht widerspiegeln, wie Menschen – insbesondere diejenigen, für die Englisch eine Zweitsprache ist – ihre Symptome in der realen Welt beschreiben.

Es wurde nicht viel untersucht. Aber ich frage mich, ob auch Voreingenommenheit eine Rolle dabei spielen könnte, dass ein LLM einen Patienten falsch diagnostiziert. Da medizinische LLMs wie Glass oft auf Gesundheitsakten geschult sind, die nur zeigen, was Ärzten und Krankenschwestern auffallen (und nur bei Patienten, die es sich leisten können, sie zu sehen), könnten sie gefährliche blinde Flecken haben, die nicht sofort erkennbar sind. Darüber hinaus verschlüsseln Ärzte möglicherweise unabsichtlich ihre eigenen rassischen, geschlechtsspezifischen oder sozioökonomischen Vorurteile in den Aufzeichnungen, anhand derer LLMs trainieren, was dazu führt, dass die Modelle bestimmte Bevölkerungsgruppen gegenüber anderen priorisieren.

Paul schien sich der kritischen Auseinandersetzung mit generativer KI in der Medizin durchaus bewusst zu sein – und behauptete, dass die KI von Glass Health vielen bereits auf dem Markt befindlichen Lösungen überlegen sei.

Bildnachweis: Glasgesundheit

„Glass verbindet LLMs mit klinischen Leitlinien, die von unserem akademischen Ärzteteam erstellt und begutachtet werden“, sagte er. „Die Mitglieder unseres Ärzteteams stammen aus großen akademischen medizinischen Zentren im ganzen Land und arbeiten Teilzeit für Glass Health, wie sie es für eine medizinische Fachzeitschrift tun würden. Sie erstellen Richtlinien für unsere KI und optimieren die Fähigkeit unserer KI, ihnen zu folgen … Wir fragen unsere Wir bieten den Anwendern von Ärzten die Möglichkeit, alle Ausgaben unserer LLM-Anwendung genau zu überwachen und sie wie einen Assistenten zu behandeln, der ihnen hilfreiche Empfehlungen und Optionen geben kann, die sie in Betracht ziehen können, der aber niemals ihr klinisches Urteilsvermögen anleitet oder ersetzt.“

Im Verlauf unseres Interviews betonte Paul wiederholt, dass die KI von Glass Health – obwohl sie sich auf die Bereitstellung potenzieller Diagnosen konzentriert – in ihren Antworten nicht als endgültig oder präskriptiv interpretiert werden sollte. Hier ist meine Vermutung zum unausgesprochenen Grund: Wenn es so wäre, würde Glass Health einer stärkeren rechtlichen Prüfung unterliegen – und möglicherweise sogar Regulierung durch die FDA.

Paul ist nicht der Einzige, der absichert. Google, das ist testen Ein auf Medizin ausgerichtetes Sprachmodell namens Med-PaLM 2 hat in seinen Marketingmaterialien sorgfältig darauf geachtet, nicht den Eindruck zu erwecken, dass das Modell die Erfahrung von Gesundheitsfachkräften in einem klinischen Umfeld ersetzen könnte. Das gilt auch für Hippocratic, ein Startup, das ein LLM entwickelt, das speziell auf Anwendungen im Gesundheitswesen abgestimmt ist (aber nicht auf Diagnosen).

Dennoch argumentiert Paul, dass der Ansatz von Glass Health ihm eine „feine Kontrolle“ über die Ergebnisse seiner KI gibt und seine KI so anleitet, dass sie „modernste medizinische Erkenntnisse und Richtlinien widerspiegelt“. Ein Teil dieses Ansatzes besteht darin, Benutzerdaten zu sammeln, um die zugrunde liegenden LLMs von Glass zu verbessern – ein Schritt, der möglicherweise nicht bei jedem Patienten gut ankommt.

Paul sagt, dass Nutzer jederzeit die Löschung aller ihrer gespeicherten Daten verlangen können.

„Unsere LLM-Anwendung ruft ärztlich validierte klinische Leitlinien als KI-Kontext zum Zeitpunkt der Ausgabegenerierung ab“, sagte er. „Glass unterscheidet sich von LLMs-Anwendungen wie ChatGPT, die sich ausschließlich auf ihr Vortraining verlassen, um Ergebnisse zu erzeugen, und leichter medizinische Informationen erzeugen können, die ungenau oder veraltet sind … Wir haben eine strenge Kontrolle über die Informationen und Richtlinien, die unsere KI dazu verwendet.“ Erstellen Sie Ergebnisse und die Fähigkeit, einen strengen redaktionellen Prozess auf unsere Richtlinien anzuwenden, der darauf abzielt, Voreingenommenheit zu beseitigen und unsere Empfehlungen mit dem Ziel der gesundheitlichen Chancengleichheit in Einklang zu bringen.“

Wir werden sehen, ob das der Fall sein wird.

In der Zwischenzeit hat Glass Health keine Schwierigkeiten, Erstanwender zu finden. Bis heute hat die Plattform mehr als 59.000 Benutzer gewonnen und verfügt bereits über ein „Direct-to-Clinician“-Angebot für ein monatliches Abonnement. In diesem Jahr wird Glass mit der Pilotierung eines Unternehmensangebots mit integrierter elektronischer Gesundheitsakte und HIPAA-Konformität beginnen. 15 namentlich nicht genannte Gesundheitssysteme und Unternehmen stünden auf der Warteliste, behauptet Paul.

„Institutionen wie Krankenhäuser und Gesundheitssysteme können ihren Ärzten eine Glass-Instanz zur Verfügung stellen, um ihren Ärzten KI-gestützte klinische Entscheidungsunterstützung in Form von Empfehlungen zu Diagnosen, Diagnosestudien und Behandlungsschritten zu ermöglichen, die sie in Betracht ziehen können“, sagte Paul . „Wir sind auch in der Lage, die Ergebnisse von Glass AI an die spezifischen klinischen Richtlinien oder Pflegepraktiken eines Gesundheitssystems anzupassen.“

Mit einer Gesamtfinanzierung von 6,5 Millionen US-Dollar plant Glass, in die Erstellung, Überprüfung und Aktualisierung der von der Plattform verwendeten klinischen Richtlinien durch Ärzte, die KI-Feinabstimmung und allgemeine Forschung und Entwicklung zu investieren. Paul behauptet, dass Glass vier Jahre lang auf dem Laufsteg ist.