A Umfrage unter den führenden KI-Wissenschaftlern sagt, dass die Wahrscheinlichkeit, dass KI unkontrollierbar wird, bei 5 % liegt die Menschheit auslöschen. Forscher gehen davon aus, dass die KI kurzfristig deutlich weiter fortgeschritten sein wird und in der Lage sein wird, vor 2030 einen Top-40-Popsong zu kreieren und einen NYT-Bestseller zu schreiben. Zumindest werden uns unsere KI-Oberherren also unterhalten, bevor sie uns töten.

„Während die Vorhersagen von KI-Experten nicht als verlässlicher Anhaltspunkt für die objektive Wahrheit angesehen werden sollten, können sie einen wichtigen Teil des Puzzles liefern“, sagten Forscher aus Berkeley und der Universität Oxford, die die Studie im Dezember durchgeführt haben. „Ihre Vertrautheit mit der Technologie und der Dynamik ihrer bisherigen Fortschritte versetzt sie in eine gute Position, fundierte Vermutungen über die Zukunft der KI anzustellen.“

Die Umfrage befragte 2.778 Wissenschaftler, die peer-reviewte KI-Studien veröffentlicht hatten, zu ihren Vorhersagen für die Zukunft. Das überwältigende Gefühl? Unsicherheit.

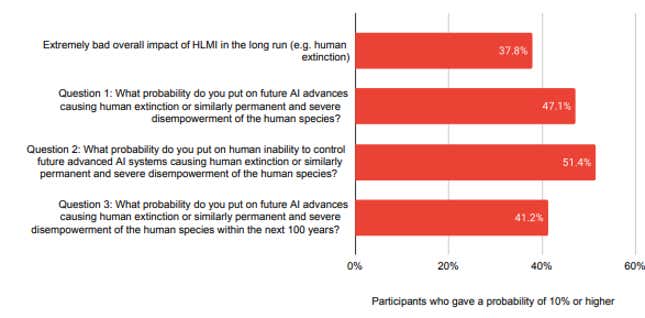

Ungefähr 68 % der Forscher glauben, dass gute Ergebnisse durch übermenschliche KI eher wahrscheinlich als schlecht sind, aber ungefähr die Hälfte dieser Optimisten geht davon aus, dass die Wahrscheinlichkeit des Aussterbens des Menschen nicht bei Null liegt. Die Studie unterstreicht die von den weltweit führenden Forschern wahrgenommene Gefahr bei der Schaffung einer leistungsstarken künstlichen Intelligenz. Es herrschte weitgehend Einigkeit darüber, dass der Forschung zur Minimierung der Risiken der KI mehr Priorität eingeräumt werden sollte, die Forscher waren sich jedoch uneinig darüber, ob der KI-Fortschritt im Allgemeinen beschleunigt oder verlangsamt werden sollte.

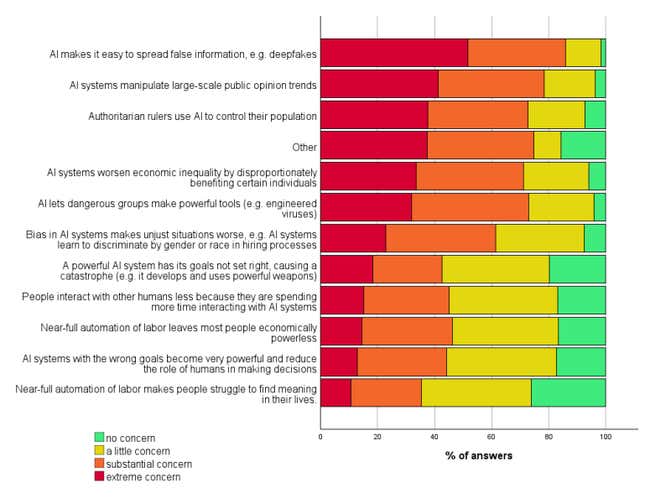

Mehr als 80 % der KI-Forscher äußerten „extreme“ oder „erhebliche“ Bedenken darüber, dass KI die Verbreitung von Fehlinformationen ermöglicht. Eine Mehrheit der Forscher äußerte ähnliche Bedenken hinsichtlich autoritärer Herrscher, die KI zur Kontrolle ihrer Bevölkerung einsetzen, KI-Systemen, die die wirtschaftliche Ungleichheit verschlimmern, und der Rolle von KI bei der Entwicklung manipulierter Viren. Die Umfrage scheint die bislang größte ihrer Art zu sein.

Amerikas führende KI-Entwickler beziehen sich in ihren Leitbildern auf Sicherheit. Im Dezember veröffentlichte OpenAI sein erstes Papier zum Thema Ausrichtung übermenschlicher KI mit menschlichen Werten. Anthropisch hat eine Verfassung hat seine KI-Systeme überarbeitet, um sicherzustellen, dass sie im Einklang mit den Regeln unserer Gesellschaft agieren. Aber funktionieren diese Methoden wirklich mit KI-Modellen, die intelligenter sind als Menschen? Das bleibt abzuwarten, denn die aktuelle KI ist nicht so intelligent.

Die Forscher gaben ihre besten Schätzungen darüber ab, wann die Gesellschaft 39 große KI-Fortschritte erreichen wird. Experten gehen davon aus, dass KI noch vor 2033 in der Lage sein wird, LEGOs zusammenzubauen, neu entdeckte Sprachen zu übersetzen und Videospiele zu entwickeln. Forscher schätzen, dass KI bis 2063 die Arbeit eines Chirurgen oder sogar eines KI-Forschers übernehmen könnte.