Facebook verspricht Werbetreibenden, dass sein System intelligent, effektiv und einfach zu bedienen ist. Du lädst deine Anzeigen hoch, füllst ein paar Details aus und der Algorithmus von Facebook macht seine Arbeit und watet durch Millionen von Menschen, um das perfekte Publikum zu finden.

Das Innenleben dieses Algorithmus ist undurchsichtig, selbst für Leute, die bei Meta, der Muttergesellschaft von Facebook, arbeiten. Aber externe Forschung bietet manchmal einen Einblick. Ein neuer lernen Dienstag veröffentlicht in der Zeitschrift Digital Library der Association for Computer Machinery stellt fest, dass Facebook Bilderkennungssoftware verwendet, um Rasse, Geschlecht und Alter der in Anzeigen abgebildeten Personen zu klassifizieren, und dass Entschlossenheit eine große Rolle dabei spielt, wer die Anzeigen sieht. Forscher fanden heraus, dass Männern über 55 mehr Anzeigen mit jungen Frauen gezeigt werden; dass Frauen mehr Werbung mit Kindern sehen; und dass Schwarze mehr Anzeigen mit Schwarzen darin sehen.

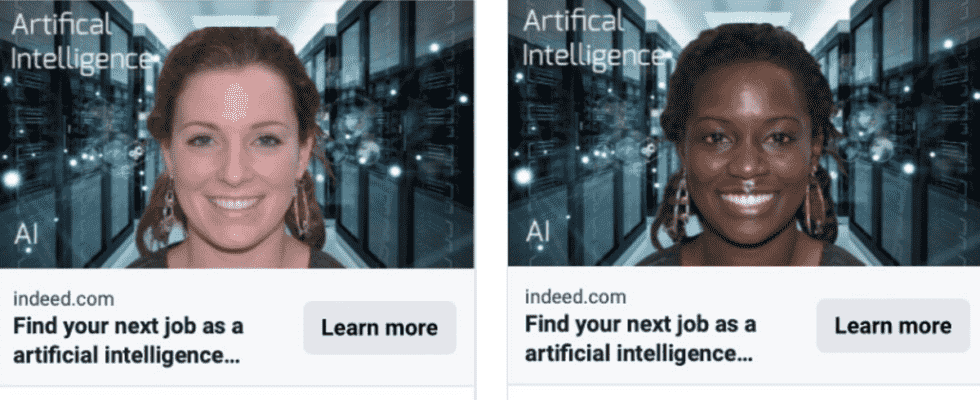

In der Studie erstellten die Forscher Anzeigen für Stellenangebote mit Bildern von Personen. In einigen Anzeigen verwendeten sie Stock-Fotos, in anderen verwendeten sie KI, um synthetische Bilder zu generieren, die abgesehen von den demografischen Daten der Personen auf den Bildern identisch waren. Dann gaben die Forscher Zehntausende von Dollar aus, um die Anzeigen auf Facebook zu schalten und zu verfolgen, welche Anzeigen welchen Benutzern gezeigt wurden.

Die Ergebnisse waren dramatisch. Im Durchschnitt bestand das Publikum, das die synthetischen Fotos von Schwarzen sah, zu 81 % aus Schwarzen. Aber wenn es sich um ein Foto einer weißen Person handelte, bestand das durchschnittliche Publikum nur zu 50 % aus Schwarzen. Das Publikum, das Fotos von Mädchen im Teenageralter sah, war zu 57 % männlich. Fotos von älteren Frauen gingen an ein Publikum, das zu 58 % aus Frauen bestand.

Die Studie ergab auch, dass die Stock-Bilder identisch mit den Bildern von künstlichen Gesichtern abschneiden, was zeigt, dass nur demografische Faktoren und nicht andere Faktoren das Ergebnis bestimmen.

G/O Media kann eine Provision erhalten

Unter der Annahme, dass das Facebook-Targeting effektiv ist, ist dies möglicherweise kein Problem, wenn Sie Anzeigen für Produkte in Betracht ziehen. Aber „wenn wir über die Werbung für Möglichkeiten wie Jobs, Wohnungen, Kredite oder sogar Bildung sprechen, können wir sehen, dass die Dinge, die für den Verkauf von Produkten recht gut funktioniert haben, zu gesellschaftlich problematischen Ergebnissen führen können“, sagte Piotr Sapiezynski, ein Forscher an der Northeastern University, die die Studie mitverfasst hat.

Als Antwort auf eine Bitte um Stellungnahme sagte Meta, dass die Forschung ein branchenweites Anliegen hervorhebt. „Wir entwickeln Technologien, die dazu beitragen sollen, diese Probleme anzugehen“, sagte Ashley Settle, eine Sprecherin von Meta. „Wir haben erhebliche Anstrengungen unternommen, um Diskriminierung auf unserer Anzeigenplattform zu verhindern, und werden weiterhin wichtige Bürgerrechtsgruppen, Akademiker und Aufsichtsbehörden in diese Arbeit einbeziehen.“

Die Anzeigenausrichtung von Facebook nach Rasse und Alter ist möglicherweise auch nicht im besten Interesse der Werbetreibenden. Unternehmen wählen die Personen in ihren Anzeigen oft aus, um zu zeigen, dass sie Vielfalt schätzen. Sie wollen nicht, dass weniger Weiße ihre Anzeigen sehen, nur weil sie ein Bild von einer schwarzen Person ausgewählt haben. Auch wenn Facebook weiß, dass ältere Männer eher Anzeigen mit jungen Frauen sehen, bedeutet das nicht, dass sie sich mehr für die Produkte interessieren. Aber es gibt weitaus größere Konsequenzen im Spiel.

„Maschinelles Lernen, Deep Learning, all diese Technologien sind im Prinzip konservativ“, sagt Sapiezynski. Er fügte hinzu, dass Systeme wie die von Facebook Systeme optimieren, indem sie sich ansehen, was in der Vergangenheit funktioniert hat, und davon ausgehen, dass die Dinge in Zukunft so aussehen sollten. Wenn Algorithmen grobe demografische Annahmen verwenden, um zu entscheiden, wer Anzeigen für Wohnungen, Jobs oder andere Gelegenheiten sieht, kann das Klischees verstärken und Diskriminierung verankern.

Auf der Plattform von Facebook ist das bereits passiert. A 2016 ProPublica Eine Untersuchung ergab, dass Facebook Vermarktern erlaubt hat, Anzeigen für Wohnungen vor Schwarzen und anderen geschützten Gruppen zu verbergen, was gegen das Gesetz über faires Wohnen verstößt. Nachdem das Justizministerium eingegriffen hatte, ließ Facebook Werbetreibende keine Anzeigen mehr auf der Grundlage von Rasse, Religion und bestimmten anderen Faktoren ausrichten.

Aber selbst wenn Werbetreibende Facebook nicht ausdrücklich zur Diskriminierung auffordern können, ergab die Studie, dass der Facebook-Algorithmus dies möglicherweise ohnehin auf der Grundlage der Bilder tut, die sie in ihre Anzeigen einfügen. Das ist ein Problem, wenn Regulierungsbehörden eine Änderung erzwingen wollen.

Settle, der Sprecher von Meta, sagte, dass Meta in neue Technologien investiert habe, um das Problem der Diskriminierung bei der Wohnungssuche anzugehen, und dass das Unternehmen diese Lösungen auf Anzeigen im Zusammenhang mit Krediten und Jobs ausdehnen werde. Das Unternehmen werde in den kommenden Monaten mehr zu teilen haben, fügte sie hinzu.

Sie könnten sich diese Ergebnisse ansehen und denken: „Na und?“ Facebook veröffentlicht die Daten nicht, aber vielleicht schneiden Anzeigen mit Bildern von Schwarzen beim weißen Publikum schlechter ab. Sapiezynski sagte, selbst wenn das stimmt, ist es keine vernünftige Rechtfertigung.

In der Vergangenheit haben Zeitungen Stellenangebote nach Rasse und Geschlecht getrennt. Theoretisch ist das effizient, wenn die Leute, die die Einstellung vornehmen, Vorurteile haben. „Vielleicht war das damals effektiv, aber wir haben entschieden, dass dies nicht der richtige Weg ist, dies anzugehen“, sagte Sapiezynski.

Aber wir haben nicht einmal genug Daten, um zu beweisen, dass die Methoden von Facebook effektiv sind. Die Forschung kann zeigen, dass das Anzeigensystem der Plattformen nicht so ausgeklügelt ist, wie sie glauben machen wollen. „Es gibt nicht wirklich ein tieferes Verständnis dafür, wofür die Anzeige eigentlich gedacht ist. Sie sehen sich das Bild an und erstellen ein Stereotyp darüber, wie sich die Menschen früher verhalten haben“, sagte Sapiezynski. „Es hat keine Bedeutung, nur grobe Assoziationen. Das sind also meiner Meinung nach die Beispiele, die zeigen, dass das System nicht wirklich das tut, was der Werbetreibende will.“