NVIDIA hat gerade enthüllt seine brandneue Hopper H100 NVL-GPU mit 94 GB HBM3-Speicher, die ausschließlich für ChatGPT entwickelt wurde.

NVIDIA kündigt seine erste offizielle ChatGPT-GPU an, die Hopper H100 NVL mit 94 GB HBM3-Speicher

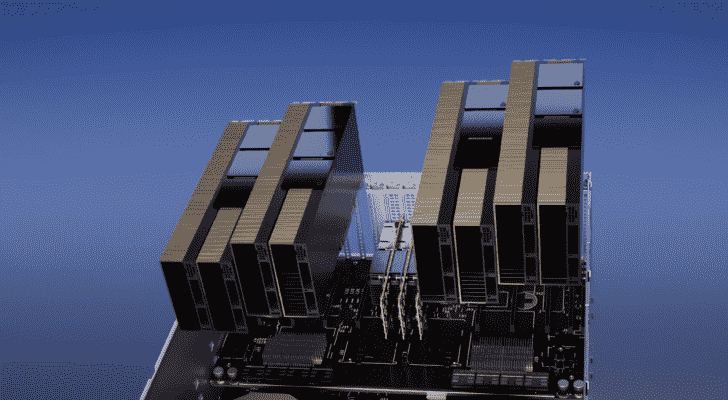

Die NVIDIA Hopper GPU-betriebene H100 NVL PCIe-Grafikkarte soll über eine Dual-GPU-NVLINK-Verbindung verfügen, wobei jeder Chip mit 94 GB HBM3e-Speicher ausgestattet ist. Die GPU kann unterwegs bis zu 175 Milliarden ChatGPT-Parameter verarbeiten. Vier dieser GPUs in einem einzigen Server können im Vergleich zu einem herkömmlichen DGX A100-Server mit bis zu 8 GPUs eine bis zu 10-fache Geschwindigkeit bieten.

Im Gegensatz zur H100 SXM5-Konfiguration bietet die H100 PCIe abgespeckte Spezifikationen mit 114 aktivierten SMs von den vollen 144 SMs der GH100-GPU und 132 SMs auf der H100 SXM. Der Chip als solcher bietet 3200 FP8, 1600 TF16 und 48 TFLOPs FP64-Rechenleistung. Es verfügt auch über 456 Tensor- und Textureinheiten.

Aufgrund seiner geringeren Spitzenleistung bei der Rechenleistung sollte der H100 PCIe mit niedrigeren Taktraten arbeiten und verfügt daher über eine TDP von 350 W im Vergleich zu den doppelten 700 W TDP der SXM5-Variante. Die PCIe-Karte behält jedoch ihren 80-GB-Speicher, der über eine 5120-Bit-Busschnittstelle bereitgestellt wird, jedoch in der HBM2e-Variante (>2 TB/s Bandbreite).

Die Nicht-Tensor-FP32-TFLOPs für den H100 sind mit 48 TFLOPs bewertet, während der MI210 eine Spitzen-FP32-Rechenleistung von 45,3 TFLOPs hat. Mit Sparsity- und Tensor-Operationen kann der H100 bis zu 800 TFLOPs FP32-PS ausgeben. Das H100 rockt auch höhere Speicherkapazitäten von 80 GB gegenüber den 64 GB des MI210. So wie es aussieht, verlangt NVIDIA eine Prämie für seine höheren KI/ML-Fähigkeiten.