Selbst der klügste und raffinierteste Algorithmus der künstlichen Intelligenz wird vermutlich den Gesetzen des Siliziums gehorchen müssen. Seine Fähigkeiten werden durch die Hardware eingeschränkt, auf der es läuft.

Einige Forscher suchen nach Möglichkeiten, diesen Zusammenhang zu nutzen, um das Schadenspotenzial von KI-Systemen zu begrenzen. Die Idee besteht darin, Regeln für das Training und den Einsatz fortschrittlicher Algorithmen direkt in den Computerchips zu kodieren, die für deren Ausführung erforderlich sind.

Theoretisch – in dem Bereich, in dem derzeit viel über gefährlich mächtige KI debattiert wird – könnte dies eine wirkungsvolle neue Möglichkeit sein, Schurkenstaaten oder verantwortungslose Unternehmen daran zu hindern, heimlich gefährliche KI zu entwickeln. Und eines, das schwerer zu umgehen ist als herkömmliche Gesetze oder Verträge. Ein Bericht, der Anfang dieses Monats von der veröffentlicht wurde Zentrum für neue amerikanische Sicherheitein einflussreicher Think Tank für die US-Außenpolitik, skizziert, wie sorgfältig hergestelltes Silizium genutzt werden könnte, um eine Reihe von KI-Kontrollen durchzusetzen.

Einige Chips verfügen bereits über vertrauenswürdige Komponenten, die sensible Daten schützen oder vor Missbrauch schützen sollen. Die neuesten iPhones speichern beispielsweise die biometrischen Informationen einer Person in einem „sichere Enklave.“ Google verwendet a benutzerdefinierter Chip in seinen Cloud-Servern, um sicherzustellen, dass nichts manipuliert wurde.

Das Papier schlägt vor, ähnliche in GPUs integrierte Funktionen zu nutzen – oder neue in zukünftige Chips zu integrieren –, um zu verhindern, dass KI-Projekte ohne Lizenz auf mehr als eine bestimmte Menge an Rechenleistung zugreifen. Da zum Trainieren der leistungsstärksten KI-Algorithmen wie denen hinter ChatGPT eine enorme Rechenleistung erforderlich ist, würde dies einschränken, wer die leistungsstärksten Systeme erstellen kann.

Laut CNAS könnten Lizenzen von einer Regierung oder einer internationalen Regulierungsbehörde ausgestellt und regelmäßig aktualisiert werden, was es ermöglicht, den Zugang zu KI-Schulungen zu sperren, indem man eine neue verweigert. „Sie könnten Protokolle so entwerfen, dass Sie ein Modell nur dann bereitstellen können, wenn Sie eine bestimmte Bewertung durchgeführt und eine Punktzahl über einem bestimmten Schwellenwert erzielt haben – sagen wir aus Sicherheitsgründen“, sagt Tim Fist, Fellow am CNAS und einer von drei Autoren von das Papier.

Einige KI-Koryphäen befürchten, dass KI mittlerweile so intelligent wird, dass sie sich eines Tages als widerspenstig und gefährlich erweisen könnte. Einige Experten und Regierungen befürchten, dass selbst bestehende KI-Modelle die Entwicklung chemischer oder biologischer Waffen oder die Automatisierung von Cyberkriminalität erleichtern könnten. Washington hat bereits eine Reihe von Exportkontrollen für KI-Chips verhängt, um Chinas Zugang zur fortschrittlichsten KI einzuschränken, aus Angst, diese könnte für militärische Zwecke eingesetzt werden – obwohl Schmuggel und clevere Technik dafür gesorgt haben Wege um sie herum. Nvidia lehnte eine Stellungnahme ab, allerdings hat das Unternehmen aufgrund der letzten US-Exportkontrollen Bestellungen im Wert von mehreren Milliarden Dollar aus China verloren.

Laut Fist of CNAS mag die Festschreibung von Einschränkungen in der Computerhardware zwar extrem erscheinen, es gibt jedoch einen Präzedenzfall für die Einrichtung einer Infrastruktur zur Überwachung oder Kontrolle wichtiger Technologien und zur Durchsetzung internationaler Verträge. „Wenn man über Sicherheit und Nichtverbreitung im Nuklearbereich nachdenkt, waren Verifizierungstechnologien für die Gewährleistung von Verträgen von entscheidender Bedeutung“, sagt Fist von CNAS. „Das Netzwerk von Seismometern, über das wir jetzt verfügen, um unterirdische Atomtests aufzuspüren, untermauert Verträge, die besagen, dass wir keine unterirdischen Waffen oberhalb einer bestimmten Kilotonnenschwelle testen dürfen.“

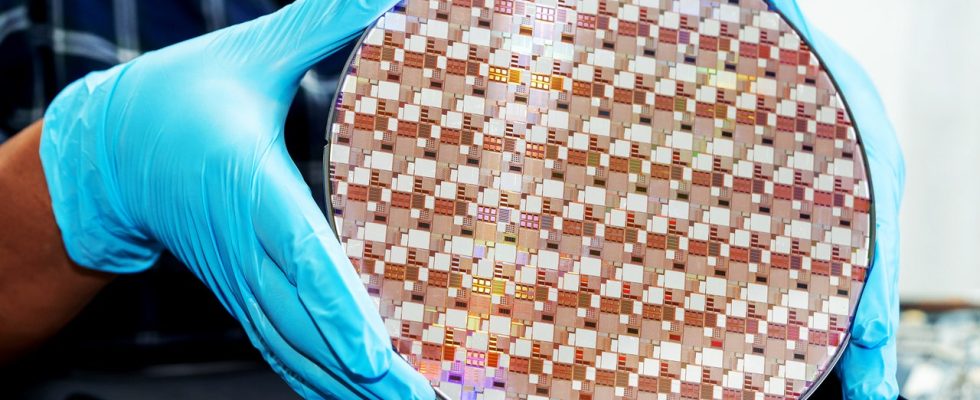

Die von CNAS vorgebrachten Ideen sind nicht völlig theoretisch. Nvidias überaus wichtige KI-Trainingschips – entscheidend für den Bau der leistungsstärksten KI-Modelle – sind bereits im Lieferumfang enthalten sichere kryptografische Module. Und im November 2023 haben Forscher am Institut für die Zukunft des Lebenseine gemeinnützige Organisation, die sich dem Schutz der Menschheit vor existenziellen Bedrohungen widmet, und Mithril-Sicherheitein Sicherheits-Startup, hat eine Demo erstellt, die zeigt, wie das Sicherheitsmodul einer Intel-CPU für ein kryptografisches Schema verwendet werden kann, das die unbefugte Nutzung eines KI-Modells einschränken kann.