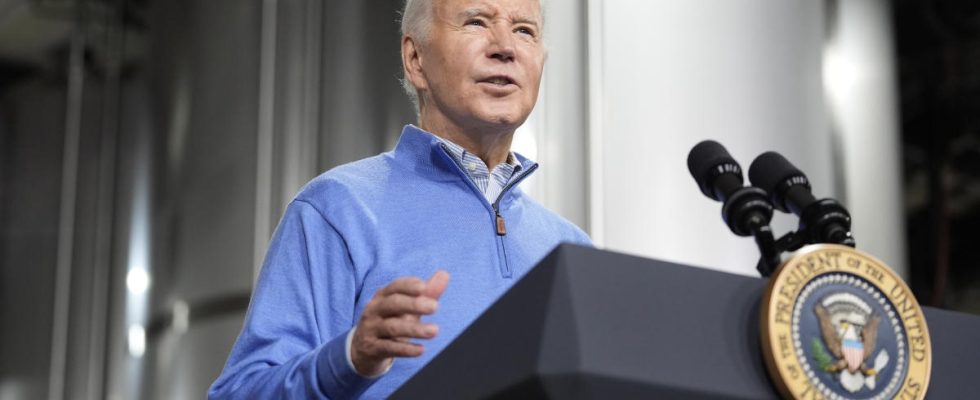

ElevenLabs, ein KI-Startup, das mit seinen Tools Dienste zum Klonen von Stimmen anbietet, hat den Benutzer gesperrt, der einen Audio-Deepfake von Joe Biden erstellt hat, der verwendet wurde, um die Wahlen zu stören Bloomberg. Der Ton, der sich als Präsident ausgab, wurde in einem Robocall verwendet, der letzte Woche an einige Wähler in New Hampshire ging und sie aufforderte, nicht an den Vorwahlen ihres Staates teilzunehmen. Es war zunächst nicht klar, mit welcher Technologie Bidens Stimme kopiert wurde, aber a umfassende Analyse Die Sicherheitsanalyse des Sicherheitsunternehmens Pindrop ergab, dass die Täter die Tools von ElevanLabs nutzten.

Das Sicherheitsunternehmen entfernte die Hintergrundgeräusche und reinigte den Ton des Robocalls, bevor er ihn mit Proben von mehr als 120 Sprachsynthesetechnologien verglich, die zur Generierung von Deepfakes verwendet wurden. Vijay Balasubramaniyan, CEO von Pindrop, sagte Verdrahtet dass es „deutlich über 99 Prozent kam, dass es ElevenLabs war.“ Bloomberg sagt, das Unternehmen sei über die Ergebnisse von Pindrop informiert worden und führe noch Ermittlungen durch, habe aber bereits das Konto identifiziert und gesperrt, das das gefälschte Audio erstellt habe. ElevenLabs teilte der Nachrichtenorganisation mit, dass es sich nicht zu dem Problem selbst äußern könne, sich aber „der Verhinderung des Missbrauchs von Audio-KI-Tools“ verschrieben habe [that it takes] etwaige Missbrauchsvorfälle sind äußerst schwerwiegend.“

Der gefälschte Biden-Robocall zeigt, wie Technologien, die das Abbild und die Stimme einer anderen Person nachahmen können, zur Manipulation von Stimmen bei der bevorstehenden Präsidentschaftswahl in den USA eingesetzt werden könnten. „Das ist sozusagen nur die Spitze des Eisbergs dessen, was im Hinblick auf Wählerunterdrückung oder Angriffe auf Wahlhelfer getan werden könnte“, sagte Kathleen Carley, Professorin an der Carnegie Mellon University Der Hügel. „Es war fast ein Vorbote dessen, was uns in den nächsten Monaten alles Mögliche erwarten würde.“

Es dauerte nur ein paar Tage, nachdem ElevenLabs die Beta-Version seiner Plattform veröffentlicht hatte, um damit Audioclips zu erstellen, die so klingen, als würden Prominente etwas Fragwürdiges lesen oder sagen. Das Startup ermöglicht Kunden die Nutzung seiner Technologie zum Klonen von Stimmen für „künstlerische und politische Reden, die zu öffentlichen Debatten beitragen“. Es ist Sicherheitsseite warnt Benutzer, dass sie „keine Stimme für missbräuchliche Zwecke wie Betrug, Diskriminierung, Hassrede oder für irgendeine Form von Online-Missbrauch klonen können, ohne gegen das Gesetz zu verstoßen.“ Aber es muss klar sein, dass mehr Sicherheitsvorkehrungen getroffen werden müssen, um zu verhindern, dass schlechte Akteure ihre Instrumente nutzen, um Wähler zu beeinflussen und Wahlen auf der ganzen Welt zu manipulieren.

Dieser Artikel enthält Affiliate-Links; Wenn Sie auf einen solchen Link klicken und einen Kauf tätigen, erhalten wir möglicherweise eine Provision.