Cerebras Systems hat enthüllt Sein Wafer-Scale-Engine-Chip der dritten Generation, der WSE-3, bietet 900.000 KI-optimierte Kerne, die für das Training von bis zu 24 Billionen Parametern ausgelegt sind.

Cerebras WSE-3 ist der größte KI-Chip der Welt: Billionen Transistoren zum Trainieren von KI-Modellen mit Billionen Parametern

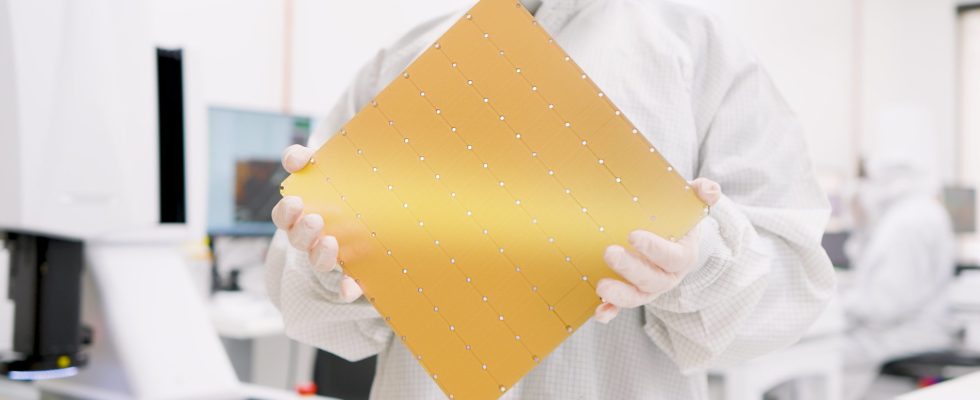

Seit der Einführung seines ersten Wafer Scale Engine (WSE)-Chips hat Cerebras nicht zurückgeschaut und seine Lösung der dritten Generation wurde nun mit unglaublichen Spezifikationen vorgestellt, die aufgrund ihrer schieren Größe eine Selbstverständlichkeit sein sollten. Wie der Name schon sagt, handelt es sich bei dem Chip im Wesentlichen um einen ganzen Wafer aus Silizium, und dieses Mal setzt Cerebras mit einigen leistungsstarken Spezifikationen auf den KI-Trend, die im Folgenden hervorgehoben werden:

- 4 Billionen Transistoren

- 900.000 KI-Kerne

- 125 Petaflops maximale KI-Leistung

- 44 GB auf dem Chip SRAM

- 5-nm-TSMC-Prozess

- Externer Speicher: 1,5 TB, 12 TB, oder 1,2PB

- Trainiert KI-Modelle mit bis zu 24 Billionen Parametern

- Clustergröße von bis zu 2048 CS-3-Systemen

Was den Chip selbst betrifft, so hat der Cerebras WSE-3 eine Chipgröße von 46.225 mm2, was 57-mal größer ist als der NVIDIA H100, der 826 mm2 misst. Beide Chips basieren auf dem TSMC 5-nm-Prozessknoten. Der H100 gilt mit seinen 16.896 Kernen und 528 Tensorkernen als einer der besten KI-Chips auf dem Markt, wird jedoch vom WSE-3 in den Schatten gestellt und bietet unglaubliche 900.000 KI-optimierte Kerne pro Chip, was einer 52-fachen Steigerung entspricht.

Mit einer Speicherbandbreite von 21 Petabyte pro Sekunde (7.000-mal mehr als der H100) und einer Fabric-Bandbreite von 214 Petabit pro Sekunde (3.715-mal mehr als der H100) weist der WSE-3 auch hohe Leistungswerte auf. Der Chip verfügt über 44 GB On-Chip-Speicher, was 880-mal mehr ist als der H100.

Im Vergleich zum WSE-2 bietet der WSE-3-Chip 2,25-mal mehr Kerne (900 KB gegenüber 400 KB), 2,4-mal mehr SRAM (44 GB gegenüber 18 GB) und viel höhere Verbindungsgeschwindigkeiten, und das alles bei gleicher Gehäusegröße. Außerdem gibt es 54 % mehr Transistoren im WSE-3 (4 Billionen gegenüber 2,6 Billionen).

Was ist also der Vorteil dieser ganzen Hardware? Nun, der Chip ist zuerst für KI konzipiert und bietet 125 PetaFlops maximale KI-Leistung. Der NVIDIA H100 bietet etwa 3958 TeraFlops oder etwa 4,0 PetaFlops maximale KI-Leistung, wir sprechen hier also von einer 31,25-fachen Steigerung. Der Chip ist außerdem in einer Reihe externer Speicherkonfigurationen von 1,5 TB, 12 TB und bis zu 1,2 PB erhältlich. Mit so viel Leistung in einem einzigen Chip kann der Chip KI-Modelle mit bis zu 24 Billionen Parametern trainieren.

| WSE-3 | Nvidia H100 | Cerebras-Vorteil | |

| Chipgröße | 46.225 mm² | 826 mm² | 57 X |

| Kerne | 900.000 | 16.896 FP32 + 528 Tensor | 52X |

| On-Chip-Speicher | 44 Gigabyte | 0,05 Gigabyte | 880 X |

| Speicherbandbreite | 21 Petabyte/Sek | 0,003 Petabyte/Sek | 7.000 X |

| Fabric-Bandbreite | 214 Petabits/Sek | 0,0576 Petabits/Sek | 3.715 X |

Zusätzlich zum Wafer-Scale-Engine-Chip WSE-3 kündigt Cerebras Systems auch dessen an CS-3 KI-Supercomputer das dank seines riesigen Speicherpools Modelle trainieren kann, die 10x größer als GPT-4 und Gemini sind. Die CS-3-KI-Lösung ist sowohl für Unternehmens- als auch für Hyperscale-Benutzer konzipiert und bietet im Vergleich zu modernen GPUs eine deutlich höhere Leistungseffizienz.

64 dieser CS-3-KI-Systeme werden zur Stromversorgung verwendet Supercomputer Condor Galaxy 3 Dies bietet 8 ExaFlops KI-Rechenleistung und verdoppelt die Leistung des Systems bei gleicher Leistung und gleichen Kosten. Das Unternehmen hat weder die Preise noch die Verfügbarkeit der WSE-3-Chips bekannt gegeben, aber es wird erwartet, dass sie viel kosten werden, und mit „viel“ meine ich viel mehr als den geforderten Preis von 25.000 bis 30.000 US-Dollar für die NVIDIA H100-GPUs.