Heute Morgen, Pergament.ai sagte, es habe eine 5-Millionen-Dollar-Seed-Runde abgeschlossen. Das Unternehmen lehnte es ab, mitzuteilen, wer sein Hauptinvestor für die Runde war, abgesehen davon, dass es sich um ein mehrstufiges Unternehmen handelte, teilte es TechCrunch jedoch mit, dass Rebel Fund, Eastlink Capital, Pioneer Fund, Y Combinator und mehrere Angels an der Runde teilgenommen hätten.

Das Startup erregte TechCrunchs Aufmerksamkeit erstmals während des letzten Demo-Tages von Y Combinator (Winter 2023), da es sich darauf konzentrierte, Unternehmen bei der Verbesserung ihrer generativen KI-Eingabeaufforderungen zu unterstützen. Angesichts der Anzahl generativer KI-Modelle, ihrer schnellen Fortschritte und der Anzahl von Unternehmenskategorien, die bereit zu sein scheinen, große Sprachmodelle (LLMs) zu nutzen, gefiel uns der Fokus.

Laut Kennzahlen, die Vellum mit TechCrunch geteilt hat, gefällt dem Markt auch, was das Startup aufbaut. Entsprechend Akash SharmaCEO und Mitbegründer von Vellum, hat das Startup heute 40 zahlende Kunden, wobei der Umsatz um etwa 25 bis 30 % pro Monat steigt.

Für ein Unternehmen, das im Januar dieses Jahres gegründet wurde, ist das beeindruckend.

Normalerweise würde ich bei einem kurzen Finanzierungsupdate dieser Art ein wenig Zeit damit verbringen, das Unternehmen und sein Produkt im Detail zu beschreiben, mich auf das Wachstum zu konzentrieren und dann weiterzumachen. Da wir jedoch gerade über etwas sprechen, das noch am Anfang steht, nehmen wir uns die Zeit, etwas allgemeiner über Prompt Engineering zu sprechen.

Baupergament

Sharma erzählte mir, dass er und seine Mitbegründer (Noa Flaherty und Sidd Seethepalli) Angestellte bei waren Doverein weiteres Y-Combinator-Unternehmen aus der Ära 2019, das Anfang 2020 mit GPT 3 arbeitete, als die Betaversion veröffentlicht wurde.

Während ihrer Zeit in Dover entwickelten sie generative KI-Anwendungen zum Schreiben von Rekrutierungs-E-Mails, Stellenbeschreibungen und Ähnlichem, stellten jedoch fest, dass sie zu viel Zeit mit ihren Eingabeaufforderungen verbrachten und die Eingabeaufforderungen in der Produktion weder versionieren noch deren Qualität messen konnten. Sie mussten daher auch Tools für die Feinabstimmung und semantische Suche entwickeln. Die schiere Menge an Handarbeit summierte sich, sagte Sharma.

Das bedeutete, dass das Team Zeit für die Entwicklung interner Werkzeuge aufwendete, anstatt für den Endbenutzer zu bauen. Dank dieser Erfahrung und dem Hintergrund des maschinellen Lernens erkannten seine beiden Mitbegründer bei der Veröffentlichung von ChatGPT im letzten Jahr, dass die Marktnachfrage nach Werkzeugen zur Verbesserung der generativen KI-Eingabeaufforderung „exponentiell wachsen würde“. Daher Pergament.

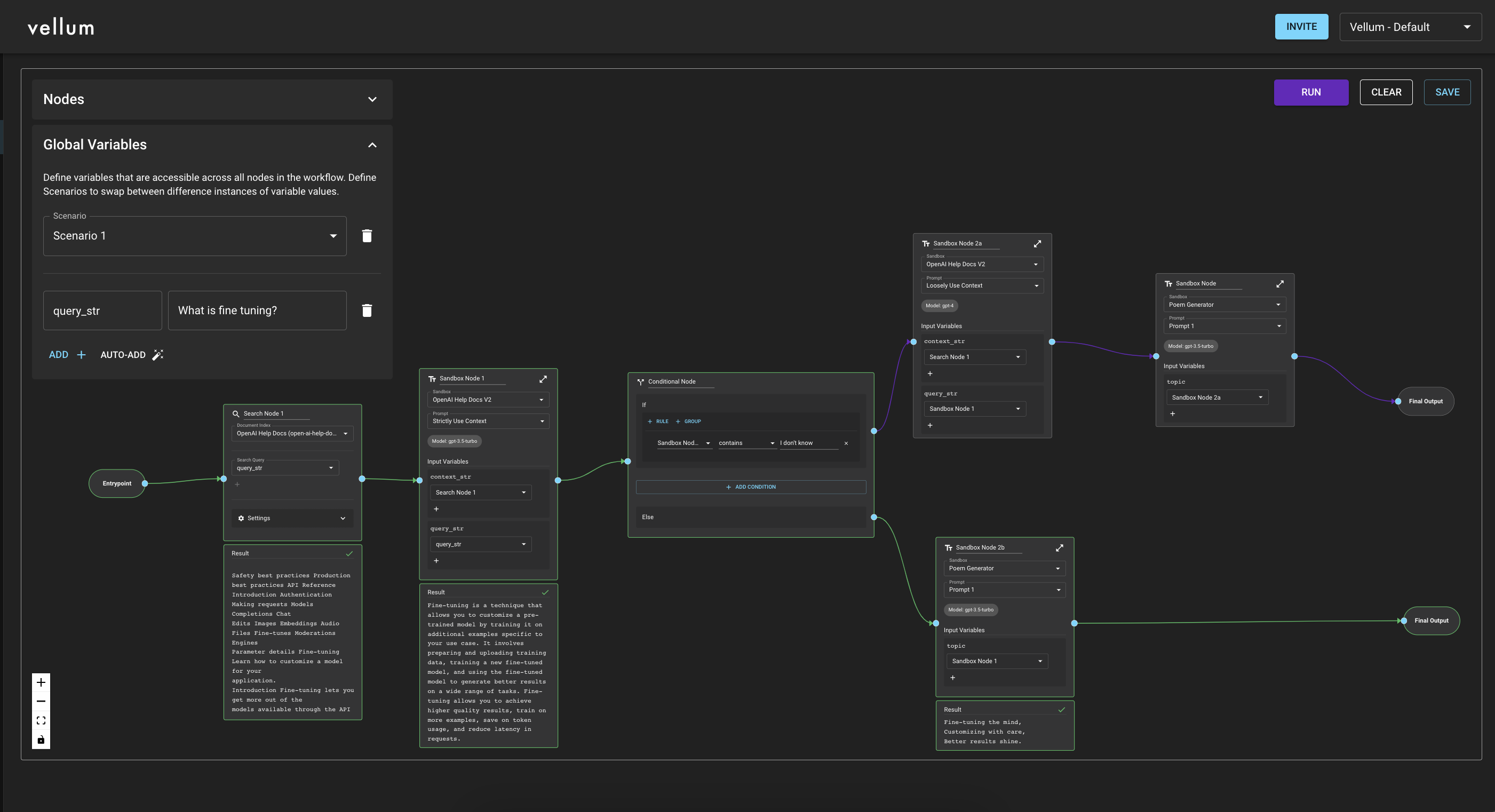

LLM-Workflows innerhalb von Vellum. Bildnachweis: Pergament

Zu sehen, dass ein Markt neue Möglichkeiten für den Werkzeugbau eröffnet, ist nichts Neues, aber moderne LLMs könnten nicht nur den KI-Markt selbst verändern, sondern ihn auch vergrößern. Sharma erzählte mir, dass es bis zur Veröffentlichung der kürzlich veröffentlichten LLMs „nie möglich war, natürliche Sprache zu verwenden“. [prompts] um Ergebnisse aus einem KI-Modell zu erhalten.“ Die Umstellung auf die Annahme natürlicher Spracheingaben „macht das [AI] Sie können einen viel größeren Markt vermarkten, weil Sie einen Produktmanager oder einen Softwareentwickler haben können […] Im wahrsten Sinne des Wortes ist jeder ein schneller Ingenieur.“

Mehr Leistung in mehr Händen bedeutet einen größeren Bedarf an Werkzeugen. Zu diesem Thema bietet Vellum eine Möglichkeit für KI-Prompter, Modellausgaben nebeneinander zu vergleichen, die Möglichkeit, nach unternehmensspezifischen Daten zu suchen, um Kontext zu bestimmten Eingabeaufforderungen hinzuzufügen, und andere Tools wie Tests und Versionskontrolle, die Unternehmen gefallen könnten um sicherzustellen, dass ihre Eingabeaufforderungen die richtigen Informationen ausspucken.

Aber wie schwierig kann es sein, einen LLM zu veranlassen? Sharma sagte: „Es ist einfach, einen LLM-gestützten Prototyp zu entwickeln und auf den Markt zu bringen, aber wenn Unternehmen am Ende so etwas nehmen [that] In Bezug auf die Produktion stellen sie fest, dass es viele Grenzfälle gibt, die tendenziell seltsame Ergebnisse liefern.“ Kurz gesagt: Wenn Unternehmen wollen, dass ihre LLMs dauerhaft gut sind, müssen sie mehr Arbeit leisten, als nur GPT-Ausgaben zu bearbeiten, die aus Benutzeranfragen stammen.

Dennoch ist das etwas allgemein gehalten. Wie nutzen Unternehmen verfeinerte Eingabeaufforderungen in Anwendungen, die eine schnelle Entwicklung erfordern, um sicherzustellen, dass ihre Ausgaben gut abgestimmt sind?

Zur Erklärung verwies Sharma auf ein Support-Ticketing-Softwareunternehmen, das auf Hotels abzielt. Dieses Unternehmen wollte eine Art LLM-Agent aufbauen, der Fragen beantworten konnte wie: „Können Sie eine Reservierung für mich vornehmen?“

Zunächst war eine Eingabeaufforderung erforderlich, die als Eskalationsklassifizierer fungierte, um zu entscheiden, ob die Frage von einer Person oder dem LLM beantwortet werden sollte. Wenn das LLM die Frage beantworten würde, sollte das Modell dann – wir erweitern das Beispiel hier allein – in der Lage sein, dies korrekt zu tun, ohne zu halluzinieren oder aus der Bahn zu geraten.

LLMs können also miteinander verkettet werden, um eine Art Logik zu schaffen, die sie durchzieht. Prompt Engineering bedeutet also nicht einfach, mit LLMs herumzuspielen, um sie dazu zu bringen, etwas Skurriles zu tun. Aus unserer Sicht ähnelt es eher der Programmierung in natürlicher Sprache. Es wird ein eigenes Tooling-Framework benötigen, ähnlich wie bei anderen Formen der Programmierung.

Wie groß ist der Markt?

TechCrunch+ hat untersucht, warum Unternehmen davon ausgehen, dass der Markt für generative KI für Unternehmen immens wachsen wird. Es dürfte viele Bergleute (Kunden) geben, die Spitzhacken und Schaufeln (prompte Engineering-Tools) benötigen, um generative KI optimal nutzen zu können.

Vellum lehnte es ab, seine Preisgestaltung preiszugeben, stellte jedoch fest, dass die Kosten für seine Dienstleistungen im drei- bis vierstelligen Bereich pro Monat liegen. Gekreuzt mit mehr als drei Dutzend Kunden ergibt das für Vellum eine ziemlich gute Erfolgsquote für ein Unternehmen im Seed-Stadium. Ein schneller Anstieg der Nachfrage korreliert tendenziell mit der Marktgröße, daher kann man mit Recht sagen, dass tatsächlich eine starke Unternehmensnachfrage nach LLMs besteht.

Das sind gute Nachrichten für die große Zahl an Unternehmen, die LLMs aufbauen, implementieren oder unterstützen. Wenn man bedenkt, wie viele Start-ups es in dieser Mischung gibt, blicken wir auf strahlende, sonnige Tage.